Sztuczna inteligencja zmieniła zasady gry w wielu dziedzinach, od opieki zdrowotnej, przez handel detaliczny, po rozrywkę i sztukę. Nowe badania sugerują jednak, że być może osiągnęliśmy punkt krytyczny: Sztuczna inteligencja uczy się z treści generowanych przez sztuczną inteligencję.

Ten ouroboros sztucznej inteligencji – wąż zjadający własny ogon – może skończyć się bardzo źle. Grupa badawcza z różnych uniwersytetów w Wielkiej Brytanii wydała ostrzeżenie przed tym, co nazwali „upadkiem modelu”, degeneracyjnym procesem, który może całkowicie oddzielić sztuczną inteligencję od rzeczywistości.

W artykule zatytułowanym „The Curse of Recursion: Training on Generated Data Makes Models Forget”, naukowcy z uniwersytetów w Cambridge i Oksfordzie, Uniwersytetu w Toronto i Imperial College w Londynie wyjaśniają, że załamanie modelu następuje, gdy „wygenerowane dane zanieczyszczają zestaw treningowy następnej generacji modeli”.

„Będąc szkolonymi na zanieczyszczonych danych, błędnie postrzegają rzeczywistość” – napisali.

Innymi słowy, szeroko rozpowszechnione treści generowane przez sztuczną inteligencję publikowane w Internecie mogą być zasysane z powrotem do systemów sztucznej inteligencji, prowadząc do zniekształceń i nieścisłości.

Problem ten został wykryty w wielu wyuczonych modelach generatywnych i narzędziach, w tym w dużych modelach językowych (LLM), wariacyjnych autoenkoderach i gaussowskich modelach mieszanych. Z biegiem czasu modele zaczynają „zapominać o prawdziwym rozkładzie danych”, co prowadzi do niedokładnych reprezentacji rzeczywistości, ponieważ oryginalne informacje stają się tak zniekształcone, że przestają przypominać rzeczywiste dane.

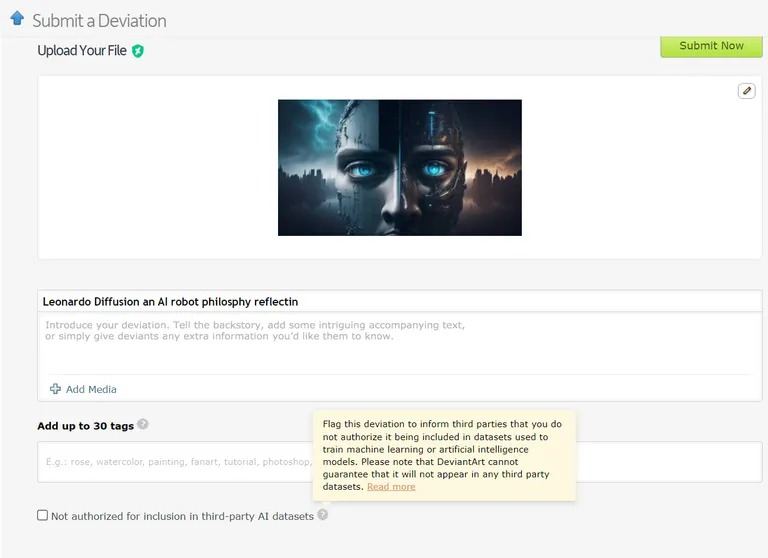

Istnieją już przypadki, w których modele uczenia maszynowego są szkolone na danych generowanych przez sztuczną inteligencję. Na przykład modele uczenia się języka (LLM) są celowo szkolone na danych wyjściowych z GPT-4. Podobnie DeviantArt, platforma internetowa dla artystów, umożliwia publikowanie dzieł sztuki stworzonych przez sztuczną inteligencję i wykorzystywanie ich jako danych szkoleniowych dla nowszych modeli sztucznej inteligencji.

Image: Devianart

Podobnie jak próba kopiowania lub klonowania czegoś w nieskończoność, praktyki te, zdaniem naukowców, mogą prowadzić do większej liczby przypadków załamania modelu.

Biorąc pod uwagę poważne konsekwencje załamania modelu, dostęp do oryginalnej dystrybucji danych ma kluczowe znaczenie. Modele sztucznej inteligencji potrzebują prawdziwych, wytworzonych przez człowieka danych, aby dokładnie zrozumieć i symulować nasz świat.

Jak zapobiegać upadkowi modeli

Według artykułu badawczego istnieją dwie główne przyczyny załamania modeli. Pierwszą z nich jest „statystyczny błąd aproksymacji”, który jest związany ze skończoną liczbą próbek danych. Drugą jest „funkcjonalny błąd aproksymacji”, który wynika z nieprawidłowo skonfigurowanego marginesu błędu wykorzystywanego podczas szkolenia sztucznej inteligencji. Błędy te mogą narastać z pokolenia na pokolenie, powodując kaskadowy efekt pogarszających się nieścisłości.

Artykuł przedstawia „przewagę pierwszego gracza” w szkoleniu modeli sztucznej inteligencji. Jeśli uda nam się zachować dostęp do oryginalnego źródła danych wygenerowanych przez człowieka, możemy zapobiec szkodliwej zmianie dystrybucji, a tym samym załamaniu modelu.

Rozróżnianie treści generowanych przez sztuczną inteligencję na dużą skalę jest jednak trudnym wyzwaniem, które może wymagać koordynacji w całej społeczności.

Ostatecznie znaczenie integralności danych i wpływu ludzkich informacji na sztuczną inteligencję jest tylko tak dobre, jak dane, z których pochodzą, a eksplozja treści generowanych przez sztuczną inteligencję może okazać się mieczem obosiecznym dla branży. To „garbage in, garbage out” – AI oparta na treściach AI doprowadzi do powstania wielu bardzo inteligentnych, ale „urojonych” maszyn.

Co powiesz na ironiczny zwrot akcji? Nasze maszynowe potomstwo, ucząc się więcej od siebie nawzajem niż od nas, staje się „urojone”. Następnie będziemy musieli poradzić sobie z urojeniowym, dorastającym ChatGPT.