Künstliche Intelligenz hat zahlreiche Bereiche verändert, vom Gesundheitswesen über den Einzelhandel bis hin zu Unterhaltung und Kunst. Neue Forschungsergebnisse legen jedoch nahe, dass wir einen Wendepunkt erreicht haben könnten: KI lernt von KI-generierten Inhalten.

Dieser KI-Ouroboros – eine Schlange, die ihren eigenen Schwanz frisst – könnte ziemlich schlimm enden. Eine Forschergruppe verschiedener Universitäten im Vereinigten Königreich warnt vor dem so genannten „Modellkollaps“, einem degenerativen Prozess, der die KI vollständig von der Realität trennen könnte.

In einem Papier mit dem Titel „The Curse of Recursion: Training on Generated Data Makes Models Forget“ (Training auf generierten Daten lässt Modelle vergessen) erklären Forscher der Universitäten Cambridge und Oxford, der Universität Toronto und des Imperial College in London, dass ein Modellkollaps eintritt, wenn „generierte Daten am Ende die Trainingsmenge der nächsten Generation von Modellen verschmutzen“.

„Da sie mit verunreinigten Daten trainiert wurden, nehmen sie die Realität falsch wahr“, schreiben sie.

Mit anderen Worten: Die weit verbreiteten Inhalte, die von der KI generiert und online veröffentlicht werden, könnten in die KI-Systeme zurückgesaugt werden und zu Verzerrungen und Ungenauigkeiten führen.

Dieses Problem wurde bei einer Reihe von gelernten generativen Modellen und Tools festgestellt, darunter Large Language Models (LLMs), Variational Autoencoders und Gaussian Mixture Models. Mit der Zeit beginnen die Modelle, die tatsächliche Datenverteilung zu vergessen, was zu ungenauen Darstellungen der Realität führt, weil die ursprünglichen Informationen so verzerrt werden, dass sie nicht mehr den realen Daten ähneln.

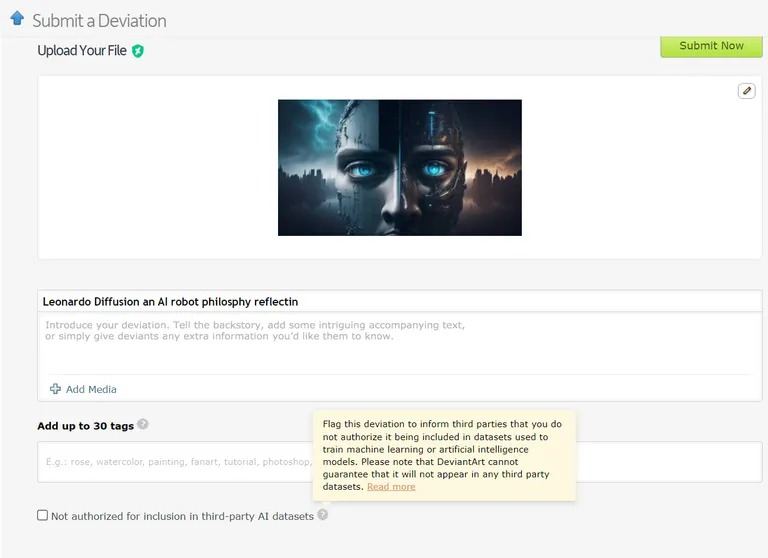

Es gibt bereits Fälle, in denen Modelle für maschinelles Lernen auf KI-generierten Daten trainiert werden. So werden beispielsweise Sprachlernmodelle (LLMs) absichtlich mit den Ergebnissen des GPT-4 trainiert. Auch auf DeviantArt, der Online-Plattform für Künstler, können von KI geschaffene Kunstwerke veröffentlicht und als Trainingsdaten für neuere KI-Modelle verwendet werden

Bild: Devianart

Ähnlich wie der Versuch, etwas auf unbestimmte Zeit zu kopieren oder zu klonen, könnten diese Praktiken den Forschern zufolge zu mehr Fällen von Modellzusammenbruch führen.

Angesichts der schwerwiegenden Folgen eines Modellzusammenbruchs ist der Zugang zur ursprünglichen Datenverteilung entscheidend. KI-Modelle benötigen reale, von Menschen produzierte Daten, um unsere Welt genau zu verstehen und zu simulieren.

Verhindern von Modellzusammenbrüchen

Es gibt zwei Hauptursachen für den Zusammenbruch von Modellen, so das Forschungspapier. Die erste ist der „statistische Approximationsfehler“, der mit der endlichen Anzahl von Datenproben zusammenhängt. Die zweite Ursache ist der „funktionale Approximationsfehler“, der darauf zurückzuführen ist, dass die beim KI-Training verwendete Fehlerspanne nicht richtig konfiguriert ist. Diese Fehler können sich über Generationen hinweg summieren und einen Kaskadeneffekt mit zunehmender Ungenauigkeit auslösen.

In dem Papier wird ein „First-Mover-Vorteil“ für das Training von KI-Modellen formuliert. Wenn wir den Zugriff auf die ursprüngliche, vom Menschen erzeugte Datenquelle aufrechterhalten können, können wir eine nachteilige Verteilungsverschiebung und damit einen Zusammenbruch des Modells verhindern.

Die Unterscheidung von KI-generierten Inhalten in großem Maßstab ist jedoch eine gewaltige Herausforderung, die möglicherweise eine gemeinschaftsweite Koordination erfordert.

Letztendlich sind die Bedeutung der Datenintegrität und der Einfluss menschlicher Informationen auf die KI nur so gut wie die Daten, aus denen sie stammen, und die explosionsartige Zunahme von KI-generierten Inhalten könnte sich als zweischneidiges Schwert für die Branche erweisen. Nach dem Motto „Garbage in, garbage out“ wird KI, die auf KI-Inhalten basiert, zu vielen sehr intelligenten, aber „wahnhaften“ Maschinen führen.

Was ist das für eine ironische Wendung der Geschichte? Unser Maschinennachwuchs, der mehr voneinander als von uns lernt, wird „wahnhaft“. Als Nächstes werden wir es mit einem wahnhaften, pubertären ChatGPT zu tun haben