La inteligencia artificial ha cambiado las reglas del juego en numerosos campos, desde la sanidad al comercio minorista, pasando por el entretenimiento y el arte. Sin embargo, nuevas investigaciones sugieren que podríamos haber llegado a un punto de inflexión: La IA aprende de los contenidos generados por ella.

Este ouroboros de la IA -una serpiente que se come su propia cola- podría acabar muy mal. Un grupo de investigación de distintas universidades del Reino Unido ha lanzado una advertencia sobre lo que denominan «colapso del modelo», un proceso degenerativo que podría separar por completo la IA de la realidad.

En un artículo titulado «The Curse of Recursion: Training on Generated Data Makes Models Forget», investigadores de las universidades de Cambridge y Oxford, la Universidad de Toronto y el Imperial College de Londres explican que el colapso de modelos se produce cuando «los datos generados acaban contaminando el conjunto de entrenamiento de la siguiente generación de modelos».

«Al ser entrenados con datos contaminados, perciben erróneamente la realidad», escriben.

En otras palabras, el contenido generalizado generado por la IA que se publica en Internet podría ser absorbido por los sistemas de IA, lo que provocaría distorsiones e imprecisiones.

Este problema se ha detectado en una serie de herramientas y modelos generativos aprendidos, como los modelos de lenguaje amplio (LLM), los autocodificadores variacionales y los modelos de mezclas gaussianas. Con el tiempo, los modelos empiezan a «olvidar la verdadera distribución de datos subyacente», lo que da lugar a representaciones inexactas de la realidad porque la información original se distorsiona tanto que deja de parecerse a los datos del mundo real.

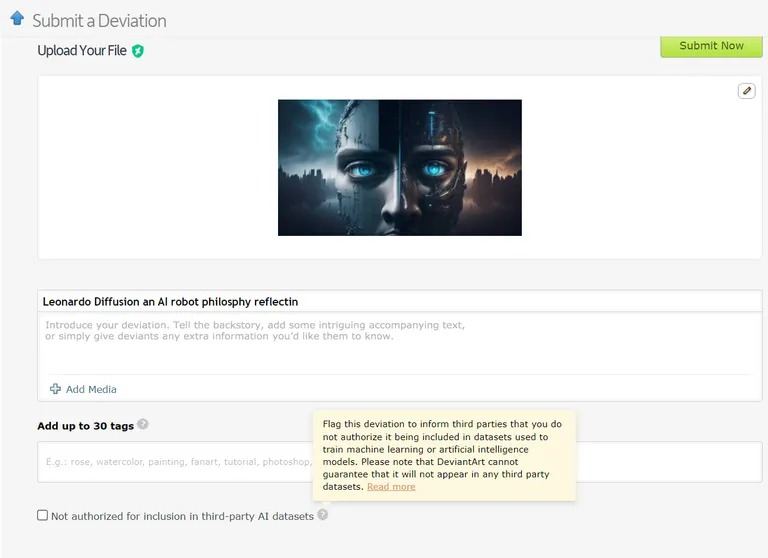

Ya hay casos en los que los modelos de aprendizaje automático se entrenan con datos generados por IA. Por ejemplo, los modelos de aprendizaje del lenguaje (LLM) se están entrenando intencionadamente con los resultados de la GPT-4. Del mismo modo, DeviantArt, la plataforma en línea para artistas, permite publicar obras de arte creadas con IA y utilizarlas como datos de entrenamiento para nuevos modelos de IA.

Imagen: Devianart

Al igual que intentar copiar o clonar algo indefinidamente, estas prácticas, según los investigadores, podrían provocar más casos de colapso de modelos.

Dadas las graves implicaciones del colapso de los modelos, el acceso a la distribución original de los datos es fundamental. Los modelos de inteligencia artificial necesitan datos reales, producidos por humanos, para comprender y simular con precisión nuestro mundo.

Cómo evitar el colapso de los modelos

Según el documento de investigación, hay dos causas principales del colapso de los modelos. La primera es el «error de aproximación estadística», vinculado al número finito de muestras de datos. La secundaria es el «error de aproximación funcional», que se debe a que el margen de error utilizado durante el entrenamiento de la IA no está bien configurado. Estos errores pueden agravarse con el paso de las generaciones, provocando un efecto cascada de imprecisiones cada vez peores.

El artículo articula una «ventaja del primero» para el entrenamiento de modelos de IA. Si podemos mantener el acceso a la fuente original de datos generados por humanos, podríamos evitar un cambio perjudicial en la distribución y, por tanto, el colapso del modelo.

Sin embargo, distinguir los contenidos generados por IA a gran escala es un reto de enormes proporciones que puede requerir la coordinación de toda la comunidad.

En última instancia, la importancia de la integridad de los datos y la influencia de la información humana en la IA sólo es tan buena como los datos de los que procede, y la explosión de contenidos generados por IA podría acabar siendo un arma de doble filo para el sector. Es «basura dentro, basura fuera»: una IA basada en contenidos de IA dará lugar a un montón de máquinas muy inteligentes, pero «delirantes».

¿Qué le parece este irónico giro argumental? Nuestra descendencia de máquinas, que aprenden más unas de otras que de nosotros, se vuelven «delirantes». Ahora tendremos que lidiar con un ChatGPT delirante y adolescente.