Искусственный интеллект изменил игру во многих областях, от здравоохранения и розничной торговли до развлечений и искусства. Однако новые исследования показывают, что мы, возможно, достигли переломного момента: ИИ учится на контенте, создаваемом ИИ.

Этот уроборос ИИ — змея, пожирающая свой собственный хвост — может закончиться весьма плачевно. Исследовательская группа из разных университетов Великобритании выступила с предупреждением о том, что они назвали «крахом модели», дегенеративным процессом, который может полностью отделить ИИ от реальности.

В статье под названием «Проклятие рекурсии: Обучение на сгенерированных данных заставляет модели забывать», исследователи из Кембриджского и Оксфордского университетов, Университета Торонто и Имперского колледжа в Лондоне объясняют, что коллапс модели происходит, когда «сгенерированные данные в конечном итоге загрязняют набор для обучения следующего поколения моделей».

«Будучи обученными на загрязненных данных, они затем неправильно воспринимают реальность», — пишут они.

Другими словами, широко распространенный контент, генерируемый ИИ, публикуемый в Интернете, может попасть обратно в системы ИИ, что приведет к искажениям и неточностям.

Эта проблема была обнаружена в ряде обучаемых генеративных моделей и инструментов, включая большие языковые модели (LLM), вариативные автоэнкодеры и модели гауссовых смесей. Со временем модели начинают «забывать истинное базовое распределение данных», что приводит к неточному отображению реальности, поскольку исходная информация становится настолько искаженной, что перестает быть похожей на реальные данные.

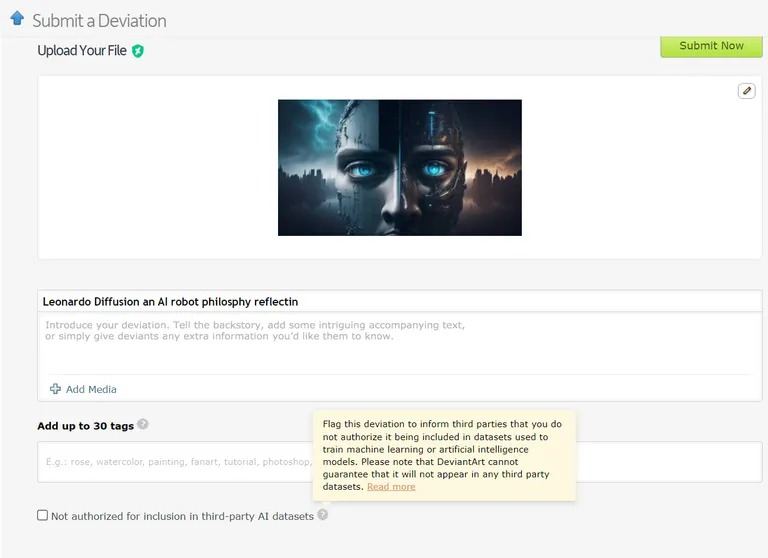

Уже есть примеры, когда модели машинного обучения обучаются на данных, созданных ИИ. Например, модели обучения языку (LLM) целенаправленно обучаются на результатах GPT-4. Аналогичным образом, DeviantArt, онлайн-платформа для художников, позволяет публиковать созданные ИИ произведения искусства и использовать их в качестве обучающих данных для новых моделей ИИ.

Изображение: Devianart

Как и попытка бесконечно копировать или клонировать что-либо, такая практика, по мнению исследователей, может привести к увеличению числа случаев краха модели.

Учитывая серьезные последствия краха модели, доступ к исходному распределению данных имеет решающее значение. Модели ИИ нуждаются в реальных, произведенных человеком данных для точного понимания и моделирования нашего мира.

Как предотвратить крах модели

По данным исследовательской работы, существует две основные причины краха моделей. Первичной является «ошибка статистической аппроксимации», которая связана с конечным числом образцов данных. Вторичная — «ошибка функциональной аппроксимации», которая возникает из-за неправильной настройки предела погрешности, используемого при обучении ИИ. Эти ошибки могут усугубляться с течением поколений, вызывая каскадный эффект усугубления неточностей.

В статье сформулировано «преимущество первого лица» для обучения моделей ИИ. Если мы сможем сохранить доступ к исходному источнику данных, созданных человеком, мы сможем предотвратить пагубное изменение распределения и, следовательно, разрушение модели.

Отличить контент, созданный ИИ, в масштабе — сложнейшая задача, которая, однако, может потребовать координации усилий всего сообщества.

В конечном счете, важность целостности данных и влияние человеческой информации на ИИ хороши лишь настолько, насколько хороши данные, на основе которых они созданы, и взрыв контента, созданного ИИ, может оказаться обоюдоострым мечом для отрасли. Это «мусор внутри, мусор снаружи» — ИИ, основанный на контенте ИИ, приведет к появлению множества очень умных, но «заблуждающихся» машин.

Как вам такой ироничный поворот сюжета? Наше машинное потомство, учась больше друг у друга, чем у нас, становится «заблуждающимся». Далее нам придется иметь дело с бредовым подростковым чатом