Umělá inteligence mění pravidla hry v mnoha oblastech, od zdravotnictví přes maloobchod až po zábavu a umění. Nový výzkum však naznačuje, že jsme možná dosáhli bodu zlomu: Umělá inteligence se učí z obsahu vytvořeného umělou inteligencí.

Tento AI ouroboros – had požírající vlastní ocas – by mohl skončit dost špatně. Výzkumná skupina z různých univerzit ve Velké Británii vydala varování před takzvaným „kolapsem modelu“, degenerativním procesem, který by mohl zcela oddělit UI od reality.

V článku nazvaném „The Curse of Recursion: Vědci z univerzit v Cambridgi a Oxfordu, Torontské univerzity a Imperial College v Londýně vysvětlují, že ke zhroucení modelu dochází, když „vygenerovaná data nakonec znečistí tréninkovou sadu další generace modelů“.

„Když jsou modely vycvičeny na znečištěných datech, špatně vnímají realitu,“ napsali.

Jinými slovy, rozšířený obsah generovaný umělou inteligencí, který je zveřejňován na internetu, by mohl být nasáván zpět do systémů umělé inteligence, což by vedlo ke zkreslení a nepřesnostem.

Tento problém byl zjištěn u řady naučených generativních modelů a nástrojů, včetně velkých jazykových modelů (LLM), variačních autoenkodérů a modelů Gaussovských směsí. Modely časem začnou „zapomínat na skutečné rozložení základních dat“, což vede k nepřesné reprezentaci reality, protože původní informace se zkreslí natolik, že se přestanou podobat datům z reálného světa.

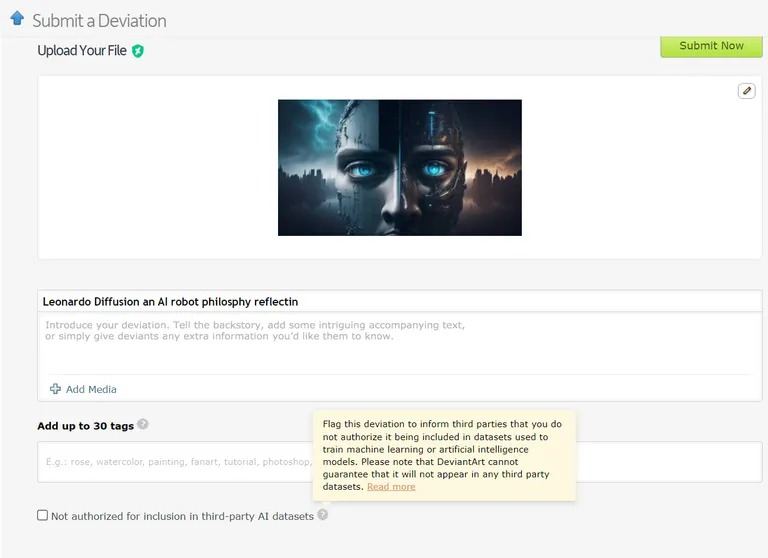

Existují již případy, kdy jsou modely strojového učení trénovány na datech generovaných umělou inteligencí. Například modely jazykového učení (LLM) jsou záměrně trénovány na výstupech z GPT-4. Podobně DeviantArt, online platforma pro umělce, umožňuje zveřejňovat umělecká díla vytvořená umělou inteligencí a používat je jako tréninková data pro novější modely umělé inteligence.

Obrázek: Devianart

Podobně jako pokusy o neomezené kopírování nebo klonování mohou tyto postupy podle vědců vést k většímu počtu případů zhroucení modelu.

Vzhledem k závažným důsledkům zhroucení modelu je přístup k původní distribuci dat zásadní. Modely umělé inteligence potřebují skutečná, lidmi vytvořená data, aby mohly přesně pochopit a simulovat náš svět.

Jak zabránit kolapsu modelu

Podle výzkumného dokumentu existují dvě hlavní příčiny kolapsu modelů. Tou hlavní je „chyba statistické aproximace“, která souvisí s konečným počtem vzorků dat. Druhou je „chyba funkční aproximace“, která pramení z nesprávně nastaveného rozpětí chyby použitého při tréninku umělé inteligence. Tyto chyby se mohou v průběhu generací stupňovat a způsobovat kaskádový efekt zhoršujících se nepřesností.

V článku je formulována „výhoda prvního hráče“ při trénování modelů umělé inteligence. Pokud se nám podaří zachovat přístup k původnímu zdroji dat generovaných člověkem, můžeme zabránit škodlivému posunu distribuce, a tím i zhroucení modelu.

Rozlišování obsahu generovaného umělou inteligencí v měřítku je však náročná výzva, která může vyžadovat koordinaci v rámci celé komunity.

V konečném důsledku je důležitost integrity dat a vlivu lidských informací na UI jen tak dobrá, jak dobrá jsou data, z nichž vychází, a exploze obsahu generovaného UI může být nakonec pro odvětví dvousečnou zbraní. Platí „garbage in, garbage out“ – AI založená na obsahu AI povede ke vzniku mnoha velmi chytrých, ale „klamných“ strojů.

Co říkáte na ironický zvrat v ději? Naši strojoví potomci, kteří se učí více jeden od druhého než od nás, se stanou „bludnými“. Příště se budeme muset vypořádat s bludným, pubertálním ChatGPT.