Изкуственият интелект променя правилата на играта в много области – от здравеопазването през търговията на дребно до развлеченията и изкуството. И все пак нови изследвания показват, че може би сме достигнали критична точка: ИИ се учи от съдържание, генерирано от ИИ.

Този ИИ-уроборос – змия, която яде собствената си опашка – може да завърши доста зле. Изследователска група от различни университети в Обединеното кралство предупреждава за така наречения „колапс на модела“ – дегенеративен процес, който може напълно да отдели ИИ от реалността.

В статия, озаглавена „Проклятието на рекурсията: Оксфорд, Университета на Торонто и Имперския колеж в Лондон обясняват, че сривът на модела настъпва, когато „генерираните данни в крайна сметка замърсяват набора за обучение на следващото поколение модели“.

„Обучени върху замърсени данни, те след това възприемат реалността погрешно“, пишат те.

С други думи, широко разпространеното съдържание, генерирано от ИИ, което се публикува онлайн, може да бъде засмукано обратно в системите за ИИ, което да доведе до изкривявания и неточности.

Този проблем е открит в редица заучени генеративни модели и инструменти, включително големи езикови модели (LLM), вариационни автокодери и модели на Гаусови смеси. С течение на времето моделите започват да „забравят истинското базово разпределение на данните“, което води до неточно представяне на реалността, тъй като първоначалната информация става толкова изкривена, че престава да прилича на реалните данни.

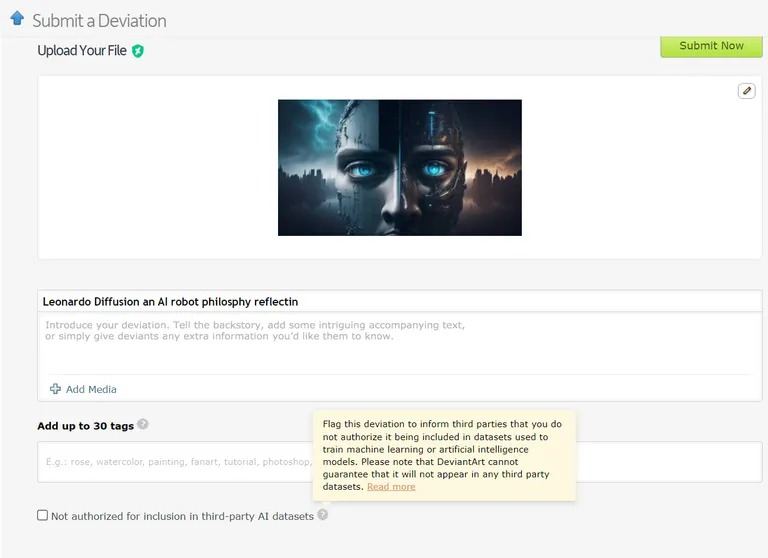

Вече има случаи, в които модели за машинно обучение се обучават върху данни, генерирани от изкуствен интелект. Например, моделите за изучаване на езика (LLM) се обучават целенасочено върху резултатите от GPT-4. По подобен начин DeviantArt, онлайн платформата за художници, позволява да се публикуват произведения на изкуството, създадени от ИИ, и да се използват като данни за обучение на по-нови модели на ИИ.

Изображение: Devianart

Подобно на опитите за безкрайно копиране или клониране на нещо, тези практики, според изследователите, могат да доведат до повече случаи на срив на модела.

Като се имат предвид сериозните последици от колапса на модела, достъпът до оригиналното разпределение на данните е от решаващо значение. Моделите с изкуствен интелект се нуждаят от реални, произведени от хора данни, за да разбират и симулират точно нашия свят.

Как да предотвратим срива на модела

Според изследователския документ има две основни причини за срив на моделите. Основната от тях е „грешка на статистическото приближение“, която е свързана с крайния брой извадки от данни. Втората е „грешка на функционалното приближение“, която произтича от това, че маржът на грешка, използван по време на обучението на изкуствения интелект, не е правилно конфигуриран. Тези грешки могат да се натрупват с течение на поколенията, предизвиквайки каскаден ефект на задълбочаване на неточностите.

Документът посочва „предимството на първия“ при обучението на модели на ИИ. Ако успеем да запазим достъпа до оригиналния източник на данни, генериран от човека, може да предотвратим пагубна промяна в разпределението и по този начин – срив на модела.

Разграничаването на съдържанието, генерирано от ИИ, в голям мащаб обаче е трудно предизвикателство, което може да изисква координация в цялата общност.

В крайна сметка значението на интегритета на данните и влиянието на човешката информация върху ИИ е толкова добро, колкото са добри данните, от които то, а експлозията на съдържанието, генерирано от ИИ, може да се окаже нож с две остриета за индустрията. Това е „боклукът влиза, боклукът излиза“ – ИИ, базиран на съдържание от ИИ, ще доведе до много много умни, но „заблудени“ машини.

Какво ще кажете за ироничен обрат в сюжета? Нашите машинни потомци, които се учат повече един от друг, отколкото от нас, стават „заблудени“. Следващият път ще трябва да се справим с един заблуден, подрастващ ChatGPT.