L’intelligence artificielle a changé la donne dans de nombreux domaines, de la santé à la vente au détail en passant par le divertissement et l’art. Cependant, de nouvelles recherches suggèrent que nous avons peut-être atteint un point de basculement : L’IA apprend à partir de contenus générés par l’IA.

Cet ouroboros de l’IA – un serpent qui se mange la queue – pourrait se terminer assez mal. Un groupe de chercheurs de différentes universités du Royaume-Uni a lancé un avertissement sur ce qu’il a appelé « l’effondrement du modèle », un processus dégénératif qui pourrait séparer complètement l’IA de la réalité.

Dans un article intitulé « The Curse of Recursion : Training on Generated Data Makes Models Forget », des chercheurs des universités de Cambridge et d’Oxford, de l’université de Toronto et de l’Imperial College de Londres expliquent que l’effondrement du modèle se produit lorsque « les données générées finissent par polluer l’ensemble d’entraînement de la prochaine génération de modèles ».

« Formés à partir de données polluées, ces modèles ont alors une perception erronée de la réalité », écrivent-ils.

En d’autres termes, le contenu généré par l’IA et publié en ligne pourrait être réinjecté dans les systèmes d’IA, ce qui entraînerait des distorsions et des inexactitudes.

Ce problème a été constaté dans une série de modèles et d’outils génératifs appris, notamment les grands modèles de langage (LLM), les autoencodeurs variationnels et les modèles de mélange gaussien. Avec le temps, les modèles commencent à « oublier la véritable distribution sous-jacente des données », ce qui conduit à des représentations inexactes de la réalité parce que les informations originales sont tellement déformées qu’elles cessent de ressembler aux données du monde réel.

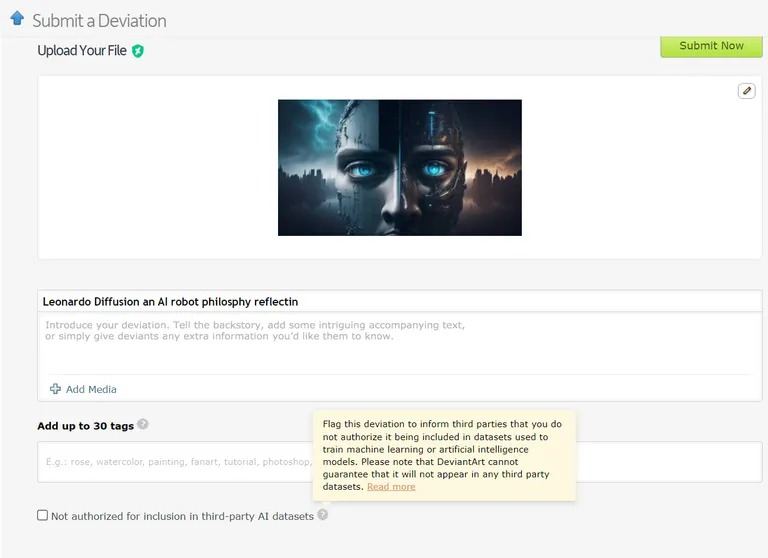

Il existe déjà des cas où des modèles d’apprentissage automatique sont formés sur des données générées par l’IA. Par exemple, les modèles d’apprentissage du langage (LLM) sont intentionnellement formés sur les données de GPT-4. De même, DeviantArt, la plateforme en ligne pour les artistes, permet de publier des œuvres d’art créées par l’IA et de les utiliser comme données d’entraînement pour des modèles d’IA plus récents.

Image : Devianart

Tout comme la tentative de copier ou de cloner indéfiniment quelque chose, ces pratiques, selon les chercheurs, pourraient conduire à davantage de cas d’effondrement du modèle.

Compte tenu des graves implications de l’effondrement du modèle, l’accès à la distribution des données d’origine est essentiel. Les modèles d’IA ont besoin de données réelles, produites par l’homme, pour comprendre et simuler notre monde avec précision.

Comment prévenir l’effondrement des modèles

Il y a deux causes principales à l’effondrement des modèles, selon le document de recherche. La première est l' »erreur d’approximation statistique », liée au nombre limité d’échantillons de données. La seconde est l' »erreur d’approximation fonctionnelle », qui découle du fait que la marge d’erreur utilisée lors de l’apprentissage de l’IA n’est pas correctement configurée. Ces erreurs peuvent s’accumuler au fil des générations, provoquant un effet de cascade d’inexactitudes croissantes.

L’article présente un « avantage du premier arrivé » pour la formation des modèles d’IA. Si nous pouvons conserver l’accès à la source originale de données générées par l’homme, nous pourrions éviter un changement de distribution préjudiciable et, par conséquent, l’effondrement du modèle.

Distinguer le contenu généré par l’IA à grande échelle est toutefois un défi de taille, qui pourrait nécessiter une coordination à l’échelle de la communauté.

En fin de compte, l’importance de l’intégrité des données et l’influence de l’information humaine sur l’IA ne valent que ce que valent les données dont elles sont issues, et l’explosion du contenu généré par l’IA pourrait finir par être une épée à double tranchant pour l’industrie. L’explosion du contenu généré par l’IA pourrait s’avérer être une arme à double tranchant pour l’industrie. C’est le principe du « garbage in, garbage out » : l’IA basée sur le contenu de l’IA conduira à un grand nombre de machines très intelligentes, mais « délirantes ».

Que diriez-vous d’un retournement de situation ironique ? Nos descendants, qui apprennent plus les uns des autres que de nous, deviennent « délirants ». Nous devrons ensuite nous occuper d’un adolescent délirant, le ChatGPT.