Este problema foi detectado numa série de modelos e ferramentas generativas aprendidas, incluindo Modelos de Linguagem Grandes (LLMs), Autoencoders Variacionais e Modelos de Mistura Gaussiana. Com o tempo, os modelos começam a “esquecer a verdadeira distribuição de dados subjacente”, levando a representações incorrectas da realidade porque a informação original fica tão distorcida que deixa de se assemelhar aos dados do mundo real.

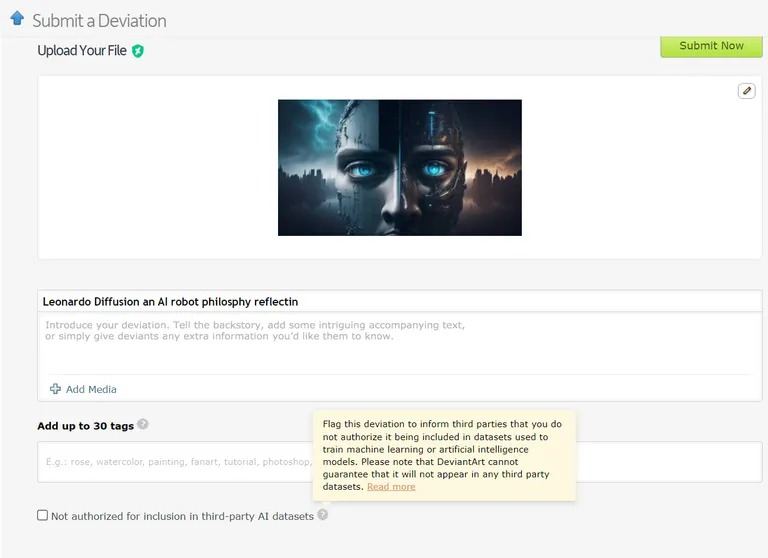

Já existem casos em que os modelos de aprendizagem automática são treinados com dados gerados por IA. Por exemplo, os modelos de aprendizagem de línguas (LLM) estão a ser intencionalmente treinados com os resultados do GPT-4. Do mesmo modo, o DeviantArt, a plataforma em linha para artistas, permite que obras de arte criadas por IA sejam publicadas e utilizadas como dados de treino para modelos de IA mais recentes.

Imagem: Devianart

Tal como tentar copiar ou clonar algo indefinidamente, estas práticas, de acordo com os investigadores, podem levar a mais casos de colapso do modelo.

Dadas as graves implicações do colapso do modelo, o acesso à distribuição de dados original é fundamental. Os modelos de IA precisam de dados reais, produzidos por humanos, para compreender e simular com precisão o nosso mundo.

Como evitar o colapso do modelo

Existem duas causas principais para o colapso do modelo, de acordo com o documento de investigação. A principal é o “erro de aproximação estatística”, que está relacionado com o número finito de amostras de dados. A segunda é o “erro de aproximação funcional”, que resulta do facto de a margem de erro utilizada durante a formação da IA não estar corretamente configurada. Estes erros podem agravar-se ao longo das gerações, causando um efeito de cascata de imprecisões cada vez maiores.

O documento articula uma “vantagem do pioneiro” para a formação de modelos de IA. Se conseguirmos manter o acesso à fonte de dados original gerada por humanos, poderemos evitar uma mudança de distribuição prejudicial e, consequentemente, o colapso do modelo.

Distinguir o conteúdo gerado pela IA à escala é, no entanto, um desafio assustador, que pode exigir uma coordenação a nível da comunidade.

Em última análise, a importância da integridade dos dados e da influência da informação humana na IA é apenas tão boa quanto os dados a partir dos quais é gerada, e a explosão de conteúdos gerados por IA pode acabar por ser uma faca de dois gumes para o sector. É “lixo dentro, lixo fora” – a IA baseada em conteúdos de IA dará origem a muitas máquinas muito inteligentes, mas “ilusórias”.

Que tal esta ironia? A nossa descendência de máquinas, aprendendo mais umas com as outras do que connosco, torna-se “delirante”. A seguir, vamos ter de lidar com um ChatGPT adolescente e delirante.