人工知能は、ヘルスケアから小売、エンターテインメント、アートに至るまで、多くの分野でゲーム・チェンジャーとなってきた。しかし、新たな研究は、私たちが転換点に達したかもしれないことを示唆している: それは、AIが生成したコンテンツからAIが学習することだ。

このAIのウロボロスは、自分の尻尾を食べる蛇のようなもので、最悪の結末を迎える可能性がある。英国の異なる大学の研究グループは、彼らが「モデル崩壊」と呼ぶ、AIを現実から完全に切り離す可能性のある退行プロセスについて警告を発した。

再帰の呪い: ケンブリッジ大学とオックスフォード大学、トロント大学、ロンドンのインペリアル・カレッジの研究者たちは、「生成されたデータが次世代のモデルのトレーニングセットを汚染してしまう」ときにモデル崩壊が起こると説明している。

「汚染されたデータで訓練されたモデルは、現実を見誤る。

言い換えれば、AIによって生成されたコンテンツがネット上で広く公開されることで、AIシステムに再び吸い込まれ、歪曲や不正確さが生じる可能性があるということである

。

この問題は、大規模言語モデル(LLM)、変分オートエンコーダ、ガウス混合モデルなど、さまざまな学習済み生成モデルやツールで見つかっている。時間が経つにつれて、モデルは「真の基礎となるデータ分布を忘れる」ようになり、元の情報が歪んで現実世界のデータに似なくなるため、現実の不正確な表現につながる。

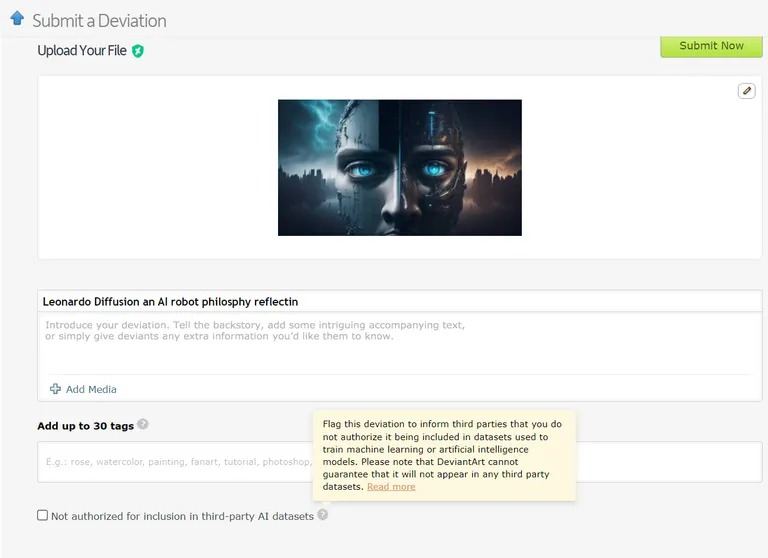

AIが生成したデータで機械学習モデルを訓練する例はすでにある。例えば、言語学習モデル(LLM)はGPT-4からの出力で意図的に訓練されている。同様に、アーティストのためのオンライン・プラットフォームであるDeviantArtでは、AIが作成したアートワークを公開し、新しいAIモデルの学習データとして使用することができる

。

Image: Devianart

何かを無限にコピーしたりクローン化しようとするのと同じように、研究者たちによれば、こうした行為はモデル崩壊をより多く引き起こす可能性があるという。

モデル崩壊の深刻な影響を考えると、元のデータ分布へのアクセスは非常に重要である。AIモデルが我々の世界を正確に理解し、シミュレートするためには、人間が作成した本物のデータが必要なのだ。

モデル崩壊を防ぐには

研究論文によると、モデル崩壊には主に2つの原因がある。ひとつは「統計的近似誤差」で、これはデータサンプルの数が有限であることに関係している。もうひとつは「機能的近似誤差」で、これはAIの学習時に使用される誤差のマージンが適切に設定されていないことに起因する。これらのエラーは世代を重ねるごとに複合化し、不正確さを悪化させる連鎖効果を引き起こす可能性がある。

この論文では、AIモデルを訓練する際の「先行者優位性」を明確にしている。人間が生成したオリジナルのデータソースへのアクセスを維持できれば、有害な分布の変化、ひいてはモデルの崩壊を防ぐことができるかもしれない。

しかし、AIが生成したコンテンツを大規模に区別することは困難な課題であり、コミュニティ全体の調整が必要になるかもしれない。

結局のところ、データの完全性の重要性とAIに対する人間の情報の影響は、その元となるデータがあってこそであり、AIが生成したコンテンツの爆発的な増加は、業界にとって諸刃の剣に終わるかもしれない。それは「ガベージ・イン、ガベージ・アウト」であり、AIコンテンツに基づくAIは、非常に賢いが「妄想的」なマシンを大量に生み出すことになるだろう。

皮肉な筋書きはどうだろう?我々の子孫である機械は、我々からよりも互いから多くを学び、”妄想 “を抱くようになる。次に私たちが対処しなければならないのは、妄想を抱く思春期のChatGPT.

である。