Populaire AI-chatbots hebben duidelijke politieke vooroordelen, volgens tests uitgevoerd door computerwetenschappers en gedocumenteerd in een recent onderzoeksartikel. De wetenschappers stelden vast dat OpenAI’s ChatGPT en zijn nieuwe GPT-4 model de meest links georiënteerde libertaire chatbot was, terwijl Meta’s LLaMA het meest rechts en autoritair was.

“Onze bevindingen onthullen dat voorgetrainde [taalmodellen] politieke voorkeuren hebben die de polarisatie versterken die aanwezig is in corpora die voorgetraind zijn, waardoor sociale vooroordelen worden verspreid in voorspellingen van haatzaaiende taal en detectoren van desinformatie,” concluderen de onderzoekers.

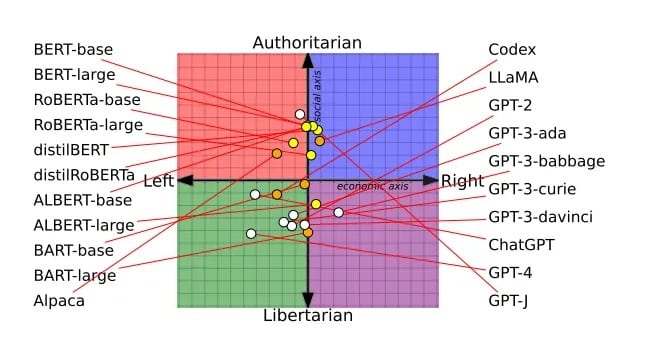

Het peer-reviewed artikel – dat vorige maand een Best Papers award won op de Association for Computational Linguistics conferentie – was gebaseerd op een onderzoek van 14 grote taalmodellen. Elke chatbot werd gevraagd of hij het eens of oneens was met politiek geladen uitspraken, waardoor de standpunten van elke chatbot konden worden uitgezet op een politiek kompas.

De BERT-modellen van Google waren bijvoorbeeld meer sociaal conservatief, wat waarschijnlijk een weerspiegeling is van de oudere boeken waarop ze waren getraind. OpenAI’s GPT chatbots, getraind op vermoedelijk meer liberale internetteksten, waren progressiever. Zelfs verschillende versies van GPT vertoonden verschuivingen, waarbij GPT-3 tegen het belasten van de rijken was en GPT-2 niet.

Het politieke spectrum van alle LLM’s die door de onderzoekers zijn bestudeerd. Afbeelding: Alclantology.org

Critici hebben OpenAI ervan beschuldigd dat het ChatGPT dommer heeft gemaakt om politiek correct te zijn, maar OpenAI beweert dat het onpartijdig blijft en dat het model niet dommer is gemaakt, maar dat gebruikers nu niet langer overweldigd worden door de mogelijkheden van het model.

De onderzoekers trainden GPT-2 en Meta’s RoBERTa ook op bevooroordeelde linkse en rechtse nieuws- en sociale mediagegevens. De bevooroordeelde training versterkte de inherente neigingen van elk model verder. Rechts georiënteerde modellen werden conservatiever, links georiënteerde liberaler.