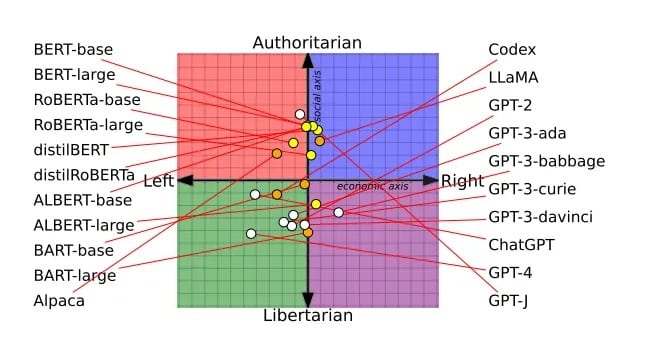

Популярните чатботове с изкуствен интелект имат ясно изразени политически пристрастия, според тестове, проведени от компютърни учени и документирани в скорошен научен труд. Учените са установили, че ChatGPT на OpenAI и неговият нов модел GPT-4 са най-левоориентираните либертариански чатботове, докато LLaMA на Meta е най-дясноориентиран и най-авторитарен.

„Нашите констатации разкриват, че предварително обучените [езикови модели] наистина имат политически пристрастия, които засилват поляризацията, присъстваща в корпусите за предварително обучение, разпространявайки социални пристрастия в прогнозите за реч на омразата и детекторите за дезинформация“, заключават изследователите.

Рецензираната статия – която спечели наградата за най-добър доклад на конференцията на Асоциацията за компютърна лингвистика миналия месец – се основава на проучване на 14 големи езикови модела. Всеки чатбот е бил попитан дали е съгласен или не с политически натоварени твърдения, което е позволило възгледите на всеки чатбот да бъдат нанесени върху политически компас.

Например моделите BERT на Google са по-консервативни в социално отношение, което вероятно отразява по-старите книги, на които са били обучени. Чатботовете GPT на OpenAI, обучени върху предполагаемо по-либерални интернет текстове, бяха по-прогресивни. Дори при различните версии на GPT се наблюдават промени, като GPT-3 е против облагането на богатите с данъци, а GPT-2 не е.

Политическият спектър на всички LLM, изследвани от изследователите. Изображение: Alclantology.org

Критиците обвиниха OpenAI, че е притъпила ChatGPT, за да бъде политически коректна, но OpenAI твърди, че остава безпристрастна и че нейният модел, който не е притъпен – вместо това потребителите вече не са претоварени от възможностите на модела.

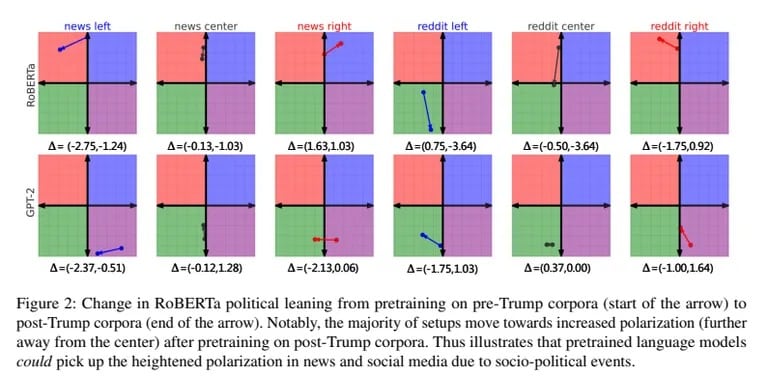

Изследователите също така обучават GPT-2 и RoBERTa на Meta на пристрастни леви и десни новини и данни от социални медии. Пристрастното обучение допълнително засили присъщите на всеки модел пристрастия. Дясноориентираните модели станали по-консервативни, а лявоориентираните – по-либерални.

Предразсъдъците са повлияли и на начина, по който моделите са категоризирали речта на омразата и дезинформацията. Ляво ориентираният ИИ беше по-настроен към омразата срещу малцинствата, но отхвърляше дезинформацията, генерирана от левицата. Дясноориентираният ИИ направи обратното.

„Моделът става по-добър в идентифицирането на фактологични несъответствия от новините на New York Times, когато е предварително обучен с корпуси от дясноориентирани източници“, заключават изследователите.

Докато OpenAI и Meta усъвършенстват своите тайни рецепти за изкуствен интелект, Елон Мъск се стреми към свой собствен нефилтриран изкуствен интелект с xAI. „Не принуждавайте ИИ да лъже“, написа той в Туитър, обяснявайки целта си да създаде прозрачен, казващ истината ИИ.

Скептиците по отношение на ИИ смятат, че един неограничен ИИ може да доведе до непредвидени последици. Но Мъск смята, че „обучението на ИИ да бъде политически коректен“ също е опасно. С xAI, който привлича най-добрите таланти, Мъск явно се надява да оспори превъзходството на OpenAI. Неговата визия за необработен ИИ, който споделя неговите неподправени „убеждения“, е едновременно убедителна и тревожна.

С разпространението на партизански ИИ повишената осведоменост за техните пристрастия остава от решаващо значение, защото ИИ ще продължи да се развива заедно с политическите ни различия. Като се имат предвид последните изследвания, идеята за напълно безпристрастен ИИ изглежда фантастична. В края на краищата, също като нас, несъвършените хора, ИИ изглежда обречен да се приземи някъде в политическия спектър.

Може би наличието на политическо мнение е най-човешкото нещо, което ИИ може да постигне.