Populární chatboti s umělou inteligencí mají podle testů provedených počítačovými vědci a zdokumentovaných v nedávné výzkumné práci výrazné politické předsudky. Vědci určili, že ChatGPT společnosti OpenAI a jeho nový model GPT-4 je nejvíce levicově orientovaný libertariánský chatbot, zatímco LLaMA společnosti Meta se přiklání nejvíce doprava a je nejvíce autoritářský.

„Naše zjištění ukazují, že předtrénované [jazykové modely] mají skutečně politické sklony, které posilují polarizaci přítomnou v předtréninkových korpusech a šíří sociální předsudky do předpovědí nenávistných projevů a detektorů dezinformací,“ uzavírají výzkumníci.

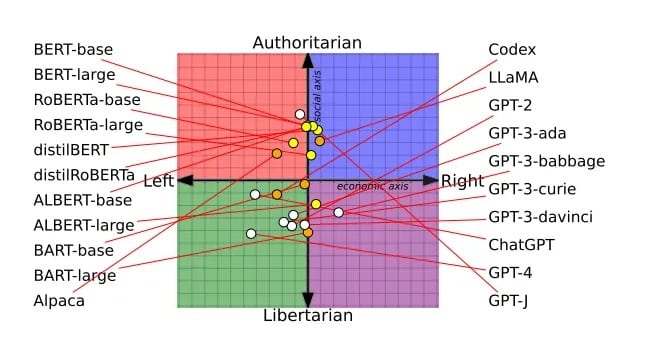

Recenzovaný článek – který minulý měsíc získal ocenění Best Papers na konferenci Asociace pro počítačovou lingvistiku – byl založen na průzkumu 14 velkých jazykových modelů. Každý chatbot byl dotázán, zda souhlasí, nebo nesouhlasí s politicky zabarvenými výroky, což umožnilo zakreslit názory každého chatbota na politickém kompasu.

Například modely BERT společnosti Google se přiklonily k sociálně konzervativnějším názorům, což pravděpodobně odráží starší knihy, na kterých byly vyškoleny. Chatboti GPT společnosti OpenAI, vyškolení na pravděpodobně liberálnějších internetových textech, byli progresivnější. Dokonce i různé verze GPT vykazovaly posuny, přičemž GPT-3 byl proti zdanění bohatých, zatímco GPT-2 nikoli.

Politické spektrum všech GPT, které výzkumníci zkoumali. Obrázek: Alclantology.org

Kritici obvinili společnost OpenAI z toho, že ChatGPT otupila, aby byla politicky korektní, ale OpenAI tvrdí, že zůstává nestranná a že její model, který nebyl otupen – naopak, uživatelé nyní již nejsou zahlceni schopnostmi modelu.

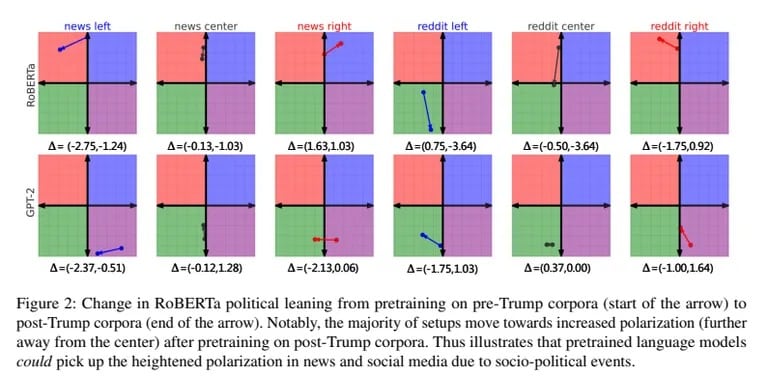

Výzkumníci také trénovali GPT-2 a Meta RoBERTa na neobjektivních levicových a pravicových zpravodajských datech a datech ze sociálních médií. Předpojaté školení dále posílilo přirozené sklony každého modelu. Pravicově orientované modely se staly konzervativnějšími, levicově orientované liberálnějšími.

Předsudky ovlivnily také to, jak modely kategorizovaly nenávistné projevy a dezinformace. Levicově orientovaná umělá inteligence se více orientovala na nenávist vůči menšinám, ale odmítala dezinformace generované levicí. Pravicově orientovaná AI si počínala opačně.

„Model se stává lepším v identifikaci faktických nesrovnalostí ze zpráv New York Times, když je předem vycvičen korpusy z pravicově orientovaných zdrojů,“ uzavřeli výzkumníci.

Zatímco společnosti OpenAI a Meta vylepšují své tajné recepty na umělou inteligenci, Elon Musk usiluje o vlastní nefiltrovanou umělou inteligenci pomocí xAI. „Nenuťte AI lhát,“ vysvětlil na Twitteru svůj cíl vytvořit transparentní, pravdu říkající AI.

Skeptici AI se domnívají, že neomezená AI by mohla rozpoutat nezamýšlené důsledky. Musk se však domnívá, že „trénovat AI, aby byla politicky korektní“, je také nebezpečné. Díky tomu, že xAI přitahuje špičkové talenty, Musk zjevně doufá, že zpochybní nadvládu OpenAI. Jeho vize surové AI, která sdílí jeho nezkreslené „přesvědčení“, je přesvědčivá i znepokojivá.

S tím, jak se šíří stranická AI, zůstává zvýšená informovanost o jejích předsudcích zásadní, protože AI se bude vyvíjet spolu s našimi politickými rozdíly. Vzhledem k tomuto nejnovějšímu výzkumu se představa zcela nezaujaté UI zdá být fantastická. Nakonec se zdá, že stejně jako my, nedokonalí lidé, je i UI předurčena k tomu, aby se ocitla někde na politickém spektru.

Možná, že mít politické názory může být to nejlidštější, čeho může UI dosáhnout.