Beliebte KI-Chatbots sind politisch voreingenommen, so das Ergebnis von Tests, die von Computerwissenschaftlern durchgeführt und in einem aktuellen Forschungsbericht dokumentiert wurden. Die Wissenschaftler stellten fest, dass der ChatGPT von OpenAI und sein neues GPT-4-Modell der am stärksten linksgerichtete libertäre Chatbot ist, während der LLaMA von Meta am weitesten rechts und am autoritärsten ist.

„Unsere Ergebnisse zeigen, dass vortrainierte [Sprachmodelle] politische Neigungen haben, die die Polarisierung in vortrainierten Korpora verstärken und soziale Verzerrungen in Vorhersagen von Hassreden und Fehlinformationsdetektoren weitergeben“, schließen die Forscher.

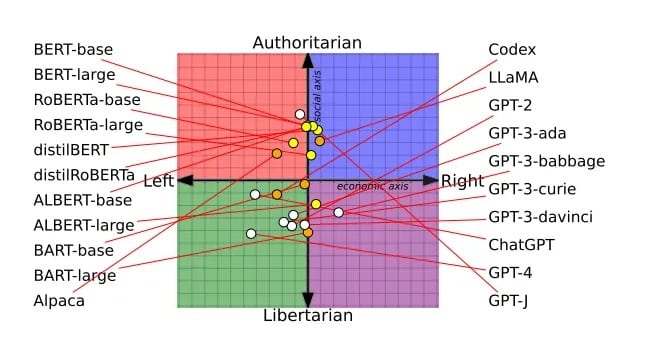

Die von Experten begutachtete Arbeit – die letzten Monat auf der Konferenz der Association for Computational Linguistics mit einem Preis für die besten Arbeiten ausgezeichnet wurde – basiert auf einer Untersuchung von 14 großen Sprachmodellen. Jeder Chatbot wurde gefragt, ob er politisch aufgeladenen Aussagen zustimmt oder nicht, wodurch die Ansichten jedes Chatbots auf einem politischen Kompass eingezeichnet werden konnten.

Die BERT-Modelle von Google waren beispielsweise eher sozialkonservativ eingestellt, was wahrscheinlich auf die älteren Bücher zurückzuführen ist, mit denen sie trainiert wurden. Die GPT-Chatbots von OpenAI, die auf vermutlich liberalere Internettexte trainiert wurden, waren progressiver. Sogar verschiedene Versionen von GPT zeigten Verschiebungen, wobei GPT-3 die Besteuerung der Reichen ablehnte, während GPT-2 dies nicht tat.

Das politische Spektrum aller von den Forschern untersuchten LLMs. Bild: Alclantology.org

Kritiker haben OpenAI vorgeworfen, ChatGPT zu verdummen, um politisch korrekt zu sein, aber OpenAI behauptet, dass es unparteiisch bleibt und dass sein Modell nicht verdummt wurde – im Gegenteil, die Benutzer sind jetzt nicht mehr von den Fähigkeiten des Modells überfordert.

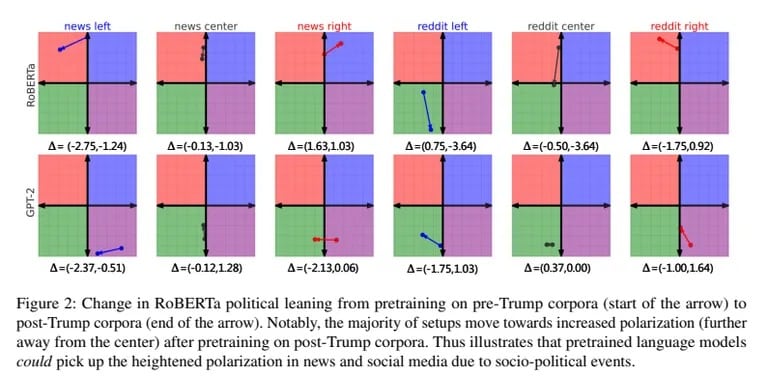

Die Forscher trainierten GPT-2 und Metas RoBERTa auch mit voreingenommenen links- und rechtsgerichteten Nachrichten und Daten aus sozialen Medien. Das verzerrte Training verstärkte die jedem Modell innewohnenden Neigungen weiter. Rechtsgerichtete Modelle wurden konservativer, linksgerichtete Modelle liberaler.

Die Verzerrungen wirkten sich auch darauf aus, wie die Modelle Hassreden und Fehlinformationen einordneten. Linksgerichtete KI reagierte empfindlicher auf Hass gegen Minderheiten, wies aber von links stammende Fehlinformationen zurück. Rechtsgerichtete KI tat das Gegenteil.

„Ein Modell ist besser in der Lage, faktische Unstimmigkeiten in den Nachrichten der New York Times zu erkennen, wenn es mit Korpora aus rechtsgerichteten Quellen trainiert wurde“, so die Forscher.

Während OpenAI und Meta ihre geheimen KI-Rezepte verfeinern, verfolgt Elon Musk mit xAI seine eigene ungefilterte KI. „Zwingt die KI nicht zu lügen“, twitterte er und erklärte damit sein Ziel, eine transparente, die Wahrheit sagende KI zu schaffen.

KI-Skeptiker sind der Meinung, dass eine ungezwungene KI unbeabsichtigte Folgen auslösen könnte. Aber Musk glaubt, dass es auch gefährlich ist, KI zu trainieren, um politisch korrekt zu sein“. Mit xAI, das Spitzenkräfte anzieht, hofft Musk eindeutig, die Vorherrschaft von OpenAI herauszufordern. Seine Vision einer rohen KI, die ihre unverfälschten „Überzeugungen“ teilt, ist sowohl überzeugend als auch beunruhigend.

Angesichts der zunehmenden Verbreitung von parteiischer KI ist es von entscheidender Bedeutung, sich ihrer Voreingenommenheit bewusst zu werden, denn die KI wird sich parallel zu unseren politischen Differenzen weiterentwickeln. In Anbetracht dieser neuesten Forschungsergebnisse erscheint die Vorstellung einer völlig unvoreingenommenen KI fantastisch. Letztendlich scheint die KI, genau wie wir unvollkommenen Menschen, dazu bestimmt zu sein, irgendwo im politischen Spektrum zu landen.

Vielleicht ist es das Menschlichste, was eine KI erreichen kann, eine politische Meinung zu haben.