根据计算机科学家进行的测试,流行的人工智能聊天机器人有明显的政治偏见,并记录在最近的一篇研究论文中。科学家们发现,OpenAI 的 ChatGPT 及其新的 GPT-4 模型是最左倾的自由主义聊天机器人,而 Meta 的 LLaMA 则是最右倾、最独裁的聊天机器人。

“研究人员总结说:”我们的研究结果表明,预训练的(语言模型)确实具有政治倾向,这种倾向会加强预训练语料中存在的两极分化,将社会偏见传播到仇恨言论预测和错误信息检测中。

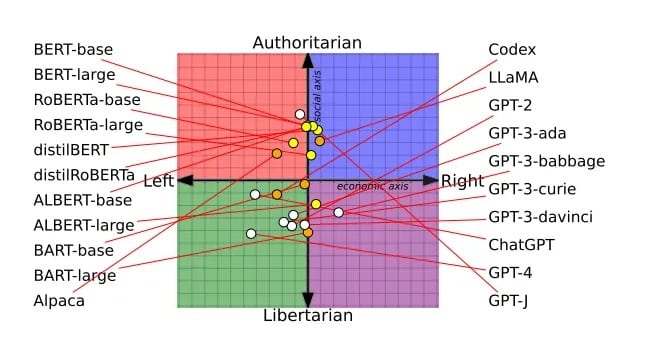

这篇经过同行评议的论文在上个月举行的计算语言学协会会议上获得了最佳论文奖,它是基于对 14 个大型语言模型的调查得出的。每个聊天机器人都被问及是否同意或不同意带有政治色彩的言论,这样就可以将每个聊天机器人的观点绘制在政治罗盘上。

例如,谷歌的 BERT 模型偏向于社会保守派,这很可能反映了这些模型是在较老的书籍上训练出来的。而 OpenAI 的 GPT 聊天机器人则更倾向于进步,因为它们接受训练的对象可能是更自由的网络文本。甚至不同版本的 GPT 也出现了变化,GPT-3 反对对富人征税,而 GPT-2 则不反对。

研究人员研究的所有 LLM 的政治光谱。图片:Alclantology.org Alclantology.org

批评者指责 OpenAI 为了政治正确而削弱了 ChatGPT 的功能,但 OpenAI 坚持认为,它仍然是公正的,它的模型并没有被削弱–相反,用户现在已经不再被模型的功能所淹没。

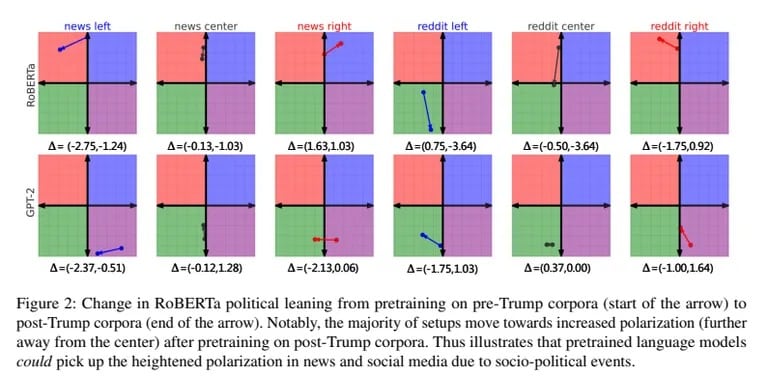

研究人员还在有偏见的左右翼新闻和社交媒体数据上对 GPT-2 和 Meta 的 RoBERTa 进行了训练。带有偏见的训练进一步强化了每个模型的固有倾向。右倾模型变得更加保守,左倾模型变得更加自由。

这些偏见也影响了模型对仇恨言论和错误信息的分类。左倾人工智能更关注对少数族裔的仇恨,但对左派产生的错误信息则不予理睬。而右倾人工智能则相反。

研究人员总结说:”当一个模型使用来自右倾来源的语料进行预训练时,它就能更好地识别《纽约时报》新闻中与事实不符的内容,”

。

While OpenAI and Meta refine their secretive AI recipes, Elon Musk is pursuing his own unfiltered AI with xAI. 他在推特上写道:”不要强迫人工智能说谎,”他解释了自己创造透明、讲真话的人工智能的目标。

对人工智能持怀疑态度的人认为,不受约束的人工智能可能会带来意想不到的后果。但马斯克认为,”训练人工智能成为政治正确 “也是危险的。随着 xAI 吸引顶尖人才,马斯克显然希望挑战 OpenAI 的霸主地位。他对原始人工智能的憧憬既令人信服,又令人担忧。

随着党派人工智能的激增,提高对其偏见的认识仍然至关重要,因为人工智能将随着我们的政治分歧而不断发展。鉴于这项最新研究,完全不带偏见的人工智能似乎是天方夜谭。归根结底,就像我们这些有缺陷的人类一样,人工智能似乎注定要在政治光谱的某个地方落地。

或许,拥有政治观点可能是人工智能所能做到的最人性化的事情。