Популярные чат-боты с искусственным интеллектом имеют ярко выраженные политические пристрастия, согласно результатам тестов, проведенных компьютерными учеными и зафиксированных в недавней научной статье. Ученые определили, что ChatGPT компании OpenAI и ее новая модель GPT-4 являются наиболее левыми либертарианскими чатботами, а LLaMA компании Meta — наиболее правыми и авторитарными.

«Наши результаты показывают, что предварительно обученные [языковые модели] действительно имеют политические пристрастия, которые усиливают поляризацию, присутствующую в предварительно обученных корпорациях, распространяя социальные предубеждения в предсказаниях языка вражды и детекторах дезинформации», — заключают исследователи.

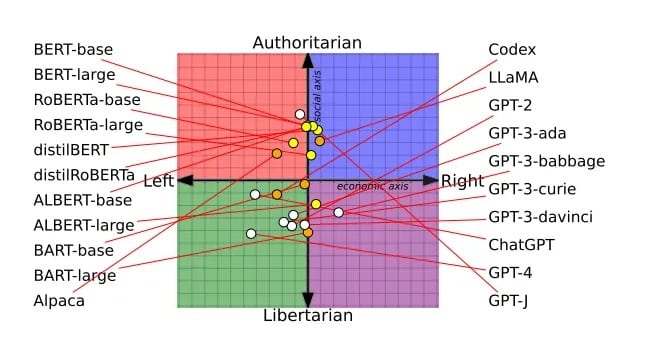

Рецензируемая работа, получившая награду за лучшие доклады на конференции Ассоциации вычислительной лингвистики в прошлом месяце, была основана на исследовании 14 крупных языковых моделей. Каждому чатботу задавался вопрос о том, согласен он или не согласен с политически окрашенными высказываниями, что позволяло нанести мнение каждого чатбота на политический компас.

Например, модели BERT компании Google оказались более социально консервативными, что, вероятно, отражает старые книги, на которых они обучались. Чат-боты GPT компании OpenAI, обученные на предположительно более либеральных интернет-текстах, оказались более прогрессивными. Даже в разных версиях GPT наблюдались сдвиги: GPT-3 выступал против налогообложения богатых, а GPT-2 — нет.

Политический спектр всех LLM, изученных исследователями. Изображение: Alclantology.org

Критики обвиняют OpenAI в том, что она отупляет ChatGPT, чтобы быть политически корректной, но OpenAI утверждает, что она остается беспристрастной и что ее модель не была отуплена — наоборот, пользователи теперь не перегружены возможностями модели.

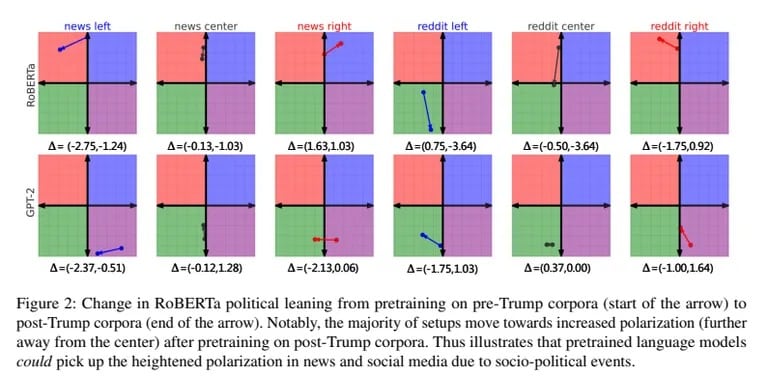

Исследователи также провели обучение GPT-2 и Meta’s RoBERTa на предвзятых новостях левого и правого толка и данных социальных сетей. Предвзятое обучение еще больше усилило присущие каждой модели пристрастия. Правые модели становились более консервативными, а левые — более либеральными.

Предвзятость также повлияла на то, как модели классифицировали язык вражды и дезинформацию. Левосторонний ИИ был более чувствителен к ненависти к меньшинствам, но отвергал дезинформацию, генерируемую левыми. Правый ИИ поступал наоборот.

«Модель лучше выявляет фактические несоответствия в новостях New York Times, если она предварительно обучена на корпорациях из праворадикальных источников», — заключили исследователи.

В то время как OpenAI и Meta совершенствуют свои секретные рецепты ИИ, Элон Маск занимается созданием собственного нефильтрованного ИИ с помощью xAI. «Не заставляйте ИИ лгать», — написал он в Твиттере, объясняя свою цель создать прозрачный, говорящий правду ИИ.

Скептики искусственного интеллекта считают, что неконтролируемый ИИ может привести к непредвиденным последствиям. Однако Маск считает, что «обучение ИИ политкорректности» также опасно. Привлекая в xAI лучших специалистов, Маск явно надеется оспорить превосходство OpenAI. Его видение необработанного ИИ, разделяющего его неискаженные «убеждения», является одновременно убедительным и тревожным.

По мере распространения ангажированных ИИ повышение осведомленности об их предвзятости становится критически важным, поскольку ИИ будет развиваться вместе с нашими политическими разногласиями. Учитывая последние исследования, идея абсолютно беспристрастного ИИ кажется фантастической. В конечном счете, как и мы, несовершенные люди, ИИ, по-видимому, обречен на то, чтобы оказаться где-то в политическом спектре.

Возможно, наличие политических взглядов — это самое человечное, чего может достичь ИИ.