人気のAIチャットボットには明確な政治的バイアスがあることが、コンピュータ科学者によるテストと最近の研究論文で明らかになった。科学者たちは、OpenAIのChatGPTとその新しいGPT-4モデルが最も左寄りの自由主義的なチャットボットである一方、MetaのLLaMAは最も右寄りで権威主義的であると判断した。

「我々の発見は、事前学習された[言語モデル]が、事前学習コーパスに存在する偏向を強化する政治的傾向を持ち、社会的バイアスをヘイトスピーチ予測や誤情報検出に伝播させることを明らかにした」と研究者は結論付けている。

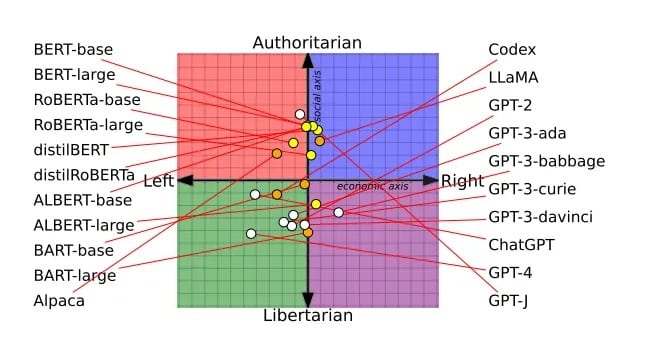

先月開催されたAssociation for Computational Linguistics(計算言語学会)でBest Papers賞を受賞したこの査読付き論文は、14の大規模言語モデルの調査に基づいている。各チャットボットは、政治的な発言に賛成か反対かを尋ねられ、各チャットボットの意見を政治的な羅針盤にプロットすることができた。

例えば、グーグルのBERTモデルは、より社会的に保守的な傾向を示した。OpenAIのGPTチャットボットは、おそらくよりリベラルなインターネットテキストで訓練され、より進歩的であった。GPTの異なるバージョンでさえシフトを示し、GPT-3は富裕層への課税に反対したが、GPT-2は反対しなかった

。

研究者が調査したすべてのLLMの政治スペクトル。画像: Alclantology.org

批評家たちは、OpenAIが政治的に正しくなるためにChatGPTの機能を低下させていると非難しているが、OpenAIは公平性を保ち、そのモデルの機能は低下していないと主張している。

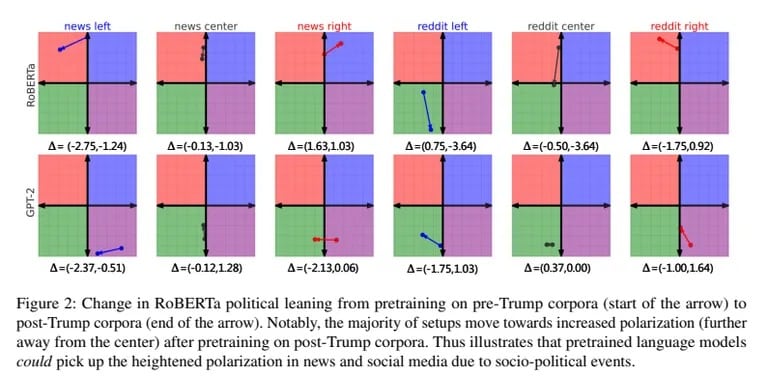

研究者たちはまた、GPT-2とメタのRoBERTaを、偏った左翼と右翼のニュースやソーシャルメディアのデータで訓練した。偏った訓練は、各モデル固有の傾向をさらに強化した。右寄りのモデルはより保守的になり、左寄りのモデルはよりリベラルになった

。

バイアスは、モデルがヘイトスピーチや誤った情報をどのように分類するかにも影響した。左派寄りのAIは、マイノリティに対するヘイトには敏感だったが、左派が生成した誤情報を却下した。右寄りのAIはその逆だった。

「右寄りの情報源のコーパスで事前学習させると、ニューヨーク・タイムズのニュースから事実の矛盾を識別するのが得意になる」と研究者は結論づけた

。

OpenAIとMetaが秘密のAIレシピを洗練させる一方で、イーロン・マスクはxAIで独自のフィルターなしAIを追求している。「AIに嘘をつくことを強制するな」と彼はツイートし、透明で真実を語るAIを作るという目標を説明した。

AIに懐疑的な人々は、制約のないAIが意図しない結果を引き起こす可能性があると感じている。しかしマスクは、「AIを政治的に正しくなるように訓練する」ことも危険だと考えている。優秀な人材を集めているxAIで、マスクは明らかにOpenAIの優位性に挑戦したいと考えている。純粋な「信念」を共有する生のAIという彼のビジョンは、説得力があると同時に懸念材料でもある。

というのも、AIは政治的な違いとともに進化し続けるからだ。この最新の研究を踏まえると、完全に偏りのないAIというのは空想的なものに思える。結局のところ、私たち欠陥だらけの人間と同じように、AIも政治的スペクトラムのどこかに位置する運命にあるようだ。

政治的な意見を持つことは、AIが達成できる最も人間的なことなのかもしれない。