Ein in China entwickeltes Modell der künstlichen Intelligenz (KI) schlägt in mehrfacher Hinsicht hohe Wellen, unter anderem wegen seiner Open-Source-Natur und seiner Fähigkeit, bis zu 200.000 Kontext-Token zu verarbeiten – was andere populäre Modelle wie Claude von Anthropic (100.000 Token) oder GPT-4 Turbo von OpenAI (128.000 Token) bei weitem übertrifft.

Die Beijing Lingyi Wanwu Information Technology Company hat diesen fortschrittlichen generativen Chatbot in ihrem KI-Labor, 01.AI, entwickelt. Das große Sprachmodell (Large Language Model, LLM) gibt es in zwei Versionen: das leichte Yi-6B-200K und das robustere Yi-34B-200K, die beide in der Lage sind, einen großen Gesprächskontext zu speichern und Englisch und Mandarin zu verstehen.

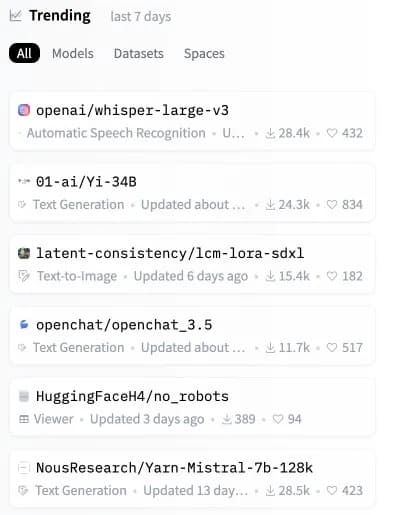

Nur wenige Stunden nach seiner Veröffentlichung stieg das Yi-Modell in den Charts zum zweitbeliebtesten Open-Source-Modell auf Hugging Face, einem wichtigen Repository für KI-Modelle, auf

Bild: Hugging Face

Auch wenn die Yi-Modelle mit großen Kontextaufforderungen umgehen können, sind sie sehr effizient und genau und schlagen andere LLMs in mehreren synthetischen Benchmarks.

„Yi-34B übertrifft viel größere Modelle wie LLaMA2-70B und Falcon-180B; außerdem kann die Größe von Yi-34B Anwendungen kosteneffizient unterstützen, was es Entwicklern ermöglicht, fantastische Projekte zu entwickeln“, erklärt 01.AI auf seiner Website. Laut einer von den Entwicklern zur Verfügung gestellten Ergebnisliste zeigte das leistungsstärkste Yi-Modell starke Leistungen beim Leseverständnis, beim logischen Denken und bei gängigen KI-Tests wie Gaokao und C-eval.

Große Sprachmodelle (Large Language Models, LLMs) wie die Yi-Serie analysieren und erzeugen sprachbasierte Ergebnisse. Sie arbeiten, indem sie „Token“ oder Texteinheiten verarbeiten, die so klein wie ein Wort oder ein Teil eines Wortes sein können.

Die Angabe „200K Tokens of Context“ bedeutet, dass das Modell wesentlich längere Eingabeaufforderungen verstehen und beantworten kann, was früher selbst die fortschrittlichsten LLMs überfordert hätte. Die Yi Series kann umfangreiche Eingabeaufforderungen mit komplexeren und detaillierteren Informationen verarbeiten, ohne abzustürzen.

Eine kürzlich von Dritten durchgeführte Analyse weist jedoch auf eine Einschränkung in diesem Bereich hin. Wenn eine Eingabeaufforderung mehr als 65 % der Kapazität des Yi-Modells in Anspruch nimmt, kann es Schwierigkeiten haben, genaue Informationen abzurufen. Wenn die Größe der Eingabeaufforderung jedoch deutlich unter diesem Schwellenwert gehalten wird, erbringt das Yi-Modell selbst in Szenarien, die bei Modellen wie Claude und ChatGPT zu einer Verschlechterung führen, hervorragende Leistungen.

Drucktest GPT-4-128K mit langem Kontexterinnerungswert

128K Kontext-Token sind großartig – aber wie sieht es mit der Leistung aus?

Das wollte ich herausfinden und habe eine „Nadel im Heuhaufen“-Analyse durchgeführt

Einige erwartete (und unerwartete) Ergebnisse

Hier sind die Ergebnisse:

Befunde:

* GPT-4’s recall… pic.twitter.com/nHMokmfhW5– Greg Kamradt (@GregKamradt) November 8, 2023

Ein wesentliches Unterscheidungsmerkmal von Yi ist, dass es vollständig quelloffen ist und die Benutzer Yi lokal auf ihren eigenen Systemen ausführen können. Dies gibt ihnen eine größere Kontrolle, die Möglichkeit, die Modellarchitektur zu ändern, und vermeidet die Abhängigkeit von externen Servern.

„Wir sagen voraus, dass KI 2.0 eine Plattform schaffen wird, die zehnmal größer ist als das mobile Internet und die gesamte Software und die Benutzeroberflächen umschreibt“, erklärt 01.AI. „Dieser Trend wird die nächste Welle von KI-Anwendungen und KI-gestützten Geschäftsmodellen hervorbringen und KI 2.0-Innovationen mit der Zeit fördern.“

Indem 01.AI ein solch leistungsfähiges Modell offenlegt, ermöglicht es Entwicklern weltweit, die nächste Generation von KI zu entwickeln. Mit einer immensen Kontextverarbeitung in einem anpassbaren Paket können wir eine Flut innovativer Anwendungen erwarten, die Yi nutzen.

Das Potenzial von Open-Source-Modellen wie Yi-6B-200K und Yi-34B-200K ist enorm. Da KI unser Leben durchdringt, versprechen lokal betriebene Systeme mehr Transparenz, Sicherheit und Anpassungsfähigkeit im Vergleich zu geschlossenen, von der Cloud abhängigen Alternativen.

Während Claude und GPT-4 Turbo für Schlagzeilen sorgen, könnte diese neue Open-Source-Alternative schon bald die nächste Stufe der KI direkt auf den Geräten der Nutzer aufbauen. Gerade als es so aussah, als gäbe es keine Möglichkeiten mehr, unsere Hardware aufzurüsten, könnte es an der Zeit sein, ein leistungsfähigeres Gerät zu kaufen, bevor Sie feststellen, dass Ihre lokale KI von einem „kontextbewussten“ Konkurrenten überflügelt wird