Un modelo de inteligencia artificial (IA) desarrollado en China está causando sensación en varios frentes, entre ellos su naturaleza de código abierto y su capacidad para manejar hasta 200.000 tokens de contexto, superando con creces a otros modelos populares como Claude de Anthropic (100.000 tokens) o GPT-4 Turbo de OpenAI (128.000 tokens).

Bautizada como la serie Yi, la empresa Beijing Lingyi Wanwu Information Technology creó este chatbot generativo progresivo en su laboratorio de IA, 01.AI. El gran modelo lingüístico (LLM) se presenta en dos versiones: la ligera Yi-6B-200K y la más robusta Yi-34B-200K, ambas capaces de retener un inmenso contexto conversacional y capaces de entender inglés y mandarín.

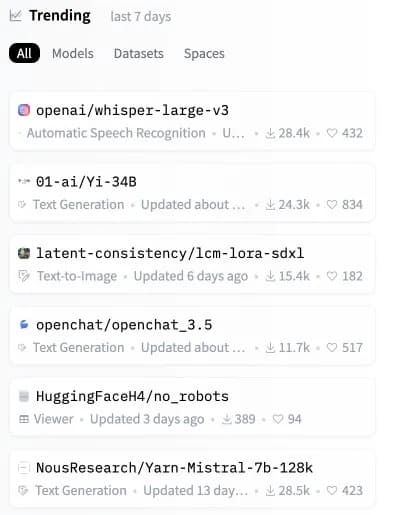

Pocas horas después de su lanzamiento, el modelo Yi subió como la espuma hasta convertirse en el segundo modelo de código abierto más popular en Hugging Face, un repositorio clave para modelos de inteligencia artificial.

Imagen: Hugging Face

A pesar de que los modelos Yi manejan peticiones de contexto enormes, también son muy eficientes y precisos, superando a otros LLM en varias pruebas de referencia sintéticas.

«Yi-34B supera a modelos mucho más grandes como LLaMA2-70B y Falcon-180B; además, el tamaño de Yi-34B puede soportar aplicaciones de forma rentable, lo que permite a los desarrolladores crear proyectos fantásticos», explica 01.AI en su página web. Según un cuadro de indicadores compartido por los desarrolladores, el modelo Yi más potente mostró un gran rendimiento en comprensión lectora, razonamiento de sentido común y pruebas habituales de IA como Gaokao y C-eval.

Los grandes modelos lingüísticos (LLM), como la serie Yi, analizan y generan resultados basados en el lenguaje. Trabajan procesando «tokens» o unidades de texto, que pueden ser tan pequeñas como una palabra o una parte de una palabra.

Decir «200.000 tokens de contexto» significa que el modelo puede entender y responder a preguntas mucho más largas, que antes habrían desbordado incluso a los LLM más avanzados. La serie Yi es capaz de responder a preguntas extensas que incluyen información más compleja y detallada sin bloquearse.

Sin embargo, un reciente análisis de terceros señala una limitación en este ámbito. Cuando una consulta ocupa más del 65% de la capacidad del modelo Yi, éste puede tener problemas para recuperar información precisa. A pesar de ello, si el tamaño del prompt se mantiene muy por debajo de este umbral, el modelo de la serie Yi rinde admirablemente, incluso en escenarios que causan degradación en modelos como Claude y ChatGPT.

Pruebas de presión GPT-4-128K con larga recuperación de contexto

128.000 tokens de contexto es increíble, pero ¿qué tal es el rendimiento?

Quería averiguarlo, así que hice un análisis de «aguja en un pajar».

Algunos resultados esperados (e inesperados)

Esto es lo que encontré:

Hallazgos:

pic.twitter.com/nHMokmfhW5– Greg Kamradt (@GregKamradt) 8 de noviembre de 2023

Un elemento diferenciador clave de Yi es que es totalmente de código abierto, lo que permite a los usuarios ejecutar Yi localmente en sus propios sistemas. Esto les otorga un mayor control, la posibilidad de modificar la arquitectura del modelo y evita la dependencia de servidores externos.

«Predecimos que la IA 2.0 creará una oportunidad de plataforma diez veces mayor que Internet móvil, reescribiendo todo el software y las interfaces de usuario», afirma 01.AI. «Esta tendencia dará lugar a la próxima ola de aplicaciones AI-first y modelos de negocio potenciados por la IA, fomentando las innovaciones AI 2.0 con el tiempo».

Al abrir un modelo tan capaz, 01.AI permite a los desarrolladores de todo el mundo construir la próxima generación de IA. Con un inmenso manejo del contexto en un paquete personalizable, podemos esperar un torrente de aplicaciones innovadoras que utilicen Yi.

El potencial de modelos de código abierto como Yi-6B-200K y Yi-34B-200K está por las nubes. A medida que la IA impregna nuestras vidas, los sistemas de ejecución local prometen mayor transparencia, seguridad y personalización en comparación con las alternativas cerradas dependientes de la nube.

Mientras Claude y GPT-4 Turbo acaparan los titulares, esta nueva alternativa de código abierto pronto podría construir la próxima etapa de la IA directamente en los dispositivos de los usuarios. Justo cuando parecía que ya no quedaban formas de actualizar nuestro hardware, puede que sea el momento de comprar un dispositivo más capaz antes de que tu IA local se vea superada por un competidor más «consciente del contexto».