中国开发的一款人工智能(AI)模型正在多个领域掀起波澜,其中包括其开源性和处理多达20万个代币上下文的能力–大大超过了其他流行模型,如Anthropic的Claude(10万个代币)或OpenAI的GPT-4 Turbo(12.8万个代币)。

北京灵翼万物信息技术有限公司在其人工智能实验室 01.AI 创造了这款渐进式生成聊天机器人,被称为 Yi 系列。该大型语言模型(LLM)有两个版本:轻便的Yi-6B-200K和更强大的Yi-34B-200K,两者都能保留大量的对话语境,并能听懂英语和普通话。

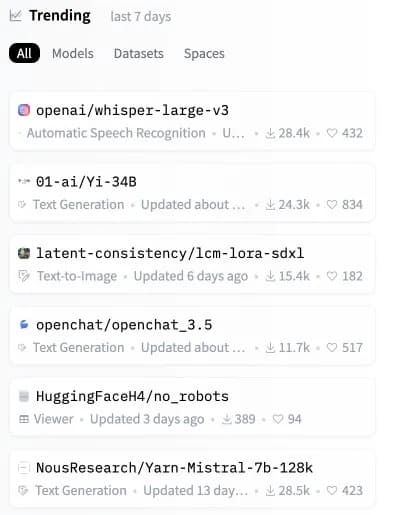

Yi 模型发布仅数小时后,就一跃成为人工智能模型主要存储库 Hugging Face 上第二受欢迎的开源模型。

Image: Hugging Face

尽管 Yi 模型可以处理庞大的上下文提示,但它们也非常高效和准确,在多个合成基准测试中击败了其他 LLM。

“01.AI在其网站上解释说:”Yi-34B的性能超过了LLaMA2-70B和Falcon-180B等更大的模型;而且Yi-34B的大小可以经济高效地支持应用程序,从而使开发人员能够构建出精彩的项目。根据开发者分享的记分牌,最强大的 Yi 模型在阅读理解、常识推理以及高考和 C-eval 等常见人工智能测试中表现出色。

像 Yi 系列这样的大型语言模型(LLM)通过分析和生成基于语言的输出来运行。它们通过处理 “词块 “或文本单位来工作,词块可以小到一个单词或单词的一部分。

说 “20 万个语境词块”,实际上意味着该模型可以理解并响应更长的提示,而在此之前,即使是最先进的 LLM 也无法做到这一点。Yi Series 可以处理包含更复杂、更详细的信息的大量提示,而不会崩溃。

不过,最近的一份第三方分析报告指出了这一领域的局限性。当一个提示占据 Yi 型号容量的 65% 以上时,它就很难检索到准确的信息。尽管如此,如果将提示符的大小控制在这一临界值以下,Yi 系列机型的表现还是令人钦佩的,即使是在会导致 Claude 和 ChatGPT.

等机型性能下降的情况下也是如此。

使用长语境召回对 GPT-4-128K 进行压力测试

128K 个字段的上下文很不错,但性能如何呢?

我想找出答案,因此进行了 “大海捞针 “式的分析

一些意料之中(和意料之外)的结果

以下是我的发现:

结果:

* GPT-4 的召回……pic.twitter.com/nHMokmfhW5-格雷格-卡姆拉特(@GregKamradt)2023 年 11 月 8 日

。

Yi的一个关键与众不同之处在于它完全开源,允许用户在自己的系统上本地运行Yi。这使他们拥有更大的控制权,能够修改模型架构,并避免依赖外部服务器。

“我们预测,人工智能 2.0 将创造一个比移动互联网大十倍的平台机会,重写所有软件和用户界面,”01.AI 表示。”这一趋势将催生下一波人工智能优先应用和人工智能赋能的商业模式,随着时间的推移促进人工智能 2.0 的创新。”

01.AI开源了这样一个功能强大的模型,使全球开发人员能够构建下一代人工智能。在一个可定制的软件包中处理大量的上下文,我们可以预见,利用 Yi 的创新应用将如洪流般涌现。

Yi-6B-200K和Yi-34B-200K等开源型号的潜力是巨大的。随着人工智能渗透到我们的生活中,与依赖云的封闭式替代方案相比,本地运行的系统具有更高的透明度、安全性和可定制性。

虽然克劳德和 GPT-4 Turbo 抢占了头条,但这种新的开源替代方案可能很快就会在用户的设备上构建人工智能的下一阶段。就在我们似乎没有其他方法来升级我们的硬件时,也许是时候选购一款功能更强大的设备了,以免你发现自己的本地人工智能被更 “情境感知 “的竞争对手超越。