Un modèle d’intelligence artificielle (IA) développé en Chine fait des vagues sur un certain nombre de fronts, notamment sa nature open-source et sa capacité à gérer jusqu’à 200 000 tokens de contexte, dépassant largement d’autres modèles populaires tels que Claude d’Anthropic (100 000 tokens) ou GPT-4 Turbo d’OpenAI (128 000 tokens).

Surnommé la série Yi, Beijing Lingyi Wanwu Information Technology Company a créé ce chatbot génératif progressif dans son laboratoire d’IA, 01.AI. Le grand modèle linguistique (LLM) se décline en deux versions : le léger Yi-6B-200K et le plus robuste Yi-34B-200K, tous deux capables de conserver un immense contexte conversationnel et de comprendre l’anglais et le mandarin.

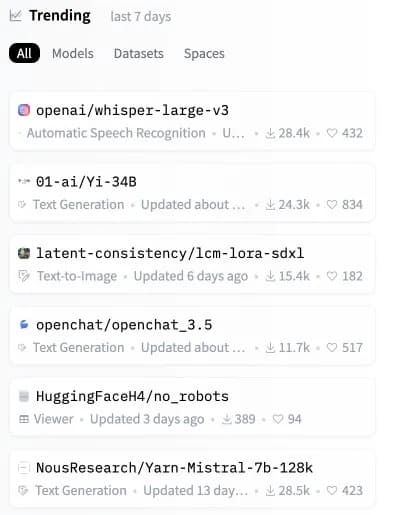

Quelques heures à peine après sa sortie, le modèle Yi a grimpé en flèche pour devenir le deuxième modèle open-source le plus populaire sur Hugging Face, un référentiel clé pour les modèles d’IA.

Image : Hugging Face

Même si les modèles Yi gèrent d’énormes invites contextuelles, ils sont également très efficaces et précis, battant d’autres LLM dans plusieurs benchmarks synthétiques.

« Yi-34B surpasse des modèles beaucoup plus grands comme LLaMA2-70B et Falcon-180B. La taille de Yi-34B permet également de prendre en charge des applications de manière rentable, permettant ainsi aux développeurs de créer des projets fantastiques », explique 01.AI sur son site web. Selon un tableau de bord partagé par les développeurs, le modèle Yi le plus puissant a montré de bonnes performances en compréhension de la lecture, en raisonnement de bon sens et dans des tests d’IA courants tels que Gaokao et C-eval.

Les grands modèles linguistiques (LLM) tels que la série Yi fonctionnent en analysant et en générant des résultats basés sur le langage. Ils traitent des « tokens », ou unités de texte, qui peuvent être aussi petits qu’un mot ou une partie de mot.

Dire « 200 000 tokens de contexte » signifie en fait que le modèle peut comprendre et répondre à des invites beaucoup plus longues, ce qui aurait auparavant dépassé même les LLM les plus avancés. La série Yi est capable de traiter des requêtes étendues qui comprennent des informations plus complexes et plus détaillées sans se bloquer.

Une analyse récente réalisée par une tierce partie met toutefois en évidence une limitation dans ce domaine. Lorsqu’une invite occupe plus de 65 % de la capacité du modèle Yi, celui-ci peut avoir du mal à récupérer des informations précises. Malgré cela, si la taille de l’invite est maintenue bien en dessous de ce seuil, le modèle de la série Yi fonctionne admirablement, même dans des scénarios qui entraînent la dégradation de modèles tels que Claude et ChatGPT.

Test de pression GPT-4-128K avec un long rappel de contexte

128K tokens de contexte, c’est génial – mais qu’en est-il des performances ?

J’ai voulu le savoir et j’ai donc effectué une analyse « aiguille dans la botte de foin ».

Quelques résultats attendus (et inattendus)

Voici ce que j’ai trouvé :

Résultats :

* Le rappel de GPT-4… pic.twitter.com/nHMokmfhW5– Greg Kamradt (@GregKamradt) November 8, 2023

Un élément clé de différenciation de Yi est qu’il est entièrement open source, ce qui permet aux utilisateurs d’exécuter Yi localement sur leurs propres systèmes. Cela leur donne un plus grand contrôle, la possibilité de modifier l’architecture du modèle, et évite de dépendre de serveurs externes.

« Nous prévoyons que l’IA 2.0 créera une opportunité de plateforme dix fois plus importante que l’internet mobile, réécrivant tous les logiciels et les interfaces utilisateur », déclare 01.AI. « Cette tendance donnera naissance à la prochaine vague d’applications fondées sur l’IA et de modèles commerciaux fondés sur l’IA, ce qui favorisera les innovations en matière d’IA 2.0 au fil du temps.

En mettant à disposition un modèle aussi performant, 01.AI permet aux développeurs du monde entier de créer la prochaine génération d’IA. Grâce à une immense gestion du contexte dans un ensemble personnalisable, nous pouvons nous attendre à un torrent d’applications innovantes utilisant Yi.

Le potentiel est énorme pour les modèles open-source tels que Yi-6B-200K et Yi-34B-200K. À mesure que l’IA pénètre nos vies, les systèmes exécutés localement promettent plus de transparence, de sécurité et de personnalisation que les solutions fermées qui dépendent du cloud.

Alors que Claude et GPT-4 Turbo font les gros titres, cette nouvelle alternative open-source pourrait bientôt construire la prochaine étape de l’IA directement sur les appareils des utilisateurs. Alors qu’il semblait n’y avoir plus aucun moyen d’améliorer notre matériel, il est peut-être temps d’acheter un appareil plus performant avant que votre IA locale ne soit surclassée par un concurrent plus « conscient du contexte ».