Een kunstmatige intelligentie (AI)-model dat in China is ontwikkeld, maakt opzienbarend nieuws op een aantal fronten, waaronder zijn open-source karakter en zijn vermogen om tot 200.000 tokens aan context te verwerken – veel meer dan andere populaire modellen zoals Anthropic’s Claude (100.000 tokens) of OpenAI’s GPT-4 Turbo (128.000 tokens).

Beijing Lingyi Wanwu Information Technology Company heeft deze vooruitstrevende generatieve chatbot gemaakt in zijn AI-lab, 01.AI, onder de naam Yi-serie. Het grote taalmodel (LLM) is er in twee versies: de lichtgewicht Yi-6B-200K en de robuustere Yi-34B-200K, die beide in staat zijn om een immense conversatiecontext te behouden en Engels en Mandarijn kunnen verstaan.

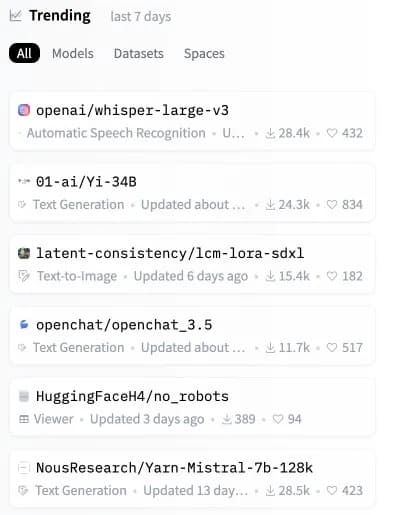

Slechts enkele uren na de release steeg het Yi-model in de hitlijsten en werd het het op één na populairste open-source model op Hugging Face, een belangrijke opslagplaats voor AI-modellen.

Afbeelding: Hugging Face

Hoewel de Yi-modellen enorme contextvragen aankunnen, zijn ze ook erg efficiënt en nauwkeurig en verslaan ze andere LLM’s in verschillende synthetische benchmarks.

“Yi-34B presteert beter dan veel grotere modellen zoals LLaMA2-70B en Falcon-180B; ook kan Yi-34B door zijn formaat applicaties kosteneffectief ondersteunen, waardoor ontwikkelaars fantastische projecten kunnen bouwen”, legt 01.AI uit op zijn website. Volgens een scorebord dat door de ontwikkelaars is gedeeld, liet het krachtigste Yi-model sterke prestaties zien in begrijpend lezen, redeneren op basis van gezond verstand en veelgebruikte AI-tests zoals Gaokao en C-eval.

Grote taalmodellen (LLM’s) zoals de Yi-serie werken door het analyseren en genereren van taalgebaseerde output. Ze werken door het verwerken van “tokens”, of eenheden van tekst, die zo klein kunnen zijn als een woord of een deel van een woord.

200K tokens of context” betekent in feite dat het model aanzienlijk langere prompts kan begrijpen en erop kan reageren, wat voorheen zelfs de meest geavanceerde LLM’s zou hebben overweldigd. De Yi Series kan uitgebreide prompts aan die complexere en meer gedetailleerde informatie bevatten zonder te crashen.

Een recente analyse door derden wijst echter op een beperking op dit gebied. Als een prompt meer dan 65% van de capaciteit van het Yi-model in beslag neemt, kan het moeite hebben om nauwkeurige informatie op te halen. Desondanks, als de grootte van de prompt ruim onder deze drempel wordt gehouden, presteert het Yi-serie model bewonderenswaardig, zelfs in scenario’s die achteruitgang veroorzaken in modellen als Claude en ChatGPT.

Druktest GPT-4-128K met lange contextherinnering

128K tokens aan context is geweldig – maar hoe zijn de prestaties?

Daar wilde ik achter komen, dus ik heb een “naald in een hooiberg” analyse gedaan

Enkele verwachte (en onverwachte) resultaten

Dit is wat ik vond:

Bevindingen:

* GPT-4’s terugroepactie… pic.twitter.com/nHMokmfhW5– Greg Kamradt (@GregKamradt) November 8, 2023

Een belangrijke onderscheidende factor voor Yi is dat het volledig open source is, waardoor gebruikers Yi lokaal op hun eigen systemen kunnen draaien. Hierdoor hebben ze meer controle, kunnen ze de architectuur van het model aanpassen en zijn ze niet afhankelijk van externe servers.

“We voorspellen dat AI 2.0 een platformmogelijkheid zal creëren die tien keer groter is dan het mobiele internet en alle software en gebruikersinterfaces zal herschrijven,” stelt 01.AI. “Deze trend zal leiden tot de volgende golf van AI-eerste toepassingen en AI-ondersteunde bedrijfsmodellen, waardoor AI 2.0-innovaties in de loop van de tijd worden gestimuleerd.”

Door het open-sourcen van zo’n capabel model stelt 01.AI ontwikkelaars wereldwijd in staat om de volgende generatie AI te bouwen. Met een immense contextverwerking in een aanpasbaar pakket, kunnen we een stortvloed aan innovatieve toepassingen verwachten die gebruik maken van Yi.

Het potentieel is torenhoog voor open-source modellen zoals Yi-6B-200K en Yi-34B-200K. Nu AI ons leven doordringt, beloven lokaal beheerde systemen meer transparantie, veiligheid en aanpasbaarheid in vergelijking met gesloten alternatieven die afhankelijk zijn van de cloud.

Terwijl Claude en GPT-4 Turbo de krantenkoppen halen, kan dit nieuwe open-source alternatief binnenkort de volgende fase van AI rechtstreeks op de apparaten van gebruikers bouwen. Net nu het erop leek dat er geen manieren meer waren om onze hardware te upgraden, is het misschien tijd om te shoppen voor een meer capabel apparaat voordat je lokale AI wordt overtroffen door een meer “contextbewuste” concurrent.