中国で開発された人工知能(AI)モデルが、オープンソースであること、最大20万トークンのコンテキストを処理できることなど、さまざまな面で話題を呼んでいます。

Yiシリーズと呼ばれるこの先進的な生成チャットボットは、北京臨沂万武信息技術有限公司のAIラボ「01.AI」で開発された。大型言語モデル(LLM)には、軽量なYi-6B-200Kと、より堅牢なYi-34B-200Kの2つのバージョンがあり、どちらも膨大な会話文脈を保持し、英語と北京語を理解することができる。

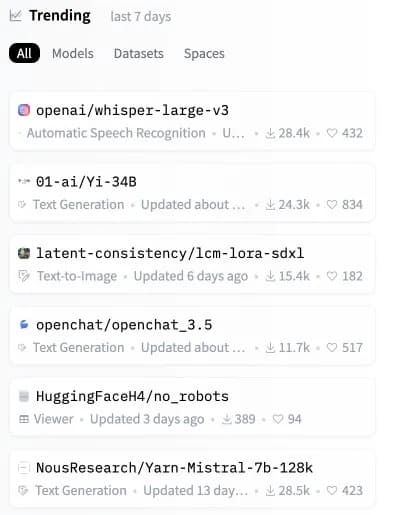

リリースからわずか数時間後、Yiモデルはチャートを急上昇させ、AIモデルの重要なリポジトリであるHugging Faceで2番目に人気のあるオープンソースモデルとなった

。

画像: Hugging Face

Yiモデルは巨大な文脈プロンプトを処理するにもかかわらず、非常に効率的で正確であり、いくつかの合成ベンチマークで他のLLMを上回っています。

「Yi-34Bは、LLaMA2-70BやFalcon-180Bのようなはるかに大きなモデルを凌駕しています。また、Yi-34Bのサイズは、アプリケーションをコスト効率よくサポートすることができ、それによって開発者は素晴らしいプロジェクトを構築することができます」と01.AIのウェブサイトで説明されている。開発者によって共有されたスコアボードによると、最も強力なYiモデルは、読解力、常識的推論、およびGaokaoやC-evalのような一般的なAIテストで強力なパフォーマンスを示した。

Yiシリーズのような大規模言語モデル(LLM)は、言語ベースの出力を分析・生成することで動作する。LLMは「トークン」、つまりテキストの単位を処理することで動作する。

200Kの文脈のトークン」と言うことは、事実上、このモデルが非常に長いプロンプトを理解し応答できることを意味する。Yiシリーズは、クラッシュすることなく、より複雑で詳細な情報を含む広範囲なプロンプトを処理できる。

しかし、最近の第三者による分析では、この分野での限界が指摘されている。プロンプトがYiモデルの容量の65%以上を占める場合、正確な情報を取得するのに苦労する可能性がある。にもかかわらず、プロンプトのサイズをこのしきい値より十分に低く保てば、ClaudeやChatGPTのようなモデルで劣化を引き起こすようなシナリオでも、Yiシリーズモデルは素晴らしいパフォーマンスを発揮する

。

GPT-4-128Kと長い文脈の想起の圧力テスト

128Kトークンのコンテキストは素晴らしいが、パフォーマンスはどうなのだろうか?

私はそれを知りたかったので、「干し草の山の中の針」分析をしてみた。

予想通りの(そして予想外の)結果

以下がその結果である:

発見:

* GPT-4のリコール… pic.twitter.com/nHMokmfhW5– Greg Kamradt (@GregKamradt) 2023年11月8日

Yiの重要な差別化点は、完全なオープンソースであることで、ユーザーは自分のシステム上でローカルにYiを実行できる。これによって、ユーザーはより大きなコントロール、モデル・アーキテクチャの変更能力、そして外部サーバーへの依存を避けることができる。

「私たちは、AI 2.0がモバイル・インターネットの10倍のプラットフォーム機会を生み出し、すべてのソフトウェアとユーザー・インターフェースを書き換えると予測しています。「このトレンドは、AIファーストのアプリケーションやAIを活用したビジネスモデルの次の波を生み出し、AI 2.0のイノベーションを長期的に促進する。

このような有能なモデルをオープンソース化することで、01.AIは世界中の開発者に次世代のAIを構築する力を与える。カスタマイズ可能なパッケージで膨大なコンテキストを処理できるため、Yiを活用した革新的なアプリケーションの奔流が期待できる。

Yi-6B-200KやYi-34B-200Kのようなオープンソースモデルの可能性は非常に高い。AIが我々の生活に浸透するにつれ、クラウドに依存したクローズドな代替品と比較して、ローカルで実行されるシステムはより高い透明性、セキュリティ、カスタマイズ性を約束する。

クロードとGPT-4ターボが注目を集める一方で、この新しいオープンソースの選択肢は、近いうちにユーザーのデバイス上でAIの次のステージを構築するかもしれない。ハードウェアをアップグレードする方法はもう残っていないと思われた矢先、「コンテキストを認識する」競合他社にローカルAIが負けていることに気づく前に、より高性能なデバイスを購入する時が来たのかもしれない。