Un modello di intelligenza artificiale (AI) sviluppato in Cina sta facendo scalpore su diversi fronti, tra cui la sua natura open source e la capacità di gestire fino a 200.000 token di contesto, superando di gran lunga altri modelli popolari come Claude di Anthropic (100.000 token) o GPT-4 Turbo di OpenAI (128.000 token).

Nominata serie Yi, la Beijing Lingyi Wanwu Information Technology Company ha creato questo chatbot generativo progressivo nel suo laboratorio di AI, 01.AI. Il modello linguistico di grandi dimensioni (LLM) è disponibile in due versioni: il leggero Yi-6B-200K e il più robusto Yi-34B-200K, entrambi in grado di conservare un immenso contesto di conversazione e di comprendere l’inglese e il mandarino.

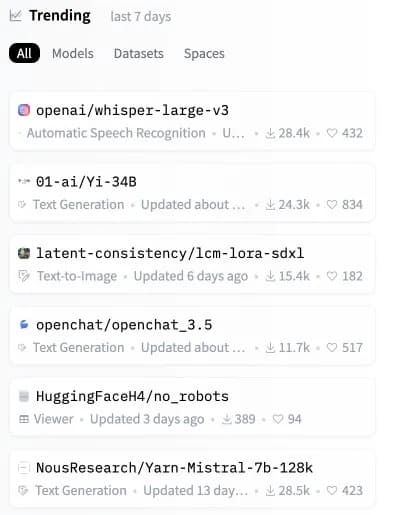

Poche ore dopo il suo rilascio, il modello Yi ha scalato le classifiche diventando il secondo modello open-source più popolare su Hugging Face, un importante repository di modelli di intelligenza artificiale.

Immagine: Hugging Face

Anche se i modelli Yi gestiscono enormi richieste di contesto, sono molto efficienti e precisi, battendo altri LLM in diversi benchmark sintetici.

“Yi-34B supera modelli molto più grandi come LLaMA2-70B e Falcon-180B; inoltre le dimensioni di Yi-34B possono supportare le applicazioni in modo economico, consentendo così agli sviluppatori di realizzare progetti fantastici”, spiega 01.AI sul suo sito web. Secondo una scheda di valutazione condivisa dagli sviluppatori, il modello Yi più potente ha mostrato ottime prestazioni nella comprensione della lettura, nel ragionamento di senso comune e nei comuni test di intelligenza artificiale come Gaokao e C-eval.

I modelli linguistici di grandi dimensioni (LLM) come la serie Yi funzionano analizzando e generando output basati sul linguaggio. Lavorano elaborando “token”, o unità di testo, che possono essere piccole come una parola o una parte di una parola.

Dire “200K tokens di contesto” significa effettivamente che il modello è in grado di comprendere e rispondere a richieste molto più lunghe, che in precedenza avrebbero sopraffatto anche i LLM più avanzati. La serie Yi è in grado di gestire richieste estese che includono informazioni più complesse e dettagliate senza bloccarsi.

Una recente analisi di terze parti, tuttavia, ha evidenziato un limite in quest’area. Quando una richiesta occupa più del 65% della capacità del modello Yi, questo può faticare a recuperare informazioni accurate. Tuttavia, se le dimensioni del prompt vengono mantenute ben al di sotto di questa soglia, il modello della serie Yi si comporta in modo eccellente, anche in scenari che causano il degrado di modelli come Claude e ChatGPT.

Test di pressione GPT-4-128K con un lungo richiamo di contesto

128K token di contesto sono fantastici, ma come sono le prestazioni?

Volevo scoprirlo, così ho fatto un’analisi “ago in un pagliaio”.

Alcuni risultati attesi (e inaspettati)

Ecco cosa ho trovato:

Risultati:

* Il richiamo del GPT-4… pic.twitter.com/nHMokmfhW5– Greg Kamradt (@GregKamradt) November 8, 2023

Un elemento chiave di differenziazione di Yi è che è completamente open source, consentendo agli utenti di eseguire Yi localmente sui propri sistemi. Questo garantisce un maggiore controllo, la possibilità di modificare l’architettura del modello e di evitare la dipendenza da server esterni.

“Prevediamo che l’AI 2.0 creerà un’opportunità di piattaforma dieci volte più grande dell’Internet mobile, riscrivendo tutti i software e le interfacce utente”, dichiara 01.AI. “Questa tendenza darà origine alla prossima ondata di applicazioni AI-first e di modelli di business AI-empowered, favorendo nel tempo le innovazioni AI 2.0”.

Con l’open-sourcing di un modello così capace, 01.AI consente agli sviluppatori di tutto il mondo di costruire la prossima generazione di IA. Grazie all’immensa gestione del contesto in un pacchetto personalizzabile, possiamo aspettarci una marea di applicazioni innovative che utilizzano Yi.

Il potenziale è altissimo per modelli open-source come Yi-6B-200K e Yi-34B-200K. Mentre l’intelligenza artificiale permea le nostre vite, i sistemi gestiti localmente promettono maggiore trasparenza, sicurezza e personalizzazione rispetto alle alternative chiuse che dipendono dal cloud.

Mentre Claude e GPT-4 Turbo fanno notizia, questa nuova alternativa open-source potrebbe presto costruire il prossimo stadio dell’IA direttamente sui dispositivi degli utenti. Proprio quando sembrava che non ci fossero più modi per aggiornare il nostro hardware, potrebbe essere il momento di acquistare un dispositivo più capace prima di scoprire che la vostra IA locale è stata surclassata da un concorrente più “context-aware”.