Model sztucznej inteligencji (AI) opracowany w Chinach robi furorę na wielu frontach, w tym ze względu na swój charakter open-source i zdolność do obsługi do 200 000 tokenów kontekstu – znacznie przewyższając inne popularne modele, takie jak Claude firmy Anthropic (100 000 tokenów) lub GPT-4 Turbo firmy OpenAI (128 000 tokenów).

Nazwana serią Yi, firma Beijing Lingyi Wanwu Information Technology Company stworzyła tego progresywnego chatbota generatywnego w swoim laboratorium AI, 01.AI. Duży model językowy (LLM) jest dostępny w dwóch wersjach: lekkiej Yi-6B-200K i bardziej wytrzymałej Yi-34B-200K, obie zdolne do zachowania ogromnego kontekstu konwersacji i rozumienia języka angielskiego i mandaryńskiego.

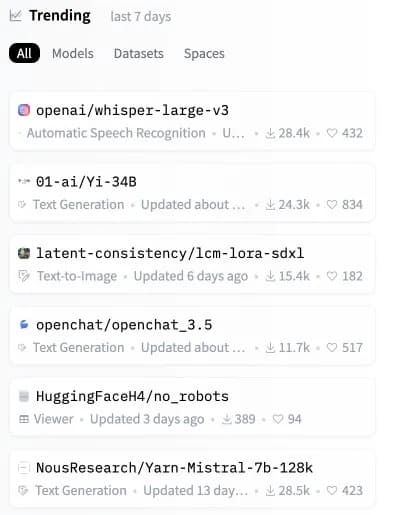

Zaledwie kilka godzin po premierze, model Yi wystrzelił w górę list przebojów, stając się drugim najpopularniejszym modelem open-source na Hugging Face, kluczowym repozytorium modeli sztucznej inteligencji.

Image: Hugging Face

Modele Yi radzą sobie z ogromnymi podpowiedziami kontekstowymi, ale są również bardzo wydajne i dokładne, pokonując inne modele LLM w kilku syntetycznych testach porównawczych.

„Yi-34B przewyższa znacznie większe modele, takie jak LLaMA2-70B i Falcon-180B; również rozmiar Yi-34B może obsługiwać aplikacje w opłacalny sposób, umożliwiając w ten sposób programistom tworzenie fantastycznych projektów”, wyjaśnia 01.AI na swojej stronie internetowej. Zgodnie z tabelą wyników udostępnioną przez deweloperów, najpotężniejszy model Yi wykazał wysoką wydajność w czytaniu ze zrozumieniem, zdroworozsądkowym rozumowaniu i popularnych testach AI, takich jak Gaokao i C-eval.

Duże modele językowe (LLM), takie jak seria Yi, działają poprzez analizowanie i generowanie danych wyjściowych opartych na języku. Działają one poprzez przetwarzanie „tokenów” lub jednostek tekstu, które mogą być tak małe jak słowo lub część słowa.

Stwierdzenie „200 tys. tokenów kontekstu” oznacza, że model może zrozumieć i odpowiedzieć na znacznie dłuższe podpowiedzi, które wcześniej przerosłyby nawet najbardziej zaawansowane systemy LLM. Seria Yi może obsługiwać obszerne podpowiedzi, które zawierają bardziej złożone i szczegółowe informacje bez awarii.

Niedawna analiza przeprowadzona przez stronę trzecią wskazuje jednak na ograniczenie w tym obszarze. Gdy monit zajmuje więcej niż 65% pojemności modelu Yi, może on mieć trudności z pobraniem dokładnych informacji. Mimo to, jeśli rozmiar monitu jest utrzymywany znacznie poniżej tego progu, model z serii Yi działa znakomicie, nawet w scenariuszach, które powodują degradację w modelach takich jak Claude i ChatGPT.

Testy ciśnieniowe GPT-4-128K z długim przywoływaniem kontekstu

128 tys. tokenów kontekstu to niesamowity wynik – ale jak wygląda wydajność?

Chciałem się tego dowiedzieć, więc przeprowadziłem analizę „igły w stogu siana”

Kilka oczekiwanych (i nieoczekiwanych) wyników

Oto co znalazłem:

Wyniki:

* GPT-4’s recall… pic.twitter.com/nHMokmfhW5– Greg Kamradt (@GregKamradt) November 8, 2023

Kluczowym wyróżnikiem Yi jest to, że jest w pełni open source, umożliwiając użytkownikom uruchamianie Yi lokalnie na ich własnych systemach. Daje im to większą kontrolę, możliwość modyfikowania architektury modelu i pozwala uniknąć zależności od zewnętrznych serwerów.

„Przewidujemy, że AI 2.0 stworzy platformę dziesięciokrotnie większą niż mobilny Internet, przepisując całe oprogramowanie i interfejsy użytkownika” – stwierdza 01.AI. „Trend ten da początek kolejnej fali aplikacji opartych na sztucznej inteligencji i modeli biznesowych opartych na sztucznej inteligencji, wspierając z czasem innowacje AI 2.0”.

Udostępniając tak wydajny model, 01.AI umożliwia programistom na całym świecie tworzenie sztucznej inteligencji nowej generacji. Dzięki ogromnej obsłudze kontekstu w konfigurowalnym pakiecie możemy spodziewać się potoku innowacyjnych aplikacji wykorzystujących Yi.

Potencjał modeli open-source, takich jak Yi-6B-200K i Yi-34B-200K, jest ogromny. W miarę jak sztuczna inteligencja przenika do naszego życia, lokalnie uruchamiane systemy obiecują większą przejrzystość, bezpieczeństwo i możliwość dostosowania w porównaniu do zamkniętych alternatyw zależnych od chmury.

Podczas gdy Claude i GPT-4 Turbo trafiają na pierwsze strony gazet, ta nowa alternatywa o otwartym kodzie źródłowym może wkrótce zbudować kolejny etap sztucznej inteligencji bezpośrednio na urządzeniach użytkowników. Właśnie wtedy, gdy wydawało się, że nie ma już innych sposobów na ulepszenie naszego sprzętu, może nadszedł czas, aby kupić bardziej wydajne urządzenie, zanim okaże się, że lokalna sztuczna inteligencja została zdeklasowana przez bardziej „świadomego kontekstu” konkurenta.