Um modelo de inteligência artificial (IA) desenvolvido na China está a fazer ondas em várias frentes, incluindo a sua natureza de código aberto e a sua capacidade de lidar com até 200.000 tokens de contexto – excedendo largamente outros modelos populares como o Claude da Anthropic (100.000 tokens) ou o GPT-4 Turbo da OpenAI (128.000 tokens).

Denominada série Yi, a Beijing Lingyi Wanwu Information Technology Company criou este chatbot generativo progressivo no seu laboratório de IA, 01.AI. O modelo de linguagem de grande dimensão (LLM) está disponível em duas versões: o leve Yi-6B-200K e o mais robusto Yi-34B-200K, ambos capazes de reter um imenso contexto de conversação e de compreender inglês e mandarim.

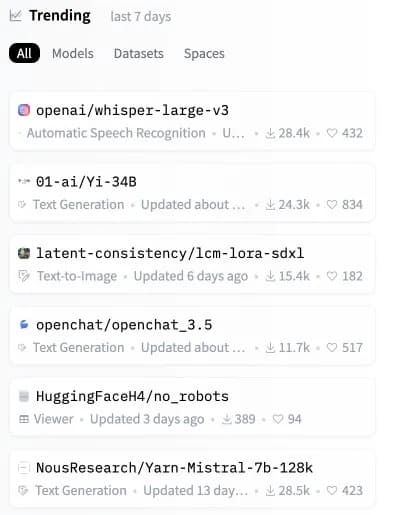

Poucas horas após o seu lançamento, o modelo Yi disparou nas tabelas, tornando-se o segundo modelo de código aberto mais popular no Hugging Face, um repositório chave para modelos de IA.

Imagem: Hugging Face

Embora os modelos Yi lidem com solicitações de contexto enormes, também são muito eficientes e precisos, superando outros LLMs em vários benchmarks sintéticos.

“O Yi-34B supera modelos muito maiores, como o LLaMA2-70B e o Falcon-180B; além disso, o tamanho do Yi-34B pode suportar aplicações de forma económica, permitindo assim que os programadores criem projectos fantásticos”, explica a 01.AI no seu site. De acordo com um painel de avaliação partilhado pelos criadores, o modelo Yi mais potente mostrou um forte desempenho na compreensão de leitura, no raciocínio de senso comum e em testes de IA comuns, como o Gaokao e o C-eval.

Os modelos de linguagem de grande dimensão (LLM), como a série Yi, funcionam analisando e gerando resultados baseados na linguagem. Funcionam através do processamento de “tokens”, ou unidades de texto, que podem ser tão pequenas como uma palavra ou parte de uma palavra.

Dizer “200K tokens de contexto” significa efetivamente que o modelo pode compreender e responder a pedidos significativamente mais longos, que anteriormente teriam sobrecarregado até os LLMs mais avançados. A série Yi pode lidar com pedidos extensos que incluem informações mais complexas e detalhadas sem falhar.

No entanto, uma análise recente efectuada por terceiros aponta para uma limitação nesta área. Quando uma mensagem ocupa mais de 65% da capacidade do modelo Yi, este pode ter dificuldade em obter informações exactas. Apesar disso, se o tamanho do prompt for mantido bem abaixo desse limite, o modelo da série Yi tem um desempenho admirável, mesmo em cenários que causam degradação em modelos como Claude e ChatGPT.

Teste de pressão GPT-4-128K com recordação de contexto longo

128K tokens de contexto é fantástico – mas como é o desempenho?

Eu queria descobrir, então fiz uma análise “agulha num palheiro”

Alguns resultados esperados (e inesperados)

Eis o que descobri:

Resultados:

* O recall do GPT-4… pic.twitter.com/nHMokmfhW5– Greg Kamradt (@GregKamradt) 8 de novembro de 2023

Um dos principais diferenciais do Yi é o facto de ser totalmente de código aberto, permitindo aos utilizadores executarem o Yi localmente nos seus próprios sistemas. Isto confere-lhes um maior controlo, a capacidade de modificar a arquitetura do modelo e evita a dependência de servidores externos.

“Prevemos que a IA 2.0 criará uma oportunidade de plataforma dez vezes maior do que a Internet móvel, reescrevendo todo o software e interfaces de utilizador”, afirma a 01.AI. “Esta tendência dará origem à próxima vaga de aplicações que priorizam a IA e de modelos de negócio potenciados pela IA, promovendo inovações de IA 2.0 ao longo do tempo.”

Ao abrir o fornecimento de um modelo tão capaz, a 01.AI capacita os programadores de todo o mundo a construir a próxima geração de IA. Com um imenso tratamento de contexto num pacote personalizável, podemos esperar uma torrente de aplicações inovadoras que utilizam o Yi.

O potencial é elevadíssimo para modelos de código aberto como o Yi-6B-200K e o Yi-34B-200K. À medida que a IA permeia nossas vidas, os sistemas executados localmente prometem maior transparência, segurança e personalização em comparação com alternativas fechadas dependentes da nuvem.

Enquanto o Claude e o GPT-4 Turbo ganham as manchetes, esta nova alternativa de código aberto pode em breve construir a próxima fase da IA diretamente nos dispositivos dos utilizadores. Quando parecia que não havia mais formas de atualizar o nosso hardware, talvez seja altura de comprar um dispositivo mais capaz antes que a sua IA local seja ultrapassada por um concorrente mais “consciente do contexto”.