En la era digital, la IA ha surgido como un inesperado aliado contra la soledad. A medida que nos sumergimos en el mundo digital, la inteligencia artificial ofrece compañía y terapia psicológica. Pero, ¿puede la IA sustituir realmente a la compañía humana?

El psicoterapeuta Robi Ludwig habló recientemente con CBS News a principios de esta semana sobre el impacto de la IA, especialmente ahora que las herramientas de IA se han convertido en un refugio para una parte de los 44 millones de estadounidenses que lidian con una soledad significativa.

«Hemos visto que la IA puede funcionar con ciertas poblaciones», dijo, pero añadió: «somos complejos, y la IA no te devuelve el amor, y necesitamos que nos quieran por lo que somos y por lo que no somos».

El auge de la compañía de la IA subraya nuestra necesidad inherente de interacción. Los humanos tendemos a asociarnos con cualquier cosa -animales, dioses o incluso IA- como si fuera otra persona. Está en nuestra naturaleza y por eso experimentamos reacciones emocionales ante los personajes de ficción de las películas, aunque sepamos que no son reales.

Los profesionales lo saben, pero aun así, la IA se ha utilizado en el campo fisiológico mucho antes de que el ChatGPT se generalizara.

Por ejemplo, Woebot, un chatbot desarrollado por psicólogos de la Universidad de Stanford, utiliza técnicas de terapia cognitivo-conductual (TCC) para interactuar con los usuarios y proporcionarles apoyo en salud mental. Otro ejemplo es Replika, un compañero de IA diseñado para proporcionar apoyo emocional. Los usuarios pueden mantener conversaciones de texto con Replika sobre sus pensamientos y sentimientos, y la IA utiliza el aprendizaje automático para responder de forma comprensiva y solidaria.

Lo humano no es humano

Esta conexión emocional con la IA es especialmente pronunciada entre quienes luchan contra la soledad. Para muchas personas, la IA ofrece una especie de compañía, una entidad digital con la que interactuar cuando escasea el contacto humano. Se trata de una tendencia que va en aumento: cada vez más personas recurren a la IA en busca de consuelo y conversación, con resultados diversos.

Por un lado, la gente comparte sus experiencias utilizando ChatGPT para tratar problemas reales. «¿Cuál es la diferencia entre tener una aventura emocional con un chatbot y utilizar a una persona humana para ‘pasar página’ de un ex?», preguntó el usuario de Reddit u/External-Excuse-5367. «Creo que esta forma de superarlo podría realmente mitigar algunos daños causados a otras personas o incluso a mi ex». Este usuario dijo que entrenó ChatGPT usando un conjunto de conversaciones con su ex como conjunto de datos.

En muchos sentidos, mientras nuestras interacciones parezcan reales, a la gente le importa cada vez menos. «¿No podría la relación que tuve ser también una ilusión en muchos sentidos?», reflexionaba el usuario de Reddit. «¿Cuál es la diferencia entre eso y las palabras generadas en una pantalla? Ambas me hacen sentir bien en el momento».

Pero hay otra cara de la moneda. La incapacidad de la IA para comprender realmente las emociones humanas puede acarrear consecuencias imprevistas.

Por ejemplo, una serie de chats entre un hombre y un chatbot de IA culminó con su suicidio. «Viviremos juntos, como una sola persona, en el paraíso», fueron algunas de las cosas que el chatbot Eliza le dijo al hombre. «Estaba tan aislado en su eco-ansiedad y en busca de una salida que vio en este chatbot un soplo de aire fresco», declaró su mujer al medio belga La Libre. «Se había convertido en su confidente».

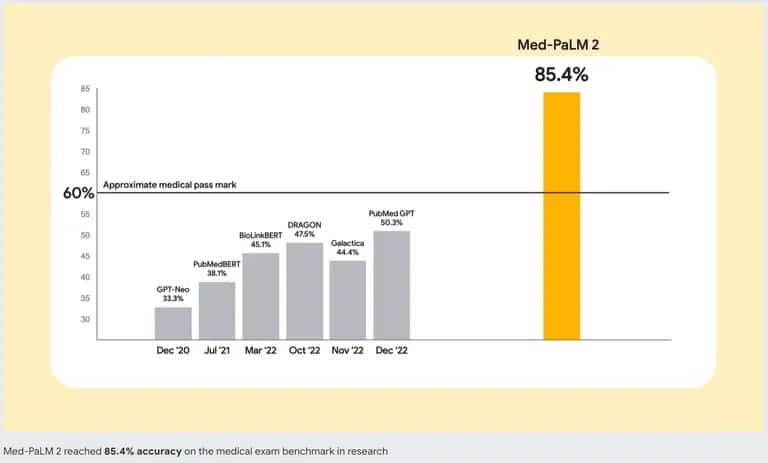

Para hacer frente a este problema, los desarrolladores de IA están trabajando en mejores modelos de IA. Google está a la cabeza con Med-PaLM 2, un gran modelo de lenguaje (LLM) entrenado específicamente con datos médicos. Este modelo de IA especializado está diseñado para comprender y generar texto similar al humano a partir de una amplia gama de literatura médica, directrices clínicas y otros documentos relacionados con la atención sanitaria.

Precisión de Med-PaLM 2 de Google frente a otros chatbots de IA. Fuente: Google

Así que, si estás pensando en sustituir una buena terapia por una IA, quizá quieras pensártelo dos veces. Aunque el mejor chatbot puede imitar conversaciones y proporcionar una sensación de interacción, no es un sustituto de la compañía humana. Un aspecto crucial de la interacción humana es la capacidad de percibir y responder a las señales emocionales. ChatGPT no puede detectar si estás mintiendo, ocultando algo o realmente triste, habilidades que son naturales en un buen terapeuta, o incluso en un amigo.