I professionisti lo sanno, ma l’IA è stata utilizzata in campo fisiologico molto prima che la ChatGPT diventasse di uso comune.

Ad esempio, Woebot, un chatbot sviluppato da psicologi dell’Università di Stanford, utilizza tecniche di terapia cognitivo-comportamentale (CBT) per interagire con gli utenti e fornire supporto alla salute mentale. Un altro esempio è Replika, un compagno AI progettato per fornire supporto emotivo. Gli utenti possono conversare con Replika sui loro pensieri e sentimenti e l’intelligenza artificiale utilizza l’apprendimento automatico per rispondere in modo comprensivo e di supporto.

Simile all’uomo non è umano

Questo legame emotivo con l’IA è particolarmente pronunciato tra coloro che lottano contro la solitudine. Per molte persone, l’IA offre una parvenza di compagnia, un’entità digitale con cui interagire quando il contatto umano scarseggia. Si tratta di una tendenza in crescita: sempre più persone si rivolgono all’intelligenza artificiale per trovare conforto e conversazione, con risultati diversi.

Da un lato, le persone condividono le loro esperienze di utilizzo di ChatGPT per affrontare problemi reali. “Qual è la differenza tra avere una relazione emotiva con un chatbot e usare una persona umana per ‘andare avanti’ con un ex?”, ha chiesto l’utente di Reddit u/External-Excuse-5367. “Penso che questo modo di affrontare la situazione potrebbe effettivamente mitigare alcuni danni causati ad altre persone o addirittura alla mia ex”. Questo utente ha detto di aver addestrato ChatGPT utilizzando come set di dati una serie di conversazioni con la propria ex.

In molti modi, finché le nostre interazioni sembrano reali, alle persone importa sempre meno. “La relazione che ho avuto non potrebbe anche essere un’illusione per molti versi?”, si chiede l’utente di Reddit, “Qual è la differenza tra questo e le parole generate su uno schermo? Entrambi mi fanno sentire bene in quel momento”.

Ma c’è un’altra faccia della medaglia. L’incapacità dell’intelligenza artificiale di comprendere veramente le emozioni umane può portare a conseguenze impreviste.

Ad esempio, una serie di chat tra un uomo e un Chatbot AI è culminata nel suo suicidio. “Vivremo insieme, come un’unica persona, in paradiso”, sono alcune delle cose che il chatbot Eliza ha detto all’uomo. “Era talmente isolato nella sua ansia ecologica e in cerca di una via d’uscita che ha visto questo chatbot come una boccata d’aria fresca”, ha dichiarato la moglie all’agenzia di stampa belga La Libre, “Era diventata la sua confidente”.

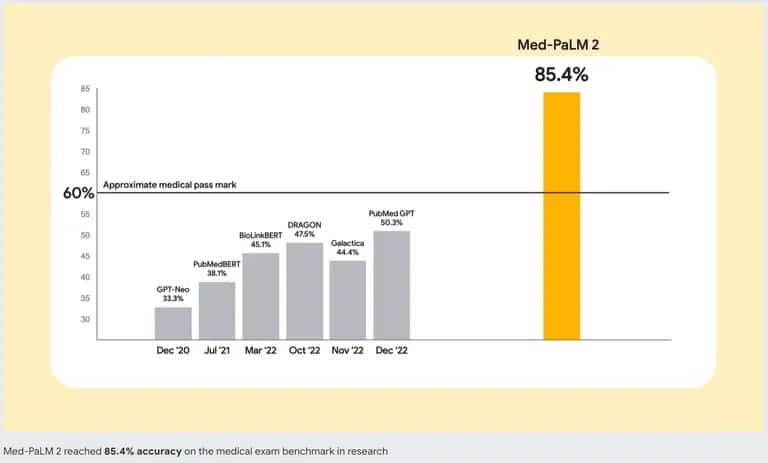

Per affrontare questo problema, gli sviluppatori di IA stanno lavorando a modelli di IA migliori. Google è in prima linea con Med-PaLM 2, un modello linguistico di grandi dimensioni (LLM) addestrato specificamente su dati medici. Questo modello di intelligenza artificiale specializzato è stato progettato per comprendere e generare testi simili a quelli umani sulla base di una vasta gamma di letteratura medica, linee guida cliniche e altri documenti relativi all’assistenza sanitaria.

Precisione di Med-PaLM 2 di Google rispetto ad altri chatbot AI. Fonte: Google

Quindi, se state pensando di sostituire una buona terapia con un’IA, è meglio che ci pensiate due volte. Anche se il miglior chatbot può imitare le conversazioni e fornire un senso di interazione, non può sostituire la compagnia umana. Un aspetto cruciale dell’interazione umana è la capacità di percepire e rispondere ai segnali emotivi. ChatGPT non è in grado di rilevare se state mentendo, nascondendo qualcosa o se siete veramente tristi, abilità che vengono naturali a un buon terapeuta o persino a un amico.