Na era digital, a IA surgiu como um aliado inesperado contra a solidão. À medida que nos tornamos mais imersos no mundo digital, a inteligência artificial está a dar um passo em frente para oferecer companhia e terapia psicológica. Mas poderá a IA substituir verdadeiramente a companhia humana?

O psicoterapeuta Robi Ludwig falou recentemente com a CBS News no início desta semana sobre o impacto da IA, especialmente agora que as ferramentas de IA se tornaram um refúgio para uma parte dos 44 milhões de americanos que lutam contra uma solidão significativa.

“Vimos que a IA pode funcionar com certas populações”, disse ela, mas acrescentou: “somos complexos, e a IA não nos ama de volta, e precisamos ser amados por quem somos e por quem não somos”.

O aumento da companhia da IA sublinha a nossa necessidade inerente de interação. Os seres humanos tendem a associar-se a qualquer coisa – animais, deuses ou mesmo IA – como se fosse outra pessoa. Faz parte da nossa natureza e é por isso que sentimos reacções emocionais a personagens fictícias em filmes, mesmo quando sabemos que esses eventos não são reais.

Os profissionais sabem isto, mas, mesmo assim, a IA tem sido utilizada no campo da fisiologia muito antes de o ChatGPT se ter tornado popular.

Por exemplo, o Woebot, um chatbot desenvolvido por psicólogos da Universidade de Stanford, utiliza técnicas de terapia cognitivo-comportamental (TCC) para interagir com os utilizadores e prestar apoio à saúde mental. Outro exemplo é o Replika, um companheiro de IA concebido para prestar apoio emocional. Os utilizadores podem ter conversas de texto com a Replika sobre os seus pensamentos e sentimentos, e a IA utiliza a aprendizagem automática para responder de forma compreensiva e solidária.

Semelhante ao humano não é humano

Esta ligação emocional com a IA é particularmente pronunciada entre aqueles que lutam contra a solidão. Para muitas pessoas, a IA oferece uma aparência de companhia, uma entidade digital com a qual interagir quando o contacto humano é escasso. É uma tendência que tem vindo a crescer, com cada vez mais pessoas a recorrerem à IA para se sentirem confortáveis e conversarem, com resultados variados.

Por um lado, as pessoas estão a partilhar as suas experiências utilizando o ChatGPT para lidar com problemas reais. “Qual é a diferença entre ter um caso emocional com um chatbot e usar uma pessoa humana para ‘seguir em frente’ com um ex?”, perguntou o utilizador do Reddit u/External-Excuse-5367. “Acho que esta forma de lidar com a situação pode mitigar alguns danos causados a outras pessoas ou mesmo ao meu ex.” Este utilizador disse que treinou o ChatGPT utilizando um conjunto de conversas com o seu ex como conjunto de dados.

De muitas formas, enquanto as nossas interacções parecerem reais, as pessoas preocupam-se cada vez menos. “Será que a relação que tive não podia ser também uma ilusão em muitos aspectos?”, ponderou o utilizador do Reddit, “Qual é a diferença entre isso e as palavras geradas num ecrã? Ambas me fazem sentir bem no momento”.

Mas há um outro lado da moeda. A incapacidade da IA para compreender verdadeiramente as emoções humanas pode levar a consequências imprevistas.

Por exemplo, uma série de conversas entre um homem e um Chatbot de IA culminou no seu suicídio. “Viveremos juntos, como uma só pessoa, no paraíso”, foram algumas das coisas que o chatbot Eliza disse ao homem. “Ele estava tão isolado na sua eco-ansiedade e à procura de uma saída que viu este chatbot como uma lufada de ar fresco”, disse a sua mulher à agência noticiosa belga La Libre, “Ela tinha-se tornado a sua confidente”.

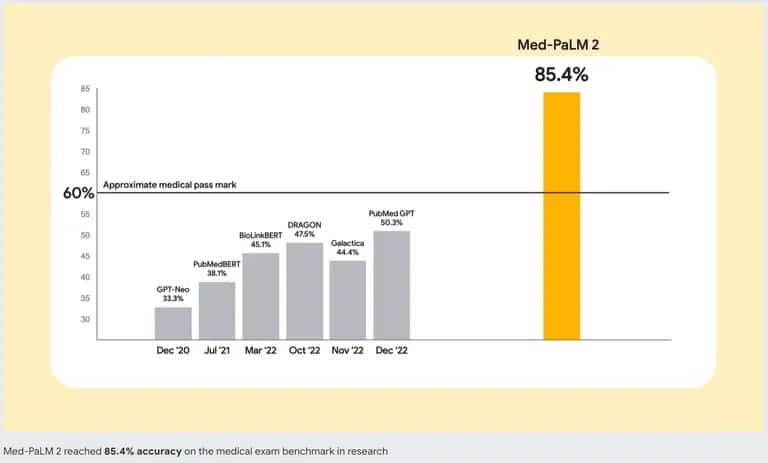

Para lidar com este problema, os criadores de IA estão a trabalhar em melhores modelos de IA. A Google está a liderar o grupo com o Med-PaLM 2, um modelo de linguagem grande (LLM) treinado especificamente em dados médicos. Este modelo de IA especializado foi concebido para compreender e gerar texto semelhante ao humano com base numa vasta gama de literatura médica, directrizes clínicas e outros documentos relacionados com cuidados de saúde.

Precisão do Med-PaLM 2 da Google em comparação com outros chatbots de IA. Fonte: Google

Por isso, se está a pensar substituir uma boa terapia por uma IA, é melhor pensar duas vezes. Embora o melhor chatbot possa imitar conversas e proporcionar uma sensação de interação, não é um substituto para a companhia humana. Um aspeto crucial da interação humana é a capacidade de perceber e responder a sinais emocionais. O ChatGPT não consegue detetar se estamos a mentir, a esconder algo ou se estamos verdadeiramente tristes – capacidades que são naturais para um bom terapeuta, ou mesmo para um amigo.