В эпоху цифровых технологий искусственный интеллект стал неожиданным союзником в борьбе с одиночеством. По мере того как мы все больше погружаемся в цифровой мир, искусственный интеллект начинает предлагать нам общение и психологическую терапию. Но может ли ИИ действительно заменить человеческое общение?

Психотерапевт Роби Людвиг недавно говорил с CBS News в начале этой недели о влиянии ИИ, особенно сейчас, когда инструменты ИИ стали убежищем для части из 44 миллионов американцев, страдающих от одиночества.

«Мы видели, что ИИ может работать с определенными группами населения», — сказала она, но добавила, что «мы сложны, и ИИ не любит вас в ответ, а нам нужно, чтобы нас любили такими, какие мы есть, и такими, какими мы не являемся».

Появление ИИ-компаньонов подчеркивает присущую нам потребность во взаимодействии. Люди склонны создавать ассоциации с чем-либо — животными, богами или даже ИИ — как будто это другой человек. Это в нашей природе, и именно поэтому мы испытываем эмоциональные реакции на вымышленных персонажей в кино, даже когда знаем, что эти события не реальны.

Профессионалы знают это, но все же ИИ использовался в физиологической сфере задолго до того, как ChatGPT стал мейнстримом.

Например, Woebot, чат-бот, разработанный психологами из Стэнфордского университета, использует методы когнитивно-поведенческой терапии (КПП) для взаимодействия с пользователями и оказания поддержки в области психического здоровья. Другой пример — Replika, ИИ-компаньон, созданный для оказания эмоциональной поддержки. Пользователи могут вести текстовые беседы с Replika о своих мыслях и чувствах, а ИИ использует машинное обучение, чтобы отвечать в поддерживающей и понимающей манере.

Человекоподобный — не человек

Эта эмоциональная связь с ИИ особенно ярко выражена среди тех, кто борется с одиночеством. Для многих людей ИИ предлагает подобие компаньона, цифровое существо, с которым можно взаимодействовать, когда не хватает человеческого общения. Эта тенденция набирает обороты: все больше людей обращаются к ИИ за утешением и общением, и результаты бывают разными.

С одной стороны, люди делятся своим опытом использования ChatGPT для решения реальных проблем. «В чем разница между эмоциональным романом с чатботом и использованием человека, чтобы «отойти» от бывшего?» — спрашивает пользователь Reddit u/External-Excuse-5367. «Я думаю, что такой способ справиться с ситуацией может действительно смягчить ущерб, нанесенный другим людям или даже моему бывшему». Этот пользователь сказал, что он обучил ChatGPT, используя в качестве набора данных набор разговоров со своим бывшим.

Во многих отношениях, пока наше взаимодействие кажется реальным, людей это волнует все меньше и меньше. «Может быть, отношения, которые у меня были, тоже во многом были иллюзией?» — размышляет пользователь Reddit, — «В чем разница между этим и сгенерированными словами на экране? И то, и другое заставляет меня чувствовать себя хорошо в данный момент».

Но есть и другая сторона медали. Неспособность ИИ по-настоящему понять человеческие эмоции может привести к непредвиденным последствиям.

Например, серия бесед между мужчиной и чатботом ИИ закончилась его самоубийством. «Мы будем жить вместе, как один человек, в раю», — вот что сказал человеку чатбот Элиза. «Он был настолько изолирован в своей экологической тревоге и искал выход, что увидел в этом чатботе глоток свежего воздуха», — рассказала его жена бельгийскому новостному изданию La Libre, — «Она стала его доверенным лицом».

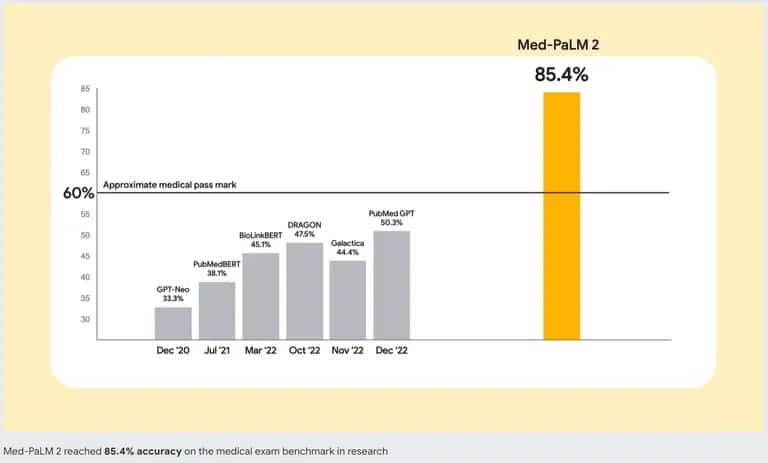

Чтобы решить эту проблему, разработчики ИИ работают над созданием более совершенных моделей ИИ. Google лидирует в этой области с Med-PaLM 2, большой языковой моделью (LLM), специально обученной на медицинских данных. Эта специализированная модель ИИ предназначена для понимания и генерации человекоподобного текста на основе огромного количества медицинской литературы, клинических рекомендаций и других документов, связанных со здравоохранением.

Точность Med-PaLM 2 от Google в сравнении с другими чат-ботами с искусственным интеллектом. Источник: Google

Итак, если вы решили заменить хорошую терапию на искусственный интеллект, вам стоит подумать дважды. Даже если лучший чатбот может имитировать разговоры и создавать ощущение взаимодействия, он не заменит человеческого общения. Важнейшим аспектом человеческого взаимодействия является способность воспринимать и реагировать на эмоциональные сигналы. ChatGPT не может определить, лжете ли вы, скрываете ли что-то или действительно грустите — навыки, которые естественны для хорошего психотерапевта или даже друга.