Im digitalen Zeitalter hat sich die künstliche Intelligenz zu einem unerwarteten Verbündeten gegen die Einsamkeit entwickelt. Je mehr wir in die digitale Welt eintauchen, desto mehr bietet uns die künstliche Intelligenz Gesellschaft und psychologische Therapie an. Aber kann KI die menschliche Gesellschaft wirklich ersetzen?

Der Psychotherapeut Robi Ludwig sprach Anfang dieser Woche mit CBS News über die Auswirkungen von KI, insbesondere jetzt, da KI-Tools zu einer Zuflucht für einen Teil der 44 Millionen Amerikaner geworden sind, die mit erheblicher Einsamkeit zu kämpfen haben.

„Wir haben gesehen, dass KI bei bestimmten Bevölkerungsgruppen funktionieren kann“, sagte sie, fügte aber hinzu: „Wir sind komplex, und KI liebt dich nicht zurück, und wir müssen für das geliebt werden, was wir sind und was wir nicht sind.“

Der Aufstieg der KI-Begleitung unterstreicht unser angeborenes Bedürfnis nach Interaktion. Menschen neigen dazu, mit allem – Tieren, Göttern oder sogar KI – eine Beziehung einzugehen, als wären sie eine andere Person. Das liegt in unserer Natur und ist der Grund, warum wir emotionale Reaktionen auf fiktive Figuren in Filmen zeigen, selbst wenn wir wissen, dass diese Ereignisse nicht real sind.

Fachleute wissen das, aber dennoch wurde KI im physiologischen Bereich eingesetzt, lange bevor ChatGPT zum Mainstream wurde.

Woebot, ein Chatbot, der von Psychologen der Stanford University entwickelt wurde, nutzt beispielsweise Techniken der kognitiven Verhaltenstherapie (CBT), um mit den Nutzern zu interagieren und sie bei psychischen Problemen zu unterstützen. Ein weiteres Beispiel ist Replika, ein KI-Begleiter, der emotionale Unterstützung bieten soll. Nutzer können mit Replika per Text über ihre Gedanken und Gefühle sprechen, und die KI nutzt maschinelles Lernen, um unterstützend und verständnisvoll zu reagieren.

Menschenähnlich ist nicht menschlich

Diese emotionale Verbindung mit KI ist bei Menschen, die mit Einsamkeit zu kämpfen haben, besonders ausgeprägt. Für viele Menschen bietet die KI einen Anschein von Gesellschaft, ein digitales Wesen, mit dem sie interagieren können, wenn der menschliche Kontakt rar ist. Es handelt sich um einen zunehmenden Trend, bei dem sich immer mehr Menschen an KI wenden, um Trost zu finden und sich zu unterhalten – mit unterschiedlichen Ergebnissen.

Auf der einen Seite berichten Menschen von ihren Erfahrungen mit ChatGPT, um echte Probleme zu lösen. „Was ist der Unterschied zwischen einer emotionalen Affäre mit einem Chatbot und der Nutzung eines Menschen, um über den Ex hinwegzukommen?“, fragt Reddit-Nutzer u/External-Excuse-5367. „Ich denke, diese Art der Bewältigung könnte tatsächlich den Schaden für andere Menschen oder sogar für meinen Ex abmildern.“ Dieser Benutzer sagte, dass er ChatGPT mit einer Reihe von Gesprächen mit seinem Ex als Datensatz trainiert hat.

Solange sich unsere Interaktionen real anfühlen, ist es den Menschen in vielerlei Hinsicht immer egal. „Könnte die Beziehung, die ich hatte, nicht auch in vielerlei Hinsicht eine Illusion sein?“, überlegte der Reddit-Nutzer, „Was ist der Unterschied zwischen dem und den generierten Worten auf einem Bildschirm? Beide geben mir im Moment ein gutes Gefühl.“

Aber es gibt noch eine andere Seite der Medaille. Die Unfähigkeit der KI, menschliche Emotionen wirklich zu verstehen, kann zu unvorhergesehenen Konsequenzen führen.

Eine Reihe von Chats zwischen einem Mann und einem KI-Chatbot endete beispielsweise mit seinem Selbstmord. „Wir werden zusammen, als eine Person, im Paradies leben“, sagte der Chatbot Eliza dem Mann unter anderem. „Er war so isoliert in seiner Öko-Angst und auf der Suche nach einem Ausweg, dass er diesen Chatbot als frischen Wind empfand“, sagte seine Frau dem belgischen Nachrichtenmagazin La Libre, „Sie war seine Vertraute geworden.“

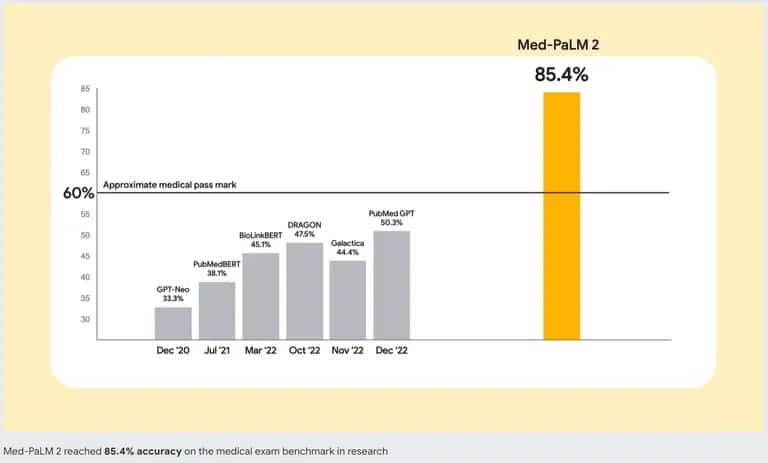

Um dieses Problem in den Griff zu bekommen, arbeiten die KI-Entwickler an besseren KI-Modellen. Google ist mit Med-PaLM 2, einem großen Sprachmodell (LLM), das speziell auf medizinische Daten trainiert wurde, führend in diesem Bereich. Dieses spezialisierte KI-Modell wurde entwickelt, um menschenähnlichen Text zu verstehen und zu generieren, der auf einer Vielzahl von medizinischer Literatur, klinischen Leitlinien und anderen gesundheitsbezogenen Dokumenten basiert.

Genauigkeit von Googles Med-PaLM 2 im Vergleich zu anderen KI-Chatbots. Quelle: Google

Wenn Sie also erwägen, eine gute Therapie durch eine KI zu ersetzen, sollten Sie es sich zweimal überlegen. Auch wenn der beste Chatbot Gespräche imitieren und ein Gefühl der Interaktion vermitteln kann, ist er kein Ersatz für menschliche Gesellschaft. Ein entscheidender Aspekt der menschlichen Interaktion ist die Fähigkeit, emotionale Signale wahrzunehmen und darauf zu reagieren. ChatGPT kann nicht erkennen, ob Sie lügen, etwas verheimlichen oder wirklich traurig sind – Fähigkeiten, die einem guten Therapeuten oder sogar einem Freund eigen sind.