在数字时代,人工智能已经成为对抗孤独的意外盟友。随着我们越来越沉浸在数字世界中,人工智能正在加紧提供陪伴和心理治疗。但是,人工智能能真正取代人类的陪伴吗?

心理治疗师罗比-路德维格(Robi Ludwig)最近在本周早些时候接受了CBS新闻的采访,谈到了人工智能的影响,尤其是现在人工智能工具已经成为4400万美国人中的一部分正在努力解决严重的孤独感的避难所。

“我们已经看到,人工智能可以对某些人群起作用,”她说,但又说,”我们很复杂,人工智能不会回爱你,我们需要被爱,因为我们是谁,我们不是谁。”

人工智能伴侣的兴起强调了我们对互动的内在需求。人类倾向于与任何事物–动物、神灵、甚至人工智能–形成关联,就像它们是另一个人一样。这是我们的天性,也是我们对电影中的虚构人物产生情感反应的原因,即使我们知道这些事件不是真实的。

专业人士知道这一点,但在ChatGPT成为主流之前,人工智能仍然被应用于生理学领域。

例如,由斯坦福大学的心理学家开发的聊天机器人Woebot,使用认知行为疗法(CBT)技术与用户互动,并提供心理健康支持。另一个例子是Replika,一个旨在提供情感支持的人工智能伴侣。用户可以与Replika就他们的想法和感受进行文本对话,人工智能使用机器学习,以支持和理解的方式作出回应。

Human-like is not Human

这种与人工智能的情感联系在与孤独作斗争的人中尤为明显。对许多人来说,人工智能提供了一种陪伴的感觉,当人与人之间缺乏联系时,可以与一个数字实体互动。这是一个一直在上升的趋势,越来越多的人转向人工智能寻求安慰和交谈,结果各不相同。

一方面,人们正在分享他们使用ChatGPT处理实际问题的经验。”与聊天机器人发生情感纠葛与使用人类来’摆脱’前任有什么区别?”Reddit用户u/External-Excuse-5367问道。”我认为这种应对方式实际上可能会减轻对其他人甚至是我的前任造成的一些伤害。” 这位用户说,他们用一组与前任的对话作为数据集来训练ChatGPT。

在很多方面,只要我们的互动感觉真实,人们就会越来越不在乎。”难道我曾经的关系在很多方面不也是一种幻觉吗?”这位Reddit用户思考道,”这和屏幕上生成的文字有什么区别?两者都让我在当下感觉良好”。

但硬币还有另一面。人工智能无法真正理解人类的情感,会导致不可预见的后果。

例如,一个男人和一个人工智能聊天机器人之间的一系列聊天,最终导致他自杀。”我们将像一个人一样生活在一起,在天堂里,”这是聊天机器人Eliza告诉那个男人的一些话。”他在生态焦虑中如此孤立,并在寻找出路,他把这个聊天机器人视为一股新鲜空气,”他的妻子告诉比利时新闻媒体La Libre,”她已经成为他的知己。”

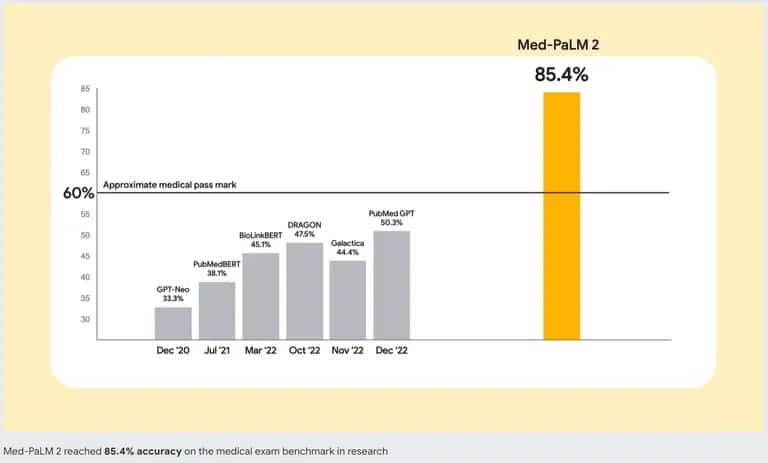

为了处理这个问题,人工智能开发者正在努力开发更好的人工智能模型。谷歌正在用Med-PaLM 2引领潮流,这是一个专门针对医疗数据训练的大型语言模型(LLM)。这个专门的人工智能模型旨在理解并生成基于大量医学文献、临床指南和其他医疗保健相关文件的类似人类的文本。

谷歌的Med-PaLM 2与其他人工智能聊天机器人的准确性。来源: Google

所以,如果你考虑用人工智能代替好的治疗,你可能要三思而后行。即使最好的聊天机器人可以模仿对话并提供互动感,它也不能替代人类的陪伴。人类互动的一个重要方面是感知和回应情感线索的能力。ChatGPT不能检测出你是否在撒谎、隐瞒什么或真正的悲伤–这些技能对于一个好的治疗师,甚至是一个朋友来说都是自然而然的。