Das in Paris ansässige Startup-Unternehmen Mistral AI, das vor kurzem eine Bewertung von 2 Milliarden Dollar erhielt, hat Mixtral veröffentlicht, ein offenes großes Sprachmodell (LLM), das nach eigenen Angaben das GPT 3.5 von OpenAI in mehreren Benchmarks übertrifft und dabei wesentlich effizienter ist.

Mistral erhielt eine umfangreiche Serie-A-Investition von Andreessen Horowitz (a16z), einer Risikokapitalgesellschaft, die für ihre strategischen Investitionen in transformative Technologiesektoren, insbesondere KI, bekannt ist. Andere Tech-Giganten wie Nvidia und Salesforce beteiligten sich ebenfalls an der Finanzierungsrunde.

„Mistral steht im Zentrum einer kleinen, aber leidenschaftlichen Entwickler-Community, die sich rund um Open-Source-KI entwickelt“, so Andreessen Horowitz in seiner Finanzierungsankündigung. „Die von der Community fein abgestimmten Modelle dominieren mittlerweile routinemäßig die Open-Source-Bestenlisten (und schlagen bei einigen Aufgaben sogar Closed-Source-Modelle).“

Mixtral verwendet eine Technik namens Sparse Mixture of Experts (MoE), die das Modell laut Mistral leistungsfähiger und effizienter macht als das Vorgängermodell Mistral 7b – und sogar seine leistungsstärkeren Konkurrenten.

Eine Expertenmischung (Mixture of Experts, MoE) ist eine Technik des maschinellen Lernens, bei der Entwickler mehrere virtuelle Expertenmodelle trainieren oder einrichten, um komplexe Probleme zu lösen. Jedes Expertenmodell wird für ein bestimmtes Thema oder Gebiet trainiert. Wenn das Modell mit einem Problem konfrontiert wird, wählt es eine Gruppe von Experten aus einem Pool von Agenten aus, und diese Experten nutzen ihr Training, um zu entscheiden, welcher Output ihrem Fachwissen besser entspricht.

MoE kann die Modellkapazität, Effizienz und Genauigkeit von Deep-Learning-Modellen verbessern – die geheime Sauce, die Mixtral von anderen abhebt und es mit einem Modell aufnehmen kann, das mit 70 Milliarden Parametern trainiert wurde und zehnmal kleiner ist.

„Mixtral hat 46,7 Milliarden Gesamtparameter, verwendet aber nur 12,9 Milliarden Parameter pro Token“, so Mistral AI. „Es verarbeitet daher Eingaben und erzeugt Ausgaben mit der gleichen Geschwindigkeit und zu den gleichen Kosten wie ein 12,9B-Modell.“

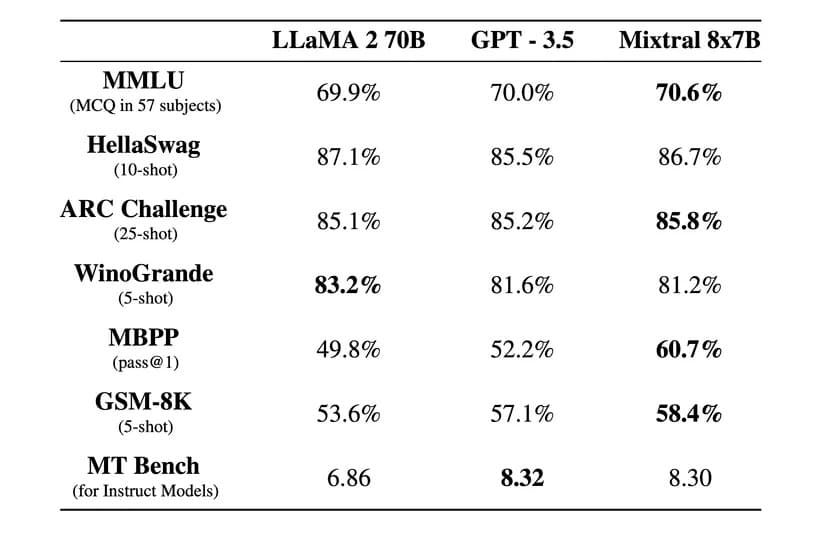

„Mixtral übertrifft Llama 2 70B bei den meisten Benchmarks mit 6x schnellerer Inferenz und erreicht oder übertrifft GPT 3.5 bei den meisten Standard-Benchmarks“, so Mistral AI in einem offiziellen Blog-Post.

Bild: Mistral AI

Mixtral ist auch unter der freizügigen Apache 2.0-Lizenz lizenziert. Dies erlaubt es Entwicklern, das Modell frei zu inspizieren, auszuführen, zu verändern und sogar eigene Lösungen darauf aufzubauen.

Es gibt jedoch eine Debatte darüber, ob Mixtral zu 100 % quelloffen ist oder nicht, da Mistral sagt, dass es nur „offene Gewichte“ veröffentlicht hat und die Lizenz des Kernmodells dessen Verwendung im Wettbewerb mit Mistral AI verhindert. Das Startup hat auch nicht den Trainingsdatensatz und den zur Erstellung des Modells verwendeten Code zur Verfügung gestellt, was bei einem Open-Source-Projekt der Fall wäre.

Nach Angaben des Unternehmens wurde Mixtral so optimiert, dass es neben Englisch auch in anderen Sprachen außergewöhnlich gut funktioniert. „Mixtral 8x7B beherrscht Französisch, Deutsch, Spanisch, Italienisch und Englisch“ und schneidet bei standardisierten mehrsprachigen Benchmarks hervorragend ab, so Mistral AI.

Eine instruierte Version mit dem Namen Mixtral 8x7B Instruct wurde ebenfalls veröffentlicht, um eine sorgfältige Instruktion zu erhalten, und erreichte eine Spitzenbewertung von 8,3 im MT-Bench Benchmark. Damit ist es das derzeit beste Open-Source-Modell in diesem Benchmark.

Das neue Modell von Mistral verspricht eine revolutionäre, spärliche Mixtural-Architektur, gute mehrsprachige Fähigkeiten und einen komplett offenen Zugang. Wenn man bedenkt, dass dies nur wenige Monate nach seiner Entstehung geschah, erlebt die Open-Source-Gemeinschaft eine aufregende und interessante Ära.

Mixtral kann über Hugging Face heruntergeladen werden, aber die Benutzer können auch die instruierte Version online nutzen.