La startup Mistral AI, con sede en París y valorada recientemente en 2.000 millones de dólares, ha lanzado Mixtral, un modelo abierto de gran lenguaje (LLM) que, según afirma, supera al GPT 3.5 de OpenAI en varias pruebas comparativas y es mucho más eficiente.

Mistral recibió una importante inversión de serie A de Andreessen Horowitz (a16z), una empresa de capital riesgo famosa por sus inversiones estratégicas en sectores tecnológicos transformadores, especialmente la IA. Otros gigantes tecnológicos como Nvidia y Salesforce también participaron en la ronda de financiación.

«Mistral está en el centro de una pequeña pero apasionada comunidad de desarrolladores que crece en torno a la IA de código abierto», dijo Andreessen Horowitz en su anuncio de financiación. «Los modelos afinados por la comunidad ahora dominan rutinariamente las tablas de clasificación de código abierto (e incluso superan a los modelos de código cerrado en algunas tareas)».

Mixtral utiliza una técnica denominada mezcla dispersa de expertos (MoE), que, según Mistral, hace que el modelo sea más potente y eficiente que su predecesor, Mistral 7b, e incluso que sus competidores más potentes.

La mezcla de expertos (MoE) es una técnica de aprendizaje automático en la que los desarrolladores entrenan o configuran múltiples modelos expertos virtuales para resolver problemas complejos. Cada modelo experto se entrena en un tema o campo específico. Cuando se le plantea un problema, el modelo elige un grupo de expertos de entre un conjunto de agentes, y esos expertos utilizan su formación para decidir qué resultado se adapta mejor a su experiencia.

MoE puede mejorar la capacidad, la eficiencia y la precisión de los modelos de aprendizaje profundo, la salsa secreta que diferencia a Mixtral del resto, capaz de competir contra un modelo entrenado con 70.000 millones de parámetros utilizando un modelo 10 veces más pequeño.

«Mixtral tiene 46,7B parámetros totales, pero solo utiliza 12,9B parámetros por token», dijo Mistral AI. «Por lo tanto, procesa la entrada y genera la salida a la misma velocidad y por el mismo coste que un modelo de 12,9B».

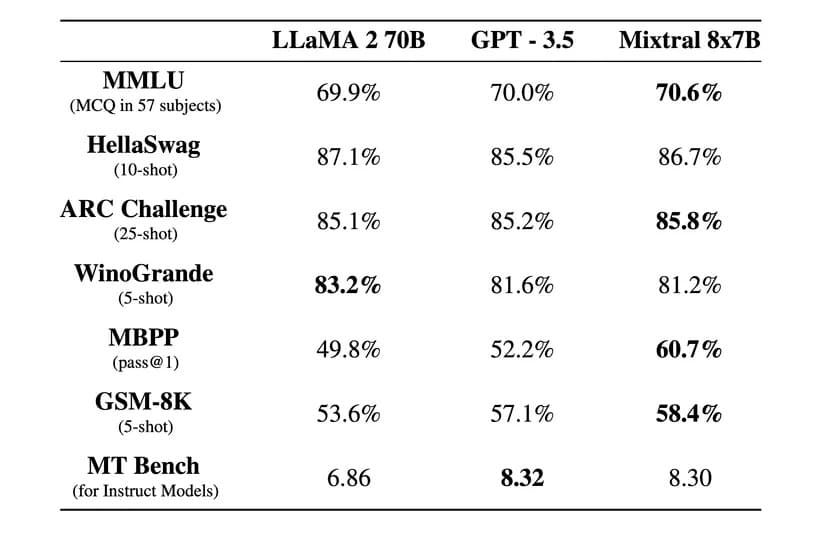

«Mixtral supera a Llama 2 70B en la mayoría de los puntos de referencia con una inferencia 6 veces más rápida e iguala o supera a GPT 3.5 en la mayoría de los puntos de referencia estándar», dijo Mistral AI en una entrada del blog oficial.

Imagen: Mistral AI

Mixtral también tiene licencia Apache 2.0 permisiva. Esto permite a los desarrolladores inspeccionar, ejecutar, modificar e incluso construir libremente soluciones personalizadas sobre el modelo.

Sin embargo, existe un debate sobre si Mixtral es 100% de código abierto o no, ya que Mistral afirma que sólo ha publicado «pesos abiertos», y la licencia del modelo central impide su uso para competir contra Mistral AI. La startup tampoco ha facilitado el conjunto de datos de entrenamiento ni el código utilizado para crear el modelo, como sería el caso en un proyecto de código abierto.

La empresa afirma que Mixtral ha sido perfeccionado para funcionar excepcionalmente bien en otros idiomas además del inglés. «Mixtral 8x7B domina el francés, el alemán, el español, el italiano y el inglés», con una alta puntuación en las pruebas multilingües estandarizadas, afirma Mistral AI.

También se ha lanzado una versión con instrucciones, Mixtral 8x7B Instruct, que ha obtenido una puntuación máxima de 8,3 en la prueba MT-Bench. Esto lo convierte en el mejor modelo de código abierto de la prueba.

El nuevo modelo de Mistral promete una revolucionaria arquitectura dispersa de mezcla de expertos, buenas capacidades multilingües y un acceso completamente abierto. Y teniendo en cuenta que esto ha sucedido sólo unos meses después de su creación, la comunidad de código abierto está viviendo una época emocionante e interesante.

Mixtral se puede descargar a través de Hugging Face, pero los usuarios también pueden utilizar la versión de instrucciones en línea.