Pařížský startup Mistral AI, který si nedávno připsal 2 miliardy dolarů, vydal Mixtral, otevřený velký jazykový model (LLM), který podle něj v několika srovnávacích testech překonává GPT 3.5 od OpenAI a zároveň je mnohem efektivnější.

Společnost Mistral získala významnou investici řady A od společnosti Andreessen Horowitz (a16z), která je známá svými strategickými investicemi do transformačních technologických odvětví, zejména do umělé inteligence. Na tomto kole financování se podíleli i další technologičtí giganti, jako je Nvidia a Salesforce.

„Mistral je středem malé, ale vášnivé vývojářské komunity, která se rozrůstá kolem open source AI,“ uvedla společnost Andreessen Horowitz v oznámení o financování. „Modely vyladěné komunitou nyní běžně dominují žebříčkům open source (a v některých úlohách dokonce porážejí modely closed source).“

Mixtral používá techniku zvanou řídká směs expertů (MoE), díky níž je podle společnosti Mistral model výkonnější a efektivnější než jeho předchůdce Mistral 7b – a dokonce i jeho výkonnější konkurenti.

Směs expertů (MoE) je technika strojového učení, při níž vývojáři trénují nebo nastavují více virtuálních expertních modelů k řešení složitých problémů. Každý expertní model je vyškolen na určité téma nebo oblast. Když je model vyzván k řešení problému, vybere ze skupiny agentů skupinu expertů a tito experti na základě svého tréninku rozhodnou, který výstup lépe odpovídá jejich odbornosti.

MoE dokáže zlepšit kapacitu, efektivitu a přesnost modelu pro modely hlubokého učení – tajná omáčka, která odlišuje Mixtral od ostatních a dokáže konkurovat modelu natrénovanému na 70 miliard parametrů pomocí desetkrát menšího modelu.

„Mixtral má 46,7 miliardy celkových parametrů, ale používá pouze 12,9 miliardy parametrů na token,“ uvedla společnost Mistral AI. „Zpracovává tedy vstupy a generuje výstupy stejnou rychlostí a za stejné náklady jako 12,9B model.“

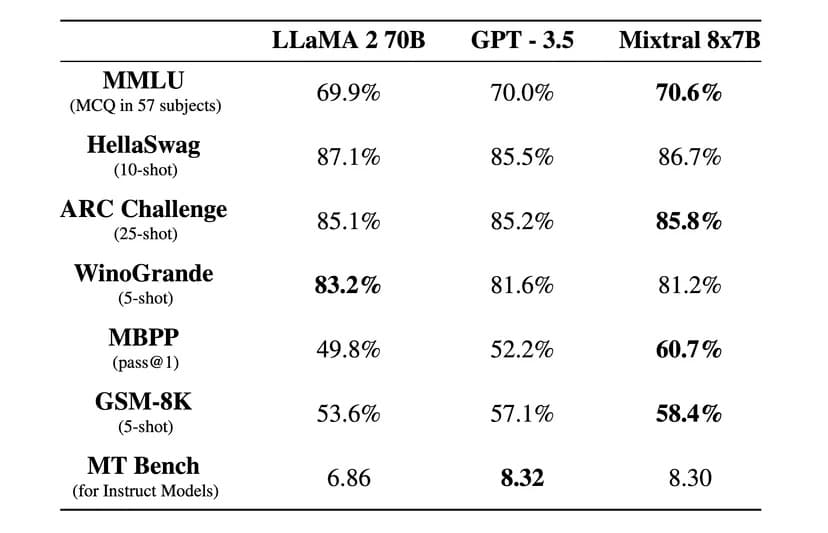

„Mixtral překonává Llama 2 70B na většině benchmarků s 6x rychlejší inferencí a vyrovná se nebo překoná GPT 3.5 na většině standardních benchmarků,“ uvedla Mistral AI v oficiálním příspěvku na blogu.

Obrázek: Mistral AI

Mixtral je rovněž licencován pod permisivní licencí Apache 2.0. To umožňuje vývojářům volně kontrolovat, spouštět, upravovat a dokonce vytvářet vlastní řešení nad tímto modelem.

O tom, zda je Mixtral stoprocentně open source, se však vedou debaty, protože společnost Mistral tvrdí, že uvolnila pouze „otevřené váhy“, a licence jádra modelu brání jeho použití ke konkurenčnímu boji proti Mistral AI. Startup také neposkytl trénovací datovou sadu a kód použitý k vytvoření modelu, což by bylo v případě open-source projektu obvyklé.

Společnost tvrdí, že model Mixtral byl vyladěn tak, aby kromě angličtiny výjimečně dobře fungoval i v cizích jazycích. „Mixtral 8x7B zvládá francouzštinu, němčinu, španělštinu, italštinu a angličtinu“ a dosahuje vysokých výsledků ve standardizovaných vícejazyčných srovnávacích testech, uvedla společnost Mistral AI.

Pro pečlivé sledování instrukcí byla vydána také verze s instrukcemi nazvaná Mixtral 8x7B Instruct, která v benchmarku MT-Bench dosáhla nejvyššího skóre 8,3. Díky tomu je aktuálně nejlepším open source modelem v tomto benchmarku.

Nový model Mistral slibuje revoluční architekturu řídké směsi expertů, dobré vícejazyčné schopnosti a úplný otevřený přístup, A vzhledem k tomu, že se tak stalo jen několik měsíců po jeho vytvoření, prochází open-source komunita vzrušující a zajímavou érou.

Mixtral je k dispozici ke stažení prostřednictvím služby Hugging Face, ale uživatelé mohou také používat verzi s návodem online.