Mixtral 是一个开放的大型语言模型 (LLM),该模型在多项基准测试中均优于 OpenAI 的 GPT 3.5,同时效率更高。

Mistral 吸引了安德森-霍洛维茨(Andreessen Horowitz,简称 a16z)的巨额 A 轮投资,这家风险投资公司因其在变革性技术领域(尤其是人工智能领域)的战略投资而闻名。Nvidia 和 Salesforce 等其他科技巨头也参与了本轮融资。

“Andreessen Horowitz 在其融资公告中说:”Mistral 是围绕开源人工智能成长起来的一个规模虽小但充满激情的开发者社区的中心。”社区微调模型现在经常在开源排行榜上独占鳌头(甚至在某些任务上击败闭源模型)”。

Mixtral 采用了一种称为专家稀疏混合(MoE)的技术,Mistral 称,这种技术使模型比其前身 Mistral 7b 甚至比其更强大的竞争对手更强大、更高效。

专家混合(MoE)是一种机器学习技术,开发人员通过训练或建立多个虚拟专家模型来解决复杂问题。每个专家模型都经过特定主题或领域的训练。当遇到问题时,模型会从代理池中挑选一组专家,而这些专家会利用他们所受的训练来决定哪种输出更适合他们的专长。

MoE可以提高深度学习模型的容量、效率和准确性–这也是Mixtral与众不同的秘诀所在,它可以与使用小10倍的模型、经过700亿个参数训练的模型相抗衡。

“Mixtral拥有467亿个总参数,但每个令牌只使用129亿个参数,”Mistral AI说。”因此,它处理输入和生成输出的速度和成本与 129 亿个模型相同。”

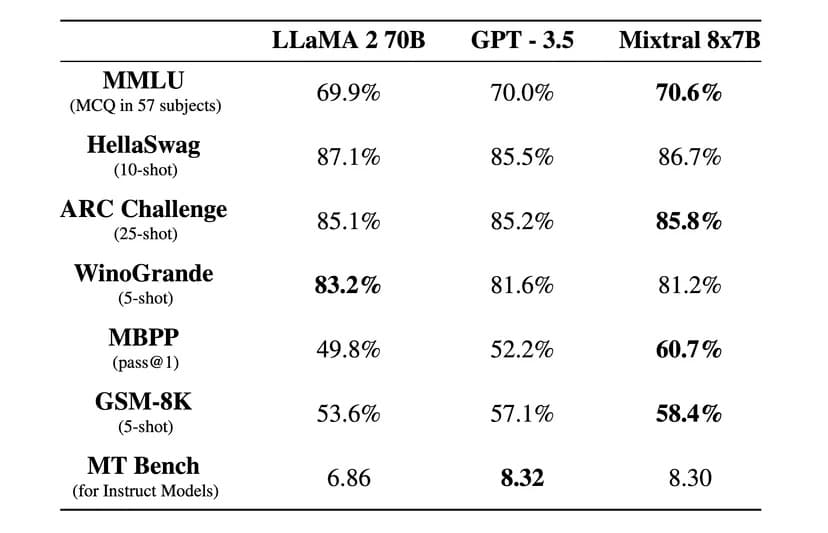

“在大多数基准测试中,Mixtral 的推理速度比 Llama 2 70B 快 6 倍,在大多数标准基准测试中,Mixtral 的表现与 GPT 3.5 相当或更胜一筹,”Mistral AI 在一篇官方博文中说。

Image: Mistral AI

Mixtral还采用了阿帕奇2.0许可协议(permissive Apache 2.0 license)。这允许开发人员自由检查、运行、修改,甚至在模型之上构建自定义解决方案。

不过,关于 Mixtral 是否 100% 开源还存在争议,因为 Mistral 称它只发布了 “开放权重”,而核心模型的许可证禁止使用它与 Mistral AI 竞争。这家初创公司也没有提供用于创建模型的训练数据集和代码,而这在开源项目中是必须的。

该公司表示,Mixtral 经过微调后,在英语之外的外语中也能发挥出色的作用。”Mixtral 8x7B 精通法语、德语、西班牙语、意大利语和英语。

此外,还发布了一个名为 Mixtral 8x7B Instruct 的教学版本,供用户认真学习,该版本在 MT-Bench 基准测试中获得了 8.3 的最高分。这使其成为该基准测试中目前最好的开源模型。

Mistral 的新模型承诺采用革命性的稀疏专家混合架构、良好的多语言能力和完全开放的访问权限。

Mixtral可通过Hugging Face下载,但用户也可在线使用指导版本。