Paryski startup Mistral AI, który niedawno uzyskał wycenę w wysokości 2 miliardów dolarów, wydał Mixtral, otwarty duży model językowy (LLM), który według niego przewyższa GPT 3.5 OpenAI w kilku testach porównawczych, a jednocześnie jest znacznie bardziej wydajny.

Mistral przyciągnął znaczną inwestycję serii A od Andreessen Horowitz (a16z), firmy venture capital znanej ze strategicznych inwestycji w transformacyjne sektory technologii, zwłaszcza sztuczną inteligencję. W rundzie finansowania uczestniczyli również inni giganci technologiczni, tacy jak Nvidia i Salesforce.

„Mistral znajduje się w centrum małej, ale pełnej pasji społeczności programistów rozwijającej się wokół sztucznej inteligencji typu open source” – powiedział Andreessen Horowitz w ogłoszeniu o finansowaniu. „Dostrojone przez społeczność modele rutynowo dominują w rankingach open source (a nawet pokonują modele zamknięte w niektórych zadaniach)”.

Mixtral wykorzystuje technikę zwaną rzadką mieszanką ekspertów (MoE), która według Mistral sprawia, że model jest potężniejszy i wydajniejszy niż jego poprzednik, Mistral 7b – a nawet jego potężniejsi konkurenci.

Mieszanka ekspertów (MoE) to technika uczenia maszynowego, w której programiści szkolą lub konfigurują wiele wirtualnych modeli eksperckich w celu rozwiązywania złożonych problemów. Każdy model ekspercki jest szkolony w zakresie określonego tematu lub dziedziny. Gdy pojawia się problem, model wybiera grupę ekspertów z puli agentów, a ci eksperci wykorzystują swoje szkolenie, aby zdecydować, który wynik lepiej pasuje do ich wiedzy.

MoE może poprawić pojemność, wydajność i dokładność modeli głębokiego uczenia się – sekretny sos, który odróżnia Mixtral od reszty, zdolny do konkurowania z modelem wyszkolonym na 70 miliardach parametrów przy użyciu modelu 10 razy mniejszego.

„Mixtral ma 46,7 mld całkowitych parametrów, ale wykorzystuje tylko 12,9 mld parametrów na token” – powiedział Mistral AI. „W związku z tym przetwarza dane wejściowe i generuje dane wyjściowe z taką samą prędkością i przy takich samych kosztach jak model 12,9B”.

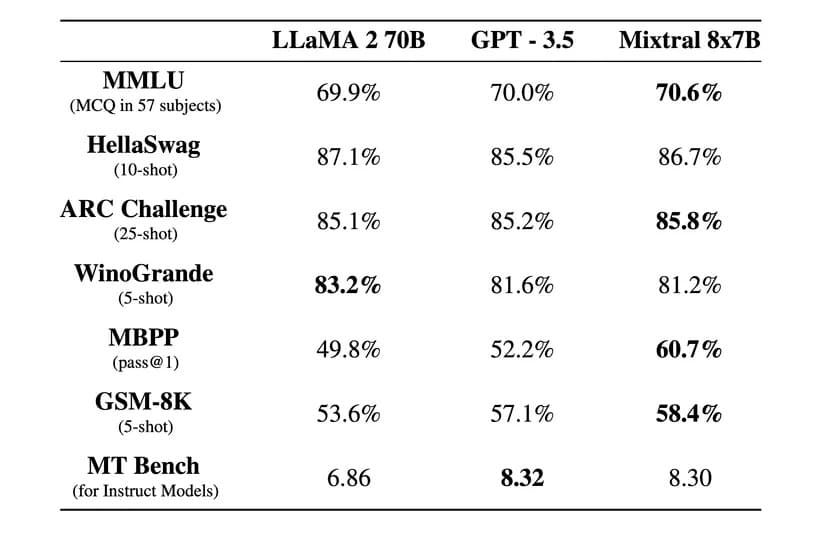

„Mixtral przewyższa Llama 2 70B w większości testów porównawczych z 6-krotnie szybszym wnioskowaniem i dorównuje lub przewyższa GPT 3.5 w większości standardowych testów porównawczych” – powiedział Mistral AI w oficjalnym poście na blogu.

Image: Mistral AI

Mixtral jest również licencjonowany na podstawie liberalnej licencji Apache 2.0. Pozwala to programistom na swobodne przeglądanie, uruchamianie, modyfikowanie, a nawet tworzenie niestandardowych rozwiązań na podstawie modelu.

Istnieje jednak debata na temat tego, czy Mixtral jest w 100% open source, czy nie, ponieważ Mistral twierdzi, że wydał tylko „otwarte wagi”, a licencja podstawowego modelu uniemożliwia jego wykorzystanie do konkurowania z Mistral AI. Startup nie udostępnił również zestawu danych szkoleniowych ani kodu użytego do stworzenia modelu, co miałoby miejsce w przypadku projektu open source.

Firma twierdzi, że Mixtral został dopracowany tak, aby działał wyjątkowo dobrze w językach obcych oprócz angielskiego. „Mixtral 8x7B opanował francuski, niemiecki, hiszpański, włoski i angielski”, uzyskując wysokie wyniki w standardowych wielojęzycznych testach porównawczych, powiedział Mistral AI.

Wersja z instrukcjami o nazwie Mixtral 8x7B Instruct została również wydana w celu uważnego śledzenia instrukcji, osiągając najwyższy wynik 8,3 w teście MT-Bench. Czyni go to najlepszym obecnie modelem open source w tym benchmarku.

Nowy model Mistral obiecuje rewolucyjną architekturę sparse mixture-of-experts, dobre możliwości wielojęzyczne i całkowicie otwarty dostęp, a biorąc pod uwagę, że stało się to zaledwie kilka miesięcy po jego stworzeniu, społeczność open source przechodzi przez ekscytującą i interesującą erę.

Mixtral jest dostępny do pobrania za pośrednictwem Hugging Face, ale użytkownicy mogą również korzystać z wersji instruktażowej online.