Парижский стартап Mistral AI, недавно получивший оценку в 2 миллиарда долларов, выпустил Mixtral, открытую модель большого языка (LLM), которая, по его словам, превосходит GPT 3.5 от OpenAI в нескольких тестах и при этом гораздо эффективнее.

Mistral привлекла значительные инвестиции в рамках серии А от Andreessen Horowitz (a16z), венчурной фирмы, известной своими стратегическими инвестициями в трансформирующиеся технологические отрасли, особенно в ИИ. Другие технологические гиганты, такие как Nvidia и Salesforce, также приняли участие в раунде финансирования.

«Mistral находится в центре небольшого, но страстного сообщества разработчиков, растущего вокруг ИИ с открытым исходным кодом», — говорится в заявлении Andreessen Horowitz о финансировании. «Настроенные сообществом модели теперь регулярно доминируют в таблицах лидеров с открытым исходным кодом (и даже опережают модели с закрытым исходным кодом в некоторых задачах)».

Mixtral использует технику, называемую разреженной смесью экспертов (MoE), которая, по словам Mistral, делает модель более мощной и эффективной, чем ее предшественница Mistral 7b и даже более мощные конкуренты.

Смесь экспертов (MoE) — это метод машинного обучения, при котором разработчики обучают или настраивают несколько виртуальных экспертных моделей для решения сложных задач. Каждая экспертная модель обучается по определенной теме или области. При возникновении проблемы модель выбирает группу экспертов из пула агентов, и эти эксперты на основе своего обучения решают, какой выход лучше подходит для их опыта.

MoE позволяет повысить производительность, эффективность и точность моделей глубокого обучения — секретный соус, который отличает Mixtral от остальных, способных конкурировать с моделью, обученной по 70 миллиардам параметров, используя модель в 10 раз меньше.

«Mixtral имеет 46,7 млрд общих параметров, но использует только 12,9 млрд параметров на токен», — говорится в сообщении Mistral AI. «Поэтому он обрабатывает входные данные и генерирует выходные с той же скоростью и за те же деньги, что и модель с 12,9 млрд параметров».

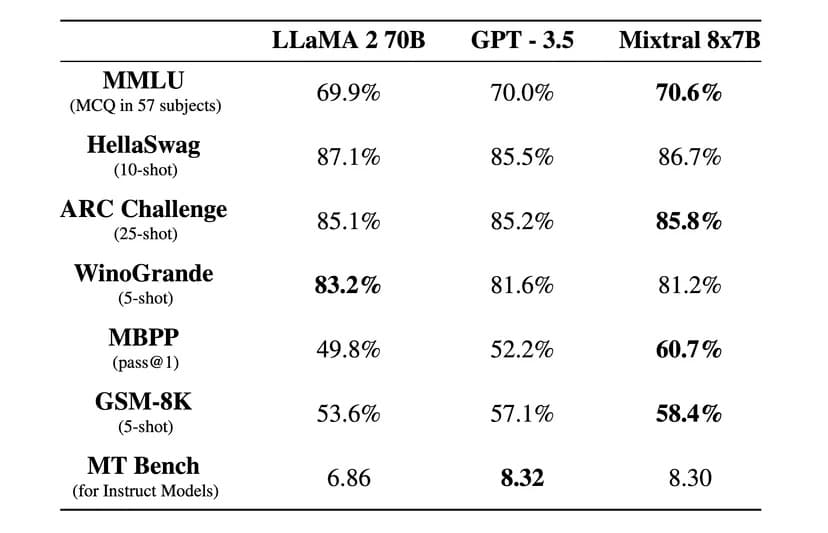

«Mixtral превосходит Llama 2 70B в большинстве бенчмарков с 6-кратным ускорением вывода и соответствует или превосходит GPT 3.5 в большинстве стандартных бенчмарков», — говорится в официальном блоге Mistral AI.

Изображение: Mistral AI

Mixtral также лицензируется по разрешительной лицензии Apache 2.0. Это позволяет разработчикам свободно изучать, запускать, модифицировать и даже создавать собственные решения на основе модели.

Однако существует спор о том, является ли Mixtral на 100% открытым исходным кодом или нет, поскольку Mistral утверждает, что выпустила только «открытый вес», а лицензия основной модели не позволяет использовать ее для конкуренции с Mistral AI. Стартап также не предоставил обучающий набор данных и код, использованный для создания модели, что должно быть в случае проекта с открытым исходным кодом.

В компании утверждают, что Mixtral был доработан таким образом, чтобы отлично работать не только на английском, но и на иностранных языках. По словам Mistral AI, «Mixtral 8x7B владеет французским, немецким, испанским, итальянским и английским языками», получая высокие баллы по стандартизированным многоязычным тестам.

Также была выпущена версия с инструкциями под названием Mixtral 8x7B Instruct для тщательного следования инструкциям, которая получила высший балл 8,3 в бенчмарке MT-Bench. Это делает ее лучшей моделью с открытым исходным кодом в этом бенчмарке.

Новая модель Mistral обещает революционную архитектуру с разреженной смесью экспертов, хорошие многоязычные возможности и полный открытый доступ. А учитывая, что это произошло всего через несколько месяцев после создания, сообщество open-source переживает захватывающую и интересную эпоху.

Mixtral доступен для загрузки через Hugging Face, но пользователи также могут использовать инструктивную версию онлайн.