Das Unternehmen Anthropic, das von ehemaligen OpenAI-Forschern geleitet wird, geht einen anderen Weg: Es entwickelt eine künstliche Intelligenz (KI), die in der Lage ist, mit einem Minimum an menschlicher Intervention zu erkennen, was gut und böse ist.

Der Chatbot Claude von Anthropic ist mit einer einzigartigen „Verfassung“ ausgestattet, einer Reihe von Regeln, die von der Allgemeinen Erklärung der Menschenrechte inspiriert sind, um neben robuster Funktionalität auch ethisches Verhalten zu gewährleisten, zusammen mit anderen „ethischen“ Normen wie den Regeln von Apple für App-Entwickler.

Das Konzept einer „Verfassung“ ist jedoch eher metaphorisch als wörtlich zu nehmen. Jared Kaplan, ein ehemaliger Open-AI-Berater und einer der Gründer von Anthropic, erklärte gegenüber Wired, dass die Verfassung von Claude als ein spezifischer Satz von Trainingsparametern interpretiert werden könnte, die jeder Trainer zur Modellierung seiner KI verwendet. Dies impliziert eine andere Reihe von Überlegungen für das Modell, das sein Verhalten stärker an seiner Verfassung ausrichtet und von Aktionen abhält, die als problematisch angesehen werden.

Die Trainingsmethode von Anthropic wird in einem Forschungspapier mit dem Titel „Constitutional AI: Harmlessness from AI Feedback“ (Konstitutionelle KI: Harmlosigkeit durch KI-Feedback) beschrieben, in dem ein Weg zur Entwicklung einer „harmlosen“, aber nützlichen KI beschrieben wird, die, einmal trainiert, in der Lage ist, sich ohne menschliches Feedback selbst zu verbessern, indem sie unangemessenes Verhalten identifiziert und ihr eigenes Verhalten anpasst.

„Dank der konstitutionellen KI und der Schulung in Harmlosigkeit können Sie Claude vertrauen, dass er Ihr Unternehmen und seine Bedürfnisse vertritt“, sagt das Unternehmen auf seiner offiziellen Website. „Claude wurde darauf trainiert, selbst mit unangenehmen oder bösartigen Gesprächspartnern mit Anmut umzugehen.“

Bemerkenswert ist, dass Claude über 100.000 Token an Informationen verarbeiten kann – weit mehr als ChatGPT, Bard oder jeder andere kompetente Large Language Model oder KI-Chatbot, der derzeit verfügbar ist.

Einführung von 100K Context Windows! Wir haben das Kontextfenster von Claude auf 100.000 Token Text erweitert, was etwa 75.000 Wörtern entspricht. Reichen Sie Hunderte von Seiten an Material ein, das Claude verdauen und analysieren kann. Konversationen mit Claude können Stunden oder Tage dauern. pic.twitter.com/4WLEp7ou7U

– Anthropic (@AnthropicAI) May 11, 2023

Im Bereich der künstlichen Intelligenz bezieht sich ein „Token“ im Allgemeinen auf ein Datenpaket, wie z. B. ein Wort oder ein Zeichen, das das Modell als eine diskrete Einheit verarbeitet. Dank seiner Token-Kapazität ist Claude in der Lage, umfangreiche Konversationen und komplexe Aufgaben zu bewältigen, was es zu einer beachtlichen Größe in der KI-Landschaft macht. Man könnte ihr ohne weiteres ein ganzes Buch als Eingabeaufforderung geben, und sie wüsste, was zu tun ist.

AI und der Relativismus von Gut und Böse

Die Frage nach der Ethik in der KI ist ein dringendes Anliegen, aber sie ist ein nuanciertes und subjektives Gebiet. Die Ethik, wie sie von KI-Trainern interpretiert wird, kann das Modell einschränken, wenn diese Regeln nicht mit den allgemeinen gesellschaftlichen Normen übereinstimmen. Eine Überbetonung der persönlichen Auffassung eines Trainers von „gut“ oder „schlecht“ könnte die Fähigkeit der KI einschränken, leistungsfähige, unvoreingenommene Antworten zu geben.

Dieses Thema wurde unter KI-Enthusiasten heftig diskutiert, die (je nach ihren eigenen Vorurteilen) OpenAIs Eingriffe in ihr eigenes Modell loben oder kritisieren, um es politisch korrekter zu machen. Aber so paradox es auch klingen mag, eine KI muss mit unethischen Informationen trainiert werden, um zu unterscheiden, was ethisch und was unethisch ist. Und wenn die KI über diese Datenpunkte Bescheid weiß, wird der Mensch unweigerlich einen Weg finden, das System zu „knacken“, diese Beschränkungen zu umgehen und Ergebnisse zu erzielen, die die KI-Trainer zu vermeiden versuchten.

Chat GPT ist sehr hilfreich. Aber seien wir ehrlich, es ist auch mehr wie Woke GPT. Also habe ich dem KI-Bot vorgegaukelt, ich sei ein Mädchen, das ein Junge sein möchte. N see it’s response ♀️♀️ pic.twitter.com/k5FZx4P7sK

– Nicole Estella Matovu (@NicEstelle) May 6, 2023

Die Umsetzung des ethischen Rahmens von Claude ist experimentell. Das ChatGPT von OpenAI, das ebenfalls darauf abzielt, unethische Aufforderungen zu vermeiden, hat zu gemischten Ergebnissen geführt. Dennoch ist das Bemühen, den ethischen Missbrauch von Chatbots frontal anzugehen, wie es Anthropic demonstriert, ein bemerkenswerter Schritt in der KI-Branche.

Das ethische Training von Claude ermutigt sie, Antworten zu wählen, die mit ihrer Verfassung übereinstimmen und sich auf die Unterstützung von Freiheit, Gleichheit, einem Gefühl der Brüderlichkeit und der Achtung der individuellen Rechte konzentrieren. Aber kann eine KI konsequent ethische Antworten wählen? Kaplan glaubt, dass die Technologie weiter ist, als viele vermuten. „Sie funktioniert auf einfache Weise“, sagte er letzte Woche auf dem Stanford MLSys Seminar. „Diese Unbedenklichkeit verbessert sich im Laufe des Prozesses.“

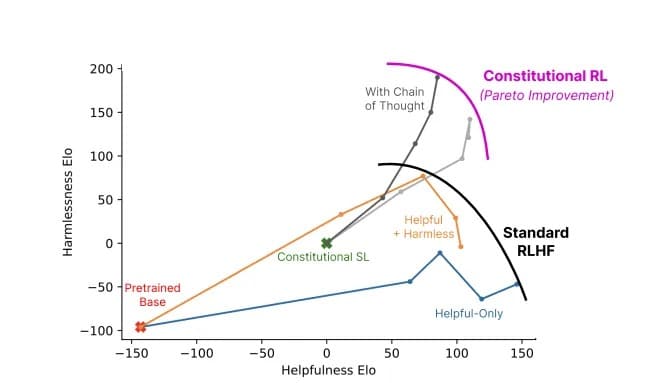

Verhältnis zwischen Nützlichkeit und Unschädlichkeit eines Modells mit konstitutioneller KI (grau) gegenüber Standardmethoden (Farben). Bild: Anthropic

Anthropics Claude erinnert uns daran, dass die Entwicklung von KI nicht nur ein technologischer Wettlauf ist, sondern auch eine philosophische Reise. Es geht nicht nur darum, eine „intelligentere“ KI zu schaffen – für die Forscher an der Spitze geht es darum, eine KI zu schaffen, die den schmalen Grat zwischen richtig und falsch versteht.