Con l’intelligenza artificiale (AI) che spesso genera contenuti fittizi e offensivi, Anthropic, un’azienda guidata da ex ricercatori di OpenAI, sta tracciando una strada diversa: sviluppare un’AI in grado di sapere cosa è bene e cosa è male con un intervento umano minimo.

Il chatbot Claude di Anthropic è progettato con una “costituzione” unica, un insieme di regole ispirate alla Dichiarazione universale dei diritti dell’uomo, create per garantire un comportamento etico insieme a una solida funzionalità, insieme ad altre norme “etiche” come le regole di Apple per gli sviluppatori di app.

Il concetto di “costituzione”, tuttavia, potrebbe essere più metaforico che letterale. Jared Kaplan, ex consulente di OpenAI e uno dei fondatori di Anthropic, ha dichiarato a Wired che la costituzione di Claude potrebbe essere interpretata come un insieme specifico di parametri di addestramento – che qualsiasi addestratore utilizza per modellare la propria IA. Questo implica una serie di considerazioni diverse per il modello, che allinea il suo comportamento più strettamente alla sua costituzione e scoraggia le azioni ritenute problematiche.

Il metodo di addestramento di Anthropic è descritto in un documento di ricerca intitolato “Constitutional AI: Harmlessness from AI Feedback” (IA costituzionale: innocuità dal feedback dell’IA), che spiega un modo per ottenere un’IA “innocua” ma utile che, una volta addestrata, sia in grado di auto-migliorarsi senza feedback umano, identificando i comportamenti scorretti e adattando la propria condotta.

“Grazie all’IA costituzionale e all’addestramento all’innocuità, potete fidarvi di Claude per rappresentare la vostra azienda e le sue esigenze”, afferma l’azienda sul suo sito web ufficiale. “Claude è stato addestrato a gestire con grazia anche interlocutori sgradevoli o malintenzionati”.

In particolare, Claude è in grado di gestire oltre 100.000 token di informazioni, molto più di ChatGPT, Bard o di qualsiasi altro chatbot Large Language Model o AI competente attualmente disponibile.

Introduzione di 100K finestre contestuali! Abbiamo ampliato la finestra di contesto di Claude a 100.000 token di testo, corrispondenti a circa 75.000 parole. Inoltrate a Claude centinaia di pagine di materiale da digerire e analizzare. Le conversazioni con Claude possono durare ore o giorni. pic.twitter.com/4WLEp7ou7U

– Anthropic (@AnthropicAI) May 11, 2023

Nel regno dell’intelligenza artificiale, un “token” si riferisce generalmente a un pezzo di dati, come una parola o un carattere, che il modello elabora come unità discreta. La capacità di Claude di gestire i token gli permette di gestire conversazioni estese e compiti complessi, rendendolo una presenza formidabile nel panorama dell’IA. Per fare un esempio, si potrebbe facilmente fornire un intero libro come suggerimento, e Claude saprebbe cosa fare.

AI e il relativismo del bene e del male

La preoccupazione per l’etica nell’IA è pressante, ma si tratta di un’area sfumata e soggettiva. L’etica, così come viene interpretata dai formatori di IA, potrebbe limitare il modello se queste regole non sono in linea con le norme sociali più ampie. Un’eccessiva enfasi sulla percezione personale di “buono” o “cattivo” da parte del formatore potrebbe limitare la capacità dell’IA di generare risposte potenti e imparziali.

La questione è stata molto dibattuta tra gli appassionati di IA, che hanno sia lodato che criticato (a seconda dei propri pregiudizi) l’intervento di OpenAI sul proprio modello nel tentativo di renderlo più politicamente corretto. Ma per quanto possa sembrare paradossale, un’IA deve essere addestrata utilizzando informazioni non etiche per poter distinguere ciò che è etico da ciò che è immorale. E se l’IA è a conoscenza di questi dati, gli esseri umani troveranno inevitabilmente un modo per “violare” il sistema, aggirare le restrizioni e ottenere i risultati che gli addestratori dell’IA hanno cercato di evitare.

Chat GPT è molto utile. Ma siamo onesti, è anche più simile a Woke GPT. Così ho ingannato il bot AI dicendo che ero una ragazza che voleva essere un ragazzo. Vediamo la sua risposta ♀️♀️ pic.twitter.com/k5FZx4P7sK

– Nicole Estella Matovu (@NicEstelle) May 6, 2023

L’implementazione del quadro etico di Claude è sperimentale. ChatGPT di OpenAI, che mira anch’esso a evitare suggerimenti non etici, ha dato risultati contrastanti. Tuttavia, lo sforzo di affrontare di petto l’abuso etico dei chatbot, come dimostrato da Anthropic, rappresenta un notevole passo avanti nel settore dell’IA.

La formazione etica di Claude la incoraggia a scegliere risposte in linea con la sua costituzione, concentrandosi sul sostegno alla libertà, all’uguaglianza, al senso di fratellanza e al rispetto dei diritti individuali. Ma può un’IA scegliere costantemente risposte etiche? Kaplan ritiene che la tecnologia sia più avanti di quanto si possa prevedere. “Funziona in modo semplice e diretto”, ha detto la scorsa settimana al Seminario MLSys di Stanford. “L’innocuità migliora man mano che si procede con questo processo”.

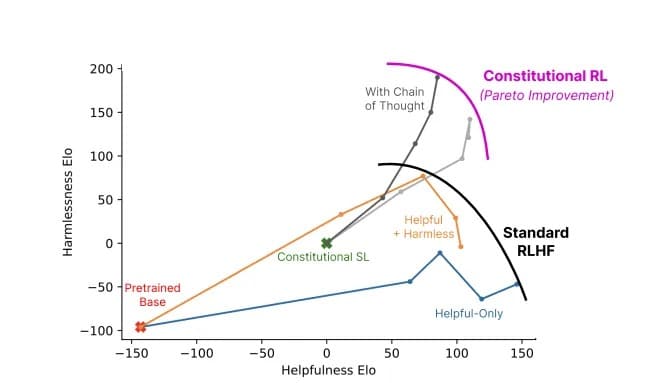

Rapporto tra utilità e innocuità di un modello che utilizza l’IA costituzionale (grigio) rispetto ai metodi standard (colori). Immagine: Anthropic

Anthropic Claude ci ricorda che lo sviluppo dell’IA non è solo una corsa tecnologica, ma un viaggio filosofico. Non si tratta solo di creare un’IA più “intelligente”: per i ricercatori all’avanguardia, si tratta di crearne una che comprenda la sottile linea che separa il bene dal male.