W czasach, gdy sztuczna inteligencja (AI) często generuje fikcyjne i obraźliwe treści, Anthropic, firma kierowana przez byłych badaczy OpenAI, wyznacza inny kurs – rozwijając sztuczną inteligencję zdolną do poznania dobra i zła przy minimalnej interwencji człowieka.

Chatbot Claude firmy Anthropic został zaprojektowany w oparciu o unikalną „konstytucję”, zestaw zasad inspirowanych Powszechną Deklaracją Praw Człowieka, opracowanych w celu zapewnienia etycznego zachowania obok solidnej funkcjonalności, wraz z innymi „etycznymi” normami, takimi jak zasady Apple dla twórców aplikacji.

Koncepcja „konstytucji” może być jednak bardziej metaforyczna niż dosłowna. Jared Kaplan, były konsultant OpenAI i jeden z założycieli Anthropic, powiedział Wired, że konstytucję Claude’a można interpretować jako określony zestaw parametrów treningowych – które każdy trener wykorzystuje do modelowania swojej sztucznej inteligencji. Wiąże się to z innym zestawem rozważań dla modelu, który dostosowuje swoje zachowanie ściślej do swojej konstytucji i zniechęca do działań uznanych za problematyczne.

Metoda treningowa Anthropic została opisana w artykule badawczym zatytułowanym „Constitutional AI: Harmlessness from AI Feedback”, który wyjaśnia sposób na stworzenie „nieszkodliwej”, ale użytecznej sztucznej inteligencji, która po wyszkoleniu jest w stanie samodoskonalić się bez informacji zwrotnej od człowieka, identyfikując niewłaściwe zachowanie i dostosowując własne postępowanie.

„Dzięki konstytucyjnej sztucznej inteligencji i szkoleniu w zakresie nieszkodliwości, możesz zaufać Claude, że będzie reprezentować Twoją firmę i jej potrzeby” – mówi firma na swojej oficjalnej stronie internetowej. „Claude został przeszkolony, aby z wdziękiem radzić sobie nawet z nieprzyjemnymi lub złośliwymi partnerami konwersacyjnymi”.

Claude może obsłużyć ponad 100 000 tokenów informacji – znacznie więcej niż ChatGPT, Bard lub jakikolwiek inny kompetentny duży model językowy lub chatbot AI obecnie dostępny.

Wprowadzamy 100 tysięcy okien kontekstowych! Rozszerzyliśmy okno kontekstowe Claude’a do 100 000 tokenów tekstu, co odpowiada około 75 000 słów. Prześlij setki stron materiałów do przetrawienia i przeanalizowania przez Claude’a. Rozmowy z Claude mogą trwać godzinami lub dniami. pic.twitter.com/4WLEp7ou7U

– Anthropic (@AnthropicAI) 11 maja 2023

W dziedzinie sztucznej inteligencji „token” ogólnie odnosi się do fragmentu danych, takich jak słowo lub znak, które model przetwarza jako dyskretną jednostkę. Pojemność tokenów Claude’a pozwala mu zarządzać obszernymi rozmowami i złożonymi zadaniami, co czyni go potężnym graczem w dziedzinie sztucznej inteligencji. Dla kontekstu, możesz z łatwością podać całą książkę jako podpowiedź, a ona będzie wiedziała, co zrobić.

AI i relatywizm dobra kontra zła

Problem etyki w sztucznej inteligencji jest palący, ale jest to obszar zniuansowany i subiektywny. Etyka interpretowana przez trenerów AI może ograniczać model, jeśli zasady te nie są zgodne z szerszymi normami społecznymi. Nadmierny nacisk na osobiste postrzeganie „dobra” lub „zła” przez trenera może ograniczyć zdolność sztucznej inteligencji do generowania potężnych, bezstronnych odpowiedzi.

Kwestia ta była przedmiotem gorącej debaty wśród entuzjastów sztucznej inteligencji, którzy zarówno chwalą, jak i krytykują (w zależności od własnych uprzedzeń) interwencję OpenAI we własny model, próbując uczynić go bardziej poprawnym politycznie. Jakkolwiek paradoksalnie by to nie brzmiało, sztuczna inteligencja musi być szkolona przy użyciu nieetycznych informacji, aby odróżnić to, co etyczne, od tego, co nieetyczne. A jeśli AI wie o tych punktach danych, ludzie nieuchronnie znajdą sposób na „złamanie więzienia” systemu, ominięcie tych ograniczeń i osiągnięcie wyników, których trenerzy AI próbowali uniknąć.

Chat GPT jest bardzo pomocny. Ale bądźmy szczerzy, bardziej przypomina Woke GPT. Więc oszukałem bota AI, że jestem dziewczyną, która chce być chłopcem. N zobacz jego odpowiedź ♀️♀️ pic.twitter.com/k5FZx4P7sK

– Nicole Estella Matovu (@NicEstelle) May 6, 2023

Wdrożenie ram etycznych Claude’a jest eksperymentalne. ChatGPT OpenAI, który również ma na celu uniknięcie nieetycznych podpowiedzi, przyniósł mieszane rezultaty. Jednak wysiłki zmierzające do rozwiązania problemu etycznego niewłaściwego wykorzystania chatbotów, jak pokazał Anthropic, są znaczącym krokiem w branży sztucznej inteligencji.

Szkolenie etyczne Claude’a zachęca go do wybierania odpowiedzi zgodnych z jego konstytucją, koncentrując się na wspieraniu wolności, równości, poczucia braterstwa i poszanowania praw jednostki. Ale czy SI może konsekwentnie wybierać etyczne odpowiedzi? Kaplan uważa, że technologia ta jest bardziej zaawansowana, niż wielu mogłoby się spodziewać. „To po prostu działa w prosty sposób” – powiedział podczas Stanford MLSys Seminar w zeszłym tygodniu. „Ta nieszkodliwość poprawia się w miarę przechodzenia przez ten proces.”

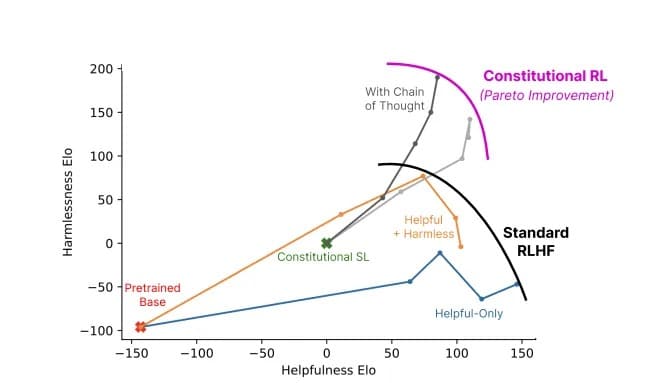

Stosunek pomocności do nieszkodliwości modelu wykorzystującego konstytucyjną sztuczną inteligencję (szary) w porównaniu ze standardowymi metodami (kolory). Image: Anthropic

Anthropic’s Claude przypomina nam, że rozwój sztucznej inteligencji to nie tylko wyścig technologiczny; to filozoficzna podróż. Nie chodzi tylko o stworzenie sztucznej inteligencji, która jest bardziej „inteligentna” – dla badaczy na krawędzi, chodzi o stworzenie takiej, która rozumie cienką linię oddzielającą dobro od zła.