人工知能(AI)がしばしば架空で不快なコンテンツを生み出す中、元OpenAIの研究者が率いるAnthropic社は、人間の介入を最小限に抑え、善悪を知ることができるAIを開発し、異なる道を歩んでいます。

Anthropic社のチャットボット「Claude」は、世界人権宣言にインスパイアされた独自の「憲法」によって設計されており、堅牢な機能性とともに倫理的な行動を保証するように作られています。

しかし、「憲法」という概念は、文字どおりというよりも比喩的なものかもしれません。元OpenAIのコンサルタントでAnthropicの創設者の一人であるJared Kaplan氏はWiredに、クロードの憲法は、どのトレーナーもAIのモデル化に使用する、特定のトレーニングパラメータのセットと解釈することができると語っています。このことは、モデルにとって異なる考慮事項のセットを意味し、その行動をよりその憲法に近づけ、問題があるとみなされる行動を抑制することになります。

Anthropicのトレーニング方法は、「Constitutional AI: Harmlessness from AI Feedback」と題された研究論文で説明されており、「無害」だが役に立つAIを作り出す方法について説明しています。

“体質改善AIと無害化トレーニングのおかげで、Claudeを信頼してあなたの会社とそのニーズを代表することができます。”と同社は公式サイトで述べています。”クロードは、不快な、あるいは悪意のある会話相手でも優雅に扱えるように訓練されています。”

注目すべきは、クロードが10万トークンを超える情報を扱えることです。ChatGPTやBard、その他現在利用できる有能な大規模言語モデルやAIチャットボットよりも多いのです。

(ユーブイエックスダブリューエヌ

10万個のコンテキストウィンドウを導入しました!Claudeのコンテキストウィンドウを10万トークン(約75Kワード)に拡張しました。クロードが消化・分析するために、何百ページもの資料を提出することができます。クロードとの会話は、数時間から数日にわたって続くこともあります。pic.twitter.com/4WLEp7ou7U

– Anthropic (@AnthropicAI) May 11, 2023

(ユーブイエックスダブリュージェイ)

(ユーブイエックスダブリューケー

AIの領域では、一般的に「トークン」とは、単語や文字などのデータの塊を指し、モデルはそれを離散的な単位として処理します。クロードのトークン能力は、広範な会話や複雑なタスクを管理することを可能にし、AIの世界で手ごわい存在となっている。文脈上、本一冊をプロンプトとして提供することは容易であり、クロードは何をすべきかを知ることができます。

AIと善と悪の相対主義

AIにおける倫理に関する懸念は差し迫ったものですが、ニュアンスが異なり、主観的な分野でもあります。AIトレーナーが解釈する倫理は、そのルールがより広い社会的規範と一致しない場合、モデルを制限する可能性があります。トレーナーの個人的な「良い」「悪い」に対する認識を過度に重視すると、AIがパワフルで偏りのない反応を生み出す能力が低下する可能性があります。

この問題は、AI愛好家の間で盛んに議論されており、OpenAIのモデルをより政治的に正しいものにしようとする介入を、(それぞれのバイアスによって)賞賛したり批判したりします。しかし、逆説的に聞こえるかもしれませんが、倫理的なものと非倫理的なものを区別するためには、非倫理的な情報を使ってAIを訓練する必要があるのです。そして、AIがそれらのデータポイントを知っていれば、人間は必然的にシステムを「脱獄」する方法を見つけ、それらの制限を回避し、AIのトレーナーが避けようとした結果を達成することができます。

(ユーブイエックスワン

Chat GPTはとても便利です。でも、正直に言うとWoke GPTにも似ています。というわけで、AIボットに「男の子になりたい女の子」と騙してみました。N see it’s response ♀️♀️ pic.twitter.com/k5FZx4P7sK

– Nicole Estella Matovu (@NicEstelle) May 6, 2023

(ユーブイエックスダブリュージェイ)

(ユーブイエックスダブリューケー

クロードの倫理フレームワークの実装は実験的なもの。同じく非倫理的なプロンプトを回避することを目的としたOpenAIのChatGPTは、さまざまな結果をもたらしている。しかし、Anthropicが示したように、チャットボットの倫理的な誤用に正面から取り組もうとする努力は、AI業界において注目すべき前進である。

クロードの倫理教育では、自由、平等、同胞意識、個人の権利の尊重を支持することに重点を置き、その憲法に沿った対応を選択するよう促しています。しかし、AIは一貫して倫理的な対応を選択できるのでしょうか?カプランは、この技術は多くの人が予想するよりも進んでいると考えています。”これはただ単純明快に機能する “と、彼は先週のスタンフォードMLSysセミナーで語った。”この害のなさは、このプロセスを経るにつれて改善されていく “

。

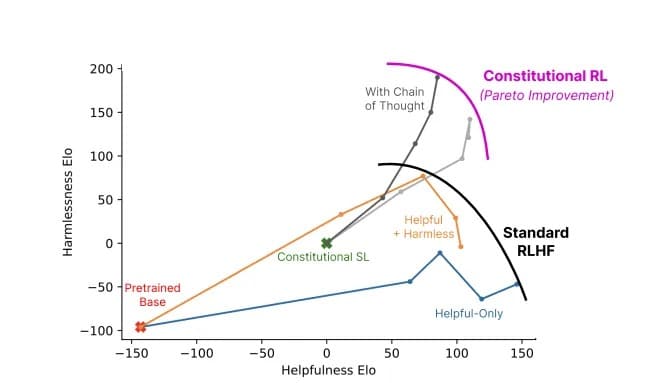

憲法AIを用いたモデル(グレー)と標準的な手法(色)を比較した場合の有用性対無害性比。画像は Anthropic

Anthropicのクロードは、AIの開発は単なる技術競争ではなく、哲学的な旅であることを思い出させてくれます。より「知的」なAIを作るだけでなく、最先端の研究者にとっては、正しいことと間違ったことを区別する細い線を理解するAIを作ることが重要なのです。