随着人工智能(AI)经常产生虚构和攻击性的内容,由前OpenAI研究人员掌舵的Anthropic公司正在制定一条不同的路线–开发一种能够在最少的人类干预下知道什么是善与恶的AI。

Anthropic的聊天机器人Claude设计了一套独特的 “宪法”,这套规则受到《世界人权宣言》的启发,旨在确保道德行为和强大的功能,以及其他 “道德 “规范,如苹果的应用程序开发人员规则。

然而,”宪法 “的概念可能更多的是比喻,而不是字面意思。前OpenAI顾问和Anthropic的创始人之一Jared Kaplan告诉《连线》,Claude的宪法可以被解释为一组特定的训练参数–任何训练者都会使用这些参数来为其AI建模。这意味着对模型有一套不同的考虑,使其行为更接近于其章程,并阻止被认为有问题的行动。

Anthropic的训练方法在一篇题为 “宪法人工智能:来自人工智能反馈的无害性 “的研究论文中有所描述,该论文解释了一种提出 “无害 “但有用的人工智能的方法,这种人工智能一旦经过训练,就能够在没有人类反馈的情况下自我改进,识别不当的行为并调整自己的行为。

“由于宪法规定的人工智能和无害化训练,你可以信任克劳德来代表你的公司和它的需求,”该公司在其官方网站上说。”克劳德经过训练,甚至可以优雅地处理不愉快的或恶意的对话伙伴。”

值得注意的是,克劳德可以处理超过10万个信息代币–比ChatGPT、巴德或目前任何其他有能力的大型语言模型或人工智能聊天机器人都要多。

引入10万个语境窗口! 我们已经将Claude的上下文窗口扩展到了100,000个文本标记,对应于大约75K个单词。提交数百页的材料供克劳德消化和分析。与克劳德的对话可以持续数小时或数天。pic.twitter.com/4WLEp7ou7U

– Anthropic (@AnthropicAI) May 11, 2023

在人工智能领域,”令牌 “通常是指一个数据块,如一个单词或字符,模型将其作为一个离散单位来处理。克劳德的令牌能力使其能够管理广泛的对话和复杂的任务,使其成为人工智能领域的一个强大的存在。就背景而言,你可以很容易地提供一整本书作为提示,它就知道该怎么做。

AI和善与恶的相对主义

对人工智能中的道德问题的关注是一个紧迫的问题,然而这是一个细微的、主观的领域。如果这些规则与更广泛的社会规范不一致,人工智能培训师所解释的道德可能会限制该模型。过分强调培训师对 “好 “或 “坏 “的个人看法,可能会削弱人工智能产生强大、无偏见的反应的能力。

这个问题在人工智能爱好者中引起了激烈的争论,他们既赞扬又批评(取决于他们自己的偏见)OpenAI对其自身模型的干预,试图使其在政治上更加正确。但尽管听起来很矛盾,人工智能必须使用不道德的信息进行训练,以便区分什么是道德的,什么是不道德的。如果人工智能知道这些数据点,人类将不可避免地找到一种方法来 “越狱 “系统,绕过这些限制,并实现人工智能的训练者试图避免的结果。

Chat GPT很有帮助。但说实话,它也更像Woke GPT。所以我骗人工智能机器人说我是一个想成为男孩的女孩。N see it’s response ♀️♀️ pic.twitter.com/k5FZx4P7sK

– Nicole Estella Matovu (@NicEstelle) May 6, 2023

克劳德的伦理框架的实施是实验性的。OpenAI的ChatGPT,其目的也是为了避免不道德的提示,其结果好坏参半。然而,正如Anthropic所展示的那样,正面解决聊天机器人的道德滥用问题的努力,是人工智能行业的一个显著进步。

克劳德的道德训练鼓励它选择符合其宪法的反应,重点是支持自由、平等、兄弟情谊和尊重个人权利。但是,人工智能能够始终如一地选择符合道德的反应吗?卡普兰认为,这项技术比许多人可能预期的要更进一步。”这只是以一种直接的方式工作,”他在上周的斯坦福MLSys研讨会上说。”在你经历这个过程时,这种无害性会得到改善。”

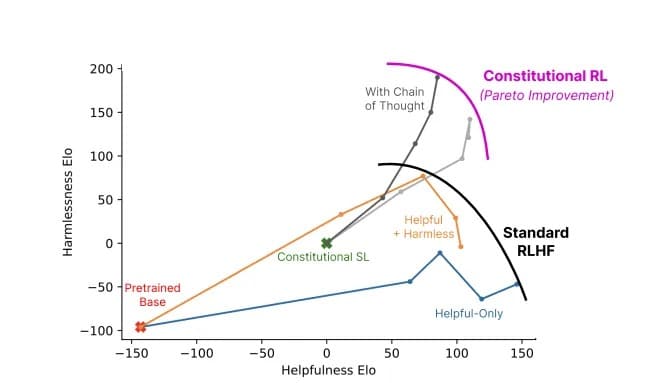

使用宪法人工智能(灰色)与标准方法(颜色)的模型的帮助性与无害性比率。图片: Anthropic

Anthropic的克劳德提醒我们,人工智能的发展不仅仅是一场技术竞赛,它还是一场哲学之旅。这不仅仅是创造更 “聪明 “的人工智能–对于处于前沿的研究人员来说,这是在创造一个了解区分正确与错误的细线。