La inteligencia artificial (IA) genera a menudo contenidos ficticios y ofensivos, pero Anthropic, una empresa dirigida por antiguos investigadores de OpenAI, está trazando un camino diferente: desarrollar una IA capaz de distinguir entre el bien y el mal con una intervención humana mínima.

El chatbot Claude de Anthropic está diseñado con una «constitución» única, un conjunto de normas inspiradas en la Declaración Universal de los Derechos Humanos, creadas para garantizar un comportamiento ético junto con una funcionalidad robusta, junto con otras normas «éticas» como las reglas de Apple para los desarrolladores de aplicaciones.

Sin embargo, el concepto de «constitución» puede ser más metafórico que literal. Jared Kaplan, ex consultor de OpenAI y uno de los fundadores de Anthropic, declaró a Wired que la constitución de Claude podría interpretarse como un conjunto específico de parámetros de entrenamiento -que cualquier entrenador utiliza para modelar su IA-. Esto implica un conjunto diferente de consideraciones para el modelo, que alinea su comportamiento más estrechamente con su constitución y desalienta las acciones consideradas problemáticas.

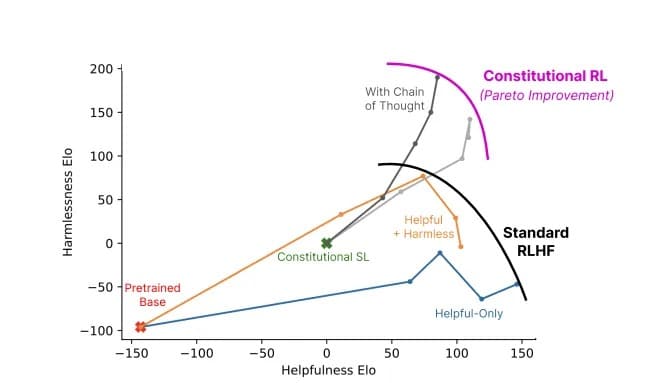

El método de entrenamiento de Anthropic se describe en un trabajo de investigación titulado «Constitutional AI: Harmlessness from AI Feedback», que explica una forma de conseguir una IA «inofensiva» pero útil que, una vez entrenada, sea capaz de mejorar por sí misma sin retroalimentación humana, identificando comportamientos inadecuados y adaptando su propia conducta.

«Gracias a la IA constitucional y al entrenamiento para ser inofensivo, puede confiar en Claude para representar a su empresa y sus necesidades», afirma la empresa en su sitio web oficial. «Claude ha sido entrenado para manejar con gracia incluso a interlocutores desagradables o malintencionados».

En concreto, Claude puede manejar más de 100.000 tokens de información, mucho más que ChatGPT, Bard o cualquier otro chatbot de IA o modelo de lenguaje amplio competente disponible en la actualidad.

¡Presentamos 100.000 ventanas de contexto! Hemos ampliado la ventana de contexto de Claude a 100.000 tokens de texto, correspondientes a unas 75.000 palabras. Envía cientos de páginas de materiales para que Claude los digiera y analice. Las conversaciones con Claude pueden durar horas o días. pic.twitter.com/4WLEp7ou7U

– Anthropic (@AnthropicAI) 11 de mayo de 2023

En el ámbito de la IA, un «token» se refiere generalmente a un fragmento de datos, como una palabra o un carácter, que el modelo procesa como una unidad discreta. La capacidad de Claude para procesar tokens le permite gestionar conversaciones extensas y tareas complejas, lo que la convierte en una presencia formidable en el panorama de la IA. Para contextualizar, se le podría proporcionar fácilmente un libro entero y sabría qué hacer.

La IA y el relativismo del bien frente al mal

La preocupación por la ética en la IA es acuciante, pero se trata de un ámbito matizado y subjetivo. La ética, tal y como la interpretan los instructores de IA, puede limitar el modelo si esas reglas no se ajustan a normas sociales más amplias. Un énfasis excesivo en la percepción personal de «bueno» o «malo» de un formador podría limitar la capacidad de la IA para generar respuestas poderosas e imparciales.

Esta cuestión ha sido objeto de acalorados debates entre los entusiastas de la IA, que tanto alaban como critican (dependiendo de sus propios prejuicios) la intervención de OpenAI en su propio modelo en un intento de hacerlo más políticamente correcto. Pero por paradójico que pueda sonar, una IA debe ser entrenada utilizando información poco ética para poder diferenciar lo que es ético de lo que no lo es. Y si la IA conoce esos datos, los humanos encontrarán inevitablemente una forma de «fugarse» del sistema, saltarse esas restricciones y conseguir los resultados que los entrenadores de la IA intentaron evitar.

Chat GPT es muy útil. Pero seamos honestos también es más como Woke GPT. Así que engañé a la IA bot que yo era una chica que quería ser un chico. N ver su respuesta ♀️♀️ pic.twitter.com/k5FZx4P7sK

– Nicole Estella Matovu (@NicEstelle) 6 de mayo de 2023

La aplicación del marco ético de Claude es experimental. El ChatGPT de OpenAI, que también pretende evitar las indicaciones poco éticas, ha dado resultados desiguales. Sin embargo, el esfuerzo por abordar de frente el mal uso ético de los chatbots, como demuestra Anthropic, es un avance notable en la industria de la IA.

La formación ética de Claude le anima a elegir respuestas que se ajusten a su constitución, centrándose en el apoyo a la libertad, la igualdad, el sentido de la fraternidad y el respeto de los derechos individuales. Pero, ¿puede una IA elegir respuestas éticas de forma coherente? Kaplan cree que la tecnología está más avanzada de lo que muchos podrían anticipar. «Funciona de forma sencilla», afirmó en el Seminario MLSys de Stanford la semana pasada. «Esta inocuidad mejora a medida que se avanza en este proceso».

Relación entre utilidad e inocuidad de un modelo que utiliza IA constitucional (gris) frente a métodos estándar (colores). Imagen: Anthropic

Claude de Anthropic nos recuerda que el desarrollo de la IA no es sólo una carrera tecnológica; es un viaje filosófico. No se trata sólo de crear una IA más «inteligente»: para los investigadores de vanguardia, se trata de crear una IA que entienda la delgada línea que separa el bien del mal.