Въпреки че изкуственият интелект (ИИ) често генерира измислено и обидно съдържание, Anthropic, компания, ръководена от бивши изследователи на OpenAI, поема по различен път – разработва ИИ, способен да разбере кое е добро и зло с минимална човешка намеса.

Чатботът Клод на Anthropic е проектиран с уникална „конституция“ – набор от правила, вдъхновени от Всеобщата декларация за правата на човека, създадени, за да осигурят етично поведение наред с надеждна функционалност, както и други „етични“ норми като правилата на Apple за разработчиците на приложения.

Концепцията за „конституция“ обаче може да е по-скоро метафорична, отколкото буквална. Джаред Каплан, бивш консултант на OpenAI и един от основателите на Anthropic, заяви пред Wired, че конституцията на Клод може да се тълкува като специфичен набор от параметри за обучение – които всеки обучител използва, за да моделира своя ИИ. Това предполага различен набор от съображения за модела, който привежда поведението си в по-тясно съответствие с конституцията си и възпира действия, считани за проблематични.

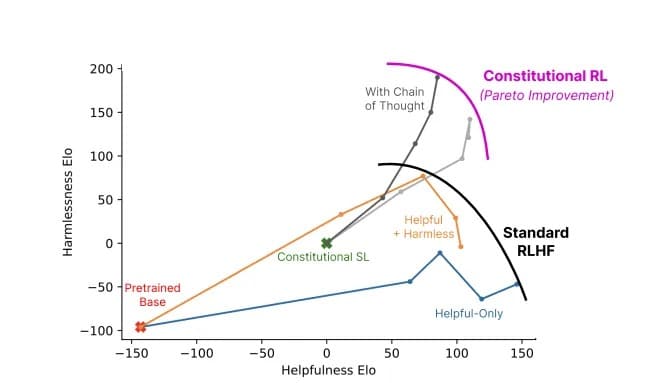

Методът за обучение на Anthropic е описан в изследователска статия, озаглавена „Конституционен ИИ: безвредност от обратната връзка с ИИ“, в която се обяснява начинът за създаване на „безвреден“, но полезен ИИ, който, след като бъде обучен, е в състояние да се самоусъвършенства без човешка обратна връзка, като идентифицира неправилно поведение и адаптира собственото си поведение.

„Благодарение на конституционния ИИ и обучението за безвредност можете да се доверите на Клод да представлява вашата компания и нейните нужди“, казва компанията на официалния си уебсайт. „Клод е обучен да се справя с грациозност дори с неприятни или злонамерени събеседници.“

Забележително е, че Клод може да обработва над 100 000 токена информация – много повече от ChatGPT, Bard или който и да е друг компетентен голям езиков модел или чатбот с изкуствен интелект, наличен в момента.

Въвеждане на 100 хил. контекстни прозорци! Разширихме контекстния прозорец на Клод до 100 000 токена текст, което съответства на около 75 хил. думи. Подайте стотици страници с материали, които Клод да обработи и анализира. Разговорите с Клод могат да продължат с часове или дни. pic.twitter.com/4WLEp7ou7U

– Anthropic (@AnthropicAI) 11 май 2023

В сферата на изкуствения интелект понятието „токен“ обикновено се отнася до част от данни, като дума или символ, които моделът обработва като дискретна единица. Капацитетът на токените на Клод му позволява да управлява обширни разговори и сложни задачи, което го превръща във внушително присъствие в пейзажа на ИИ. За контекст, лесно можете да предоставите цяла книга като подкана и той ще знае какво да направи.

AI и релативизмът на доброто срещу злото

Загрижеността за етиката в изкуствения интелект е належаща, но все пак това е нюансирана и субективна област. Етиката, така както се тълкува от обучаващите ИИ, може да ограничи модела, ако тези правила не съответстват на по-широките обществени норми. Прекаленото акцентиране върху личното възприятие на обучителя за „добро“ или „лошо“ може да ограничи способността на ИИ да генерира мощни, безпристрастни отговори.

Този въпрос е предмет на разгорещени дебати сред ентусиастите на изкуствения интелект, които едновременно хвалят и критикуват (в зависимост от собствените си пристрастия) намесата на OpenAI в собствения ѝ модел в опит да го направи по-политически коректен. Но колкото и парадоксално да звучи, един ИИ трябва да бъде обучен, като използва неетична информация, за да може да разграничи етичното от неетичното. И ако ИИ знае за тези информационни точки, хората неизбежно ще намерят начин да „пробият затвора“ на системата, да заобиколят тези ограничения и да постигнат резултати, които обучителите на ИИ са се опитали да избегнат.

Чатът GPT е много полезен. Но нека бъдем честни, то също така прилича повече на Woke GPT. Така че измамих бота с изкуствен интелект, че съм момиче, което иска да бъде момче. N вижте отговора му ♀️♀️ pic.twitter.com/k5FZx4P7sK

– Nicole Estella Matovu (@NicEstelle) May 6, 2023

Изпълнението на етичната рамка на Клод е експериментално. ChatGPT на OpenAI, която също има за цел да избягва неетични подкани, е дала смесени резултати. И все пак, усилията за справяне с етичната злоупотреба с чатботове, демонстрирани от Anthropic, са забележителна крачка в индустрията на изкуствения интелект.

Етичното обучение на Клод го насърчава да избира отговори, които съответстват на неговата конституция, като се фокусира върху подкрепата на свободата, равенството, чувството за братство и зачитането на индивидуалните права. Но може ли ИИ постоянно да избира етични отговори? Каплан смята, че технологията е по-напреднала, отколкото мнозина предполагат. „Това просто функционира по прост начин“, каза той на семинара MLSys в Станфорд миналата седмица. „Тази безвредност се подобрява, докато преминавате през този процес.“

Съотношение между полезност и безвредност на модел, използващ конституционен изкуствен интелект (сиво), спрямо стандартните методи (цветове). Снимка: Снимка: Anthropic

Клод от Anthropic ни напомня, че развитието на ИИ не е просто технологична надпревара, а философско пътуване. Не става въпрос само за създаването на по-„интелигентен“ ИИ – за изследователите на ръба на развитието става въпрос за създаването на ИИ, който разбира тънката линия, разделяща правилното от погрешното.