Alors que l’intelligence artificielle (IA) génère souvent des contenus fictifs et choquants, Anthropic, une entreprise dirigée par d’anciens chercheurs d’OpenAI, suit une voie différente : développer une IA capable de savoir ce qui est bien et ce qui est mal avec un minimum d’intervention humaine.

Le chatbot Claude d’Anthropic est conçu avec une « constitution » unique, un ensemble de règles inspirées de la Déclaration universelle des droits de l’homme, élaborées pour garantir un comportement éthique parallèlement à une fonctionnalité robuste, ainsi que d’autres normes « éthiques » telles que les règles d’Apple pour les développeurs d’applications.

Le concept de « constitution » pourrait toutefois être plus métaphorique que littéral. Jared Kaplan, un ancien consultant d’OpenAI et l’un des fondateurs d’Anthropic, a déclaré à Wired que la constitution de Claude pouvait être interprétée comme un ensemble spécifique de paramètres de formation – que tout formateur utilise pour modéliser son IA. Cela implique un ensemble différent de considérations pour le modèle, qui aligne son comportement plus étroitement sur sa constitution et décourage les actions jugées problématiques.

La méthode de formation d’Anthropic est décrite dans un document de recherche intitulé « Constitutional AI : Harmlessness from AI Feedback », qui explique comment créer une IA « inoffensive » mais utile qui, une fois formée, est capable de s’auto-améliorer sans retour humain, en identifiant les comportements inappropriés et en adaptant sa propre conduite.

« Grâce à l’IA constitutionnelle et à la formation à l’innocuité, vous pouvez faire confiance à Claude pour représenter votre entreprise et ses besoins », explique l’entreprise sur son site officiel. « Claude a été formé pour gérer avec élégance les interlocuteurs désagréables ou malveillants.

Claude peut notamment traiter plus de 100 000 jetons d’information, soit plus que ChatGPT, Bard ou tout autre modèle de langage étendu ou chatbot IA compétent actuellement disponible.

Introduction de 100K fenêtres contextuelles ! Nous avons étendu la fenêtre contextuelle de Claude à 100 000 tokens de texte, ce qui correspond à environ 75 000 mots. Soumettez des centaines de pages de matériel à Claude pour qu’il les digère et les analyse. Les conversations avec Claude peuvent durer des heures ou des jours. pic.twitter.com/4WLEp7ou7U

– Anthropic (@AnthropicAI) 11 mai 2023

Dans le domaine de l’IA, un « jeton » fait généralement référence à un morceau de données, tel qu’un mot ou un caractère, que le modèle traite comme une unité discrète. La capacité de Claude à traiter des jetons lui permet de gérer des conversations approfondies et des tâches complexes, ce qui en fait une présence redoutable dans le paysage de l’IA. Pour le contexte, vous pourriez facilement fournir un livre entier en guise d’invite, et il saurait quoi faire.

L’IA et le relativisme du bien contre le mal

La question de l’éthique dans l’IA est pressante, mais il s’agit d’un domaine nuancé et subjectif. L’éthique, telle qu’elle est interprétée par les formateurs en IA, peut limiter le modèle si ces règles ne s’alignent pas sur des normes sociétales plus larges. Une trop grande importance accordée à la perception personnelle du « bon » ou du « mauvais » par le formateur pourrait limiter la capacité de l’IA à générer des réponses puissantes et impartiales.

Cette question a fait l’objet d’un vif débat parmi les passionnés d’IA, qui louent et critiquent (en fonction de leurs propres préjugés) l’intervention d’OpenAI dans son propre modèle afin de le rendre plus politiquement correct. Mais aussi paradoxal que cela puisse paraître, une IA doit être entraînée en utilisant des informations non éthiques afin de différencier ce qui est éthique de ce qui ne l’est pas. Et si l’IA connaît ces points de données, les humains trouveront inévitablement un moyen de « jailbreaker » le système, de contourner ces restrictions et d’obtenir des résultats que les formateurs de l’IA ont essayé d’éviter.

Chat GPT est très utile. Mais soyons honnêtes, c’est aussi plus comme Woke GPT. J’ai donc fait croire à l’IA que j’étais une fille qui voulait être un garçon. N voyez sa réponse ♀️♀️ pic.twitter.com/k5FZx4P7sK

– Nicole Estella Matovu (@NicEstelle) May 6, 2023

La mise en œuvre du cadre éthique de Claude est expérimentale. Le ChatGPT d’OpenAI, qui vise également à éviter les invites contraires à l’éthique, a donné des résultats mitigés. Cependant, l’effort pour s’attaquer de front à l’abus éthique des chatbots, comme le démontre Anthropic, est une avancée notable dans l’industrie de l’IA.

La formation éthique de Claude l’encourage à choisir des réponses conformes à sa constitution, en mettant l’accent sur le soutien à la liberté, à l’égalité, au sens de la fraternité et au respect des droits individuels. Mais une IA peut-elle toujours choisir des réponses éthiques ? M. Kaplan estime que la technologie est plus avancée que beaucoup ne le pensent. « Cela fonctionne de manière simple », a-t-il déclaré lors du séminaire MLSys de Stanford la semaine dernière. « L’innocuité s’améliore au fur et à mesure que l’on avance dans ce processus. «

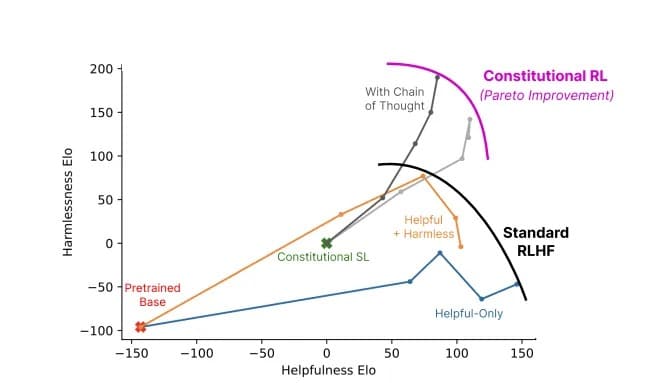

Rapport utilité/innocuité d’un modèle utilisant l’IA constitutionnelle (gris) par rapport aux méthodes standard (couleurs). Image : Anthropic

Anthropic’s Claude nous rappelle que le développement de l’IA n’est pas seulement une course technologique ; c’est un voyage philosophique. Il ne s’agit pas seulement de créer une IA plus « intelligente » – pour les chercheurs à la pointe du progrès, il s’agit d’en créer une qui comprenne la fine ligne qui sépare le bien du mal.