Enthusiasten der künstlichen Intelligenz arbeiten lieber mit Open-Source-Tools als mit proprietären kommerziellen, wie eine aktuelle Umfrage unter mehr als 100.000 Befragten ergab.

Das Auftauchen von Mistral AI’s Mixtral 8x7B, einem Open-Source-Modell, hat einen bedeutenden Einfluss auf den KI-Bereich. Das leichte und leistungsstarke Modell wurde von TCN unter die besten LLMs des Jahres 2023 gewählt. Mixtral hat viel Aufmerksamkeit für seine bemerkenswerte Leistung in verschiedenen Benchmark-Tests erlangt, insbesondere in der Chatbot Arena, die einen einzigartigen menschenzentrierten Ansatz zur Bewertung von LLMs bietet.

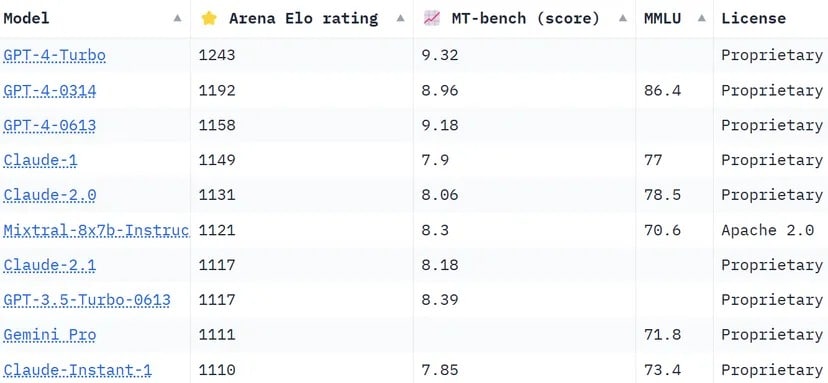

Die Chatbot-Arena-Rangliste, eine Crowdsourced-Liste, nutzt über 130.000 Nutzerstimmen, um Elo-Bewertungen für KI-Modelle zu berechnen. Im Vergleich zu anderen Methoden, die versuchen, die Ergebnisse zu standardisieren, um objektiver zu sein, entscheidet sich die Arena für einen „menschlicheren“ Ansatz und bittet die Menschen, blind zwischen zwei Antworten zu wählen, die von nicht identifizierten LLMS gegeben werden. Diese Antworten mögen nach bestimmten Maßstäben unkonventionell erscheinen, können aber von tatsächlichen menschlichen Nutzern intuitiv bewertet werden.

Mixtral hat einen beeindruckenden Ruf und übertrifft Branchenriesen wie Claude 2.1 von Anthropíc, GPT-3.5 von OpenAI, das die kostenlose Version von ChatGPT antreibt, und Gemini von Google, ein multimodaler LLM, der als der leistungsfähigste Chatbot verkauft wurde, um die Vorherrschaft von GPT-4 herauszufordern.

Chatbot Arena’s ranking. LLM von Mistral AI belegt Platz 6 in der Liste. Bild: Huggingface

Eines der bemerkenswerten Unterscheidungsmerkmale von Mixtral ist, dass es der einzige Open-Source-LLM in den Top 10 der Chatbot Arena ist. Diese Auszeichnung ist nicht nur eine Frage des Rankings, sondern steht für einen bedeutenden Wandel in der KI-Branche hin zu leichter zugänglichen und von der Gemeinschaft getragenen Modellen. Wie von TCN berichtet, sagte Mistral AI, dass sein Modell „LlaMA 2 70B bei den meisten Benchmarks mit 6x schnellerer Inferenz übertrifft und GPT 3.5 bei den meisten Standard-Benchmarks entspricht oder übertrifft“, wie MMLU, Arc-C oder GSM.

Das Geheimnis hinter dem Erfolg von Mixtral liegt in seiner ‚Mixture of Experts‘ (MoE) Architektur. Bei dieser Technik werden mehrere virtuelle Expertenmodelle eingesetzt, die jeweils auf ein bestimmtes Thema oder Gebiet spezialisiert sind. Wenn Mixtral mit einem Problem konfrontiert wird, wählt es die relevantesten Experten aus seinem Pool aus, was zu genaueren und effizienteren Ergebnissen führt.

„Auf jeder Ebene wählt ein Routernetzwerk für jeden Token zwei dieser Gruppen (die ‚Experten‘) aus, um den Token zu verarbeiten und ihre Ergebnisse additiv zu kombinieren“, erklärt Mistral in der kürzlich veröffentlichten Arbeit des LLM. „Diese Technik erhöht die Anzahl der Parameter eines Modells bei gleichzeitiger Kontrolle der Kosten und der Latenzzeit, da das Modell nur einen Bruchteil des gesamten Parametersatzes pro Token verwendet.“

Darüber hinaus zeichnet sich Mixtral durch seine mehrsprachige Kompetenz aus. Das Modell ist in Sprachen wie Französisch, Deutsch, Spanisch, Italienisch und Englisch hervorragend, was seine Vielseitigkeit und sein weitreichendes Potenzial unterstreicht. Der Open-Source-Charakter des Modells unter der Apache 2.0-Lizenz ermöglicht es den Entwicklern, das Modell frei zu erforschen, zu verändern und zu verbessern, und fördert so ein kollaboratives und innovatives Umfeld.

Der Erfolg von Mixtral ist eindeutig nicht nur auf technologische Fähigkeiten zurückzuführen; er markiert einen kleinen, aber wichtigen Sieg für die Open-Source-KI-Gemeinschaft. Vielleicht wird es in nicht allzu ferner Zukunft nicht mehr darum gehen, welches Modell zuerst da war oder über mehr Parameter oder Kontextfähigkeiten verfügt, sondern darum, welches Modell bei den Menschen wirklich ankommt.