Энтузиасты искусственного интеллекта предпочитают работать с инструментами с открытым исходным кодом, а не с проприетарными коммерческими, согласно результатам опроса, в котором приняли участие более 100 000 респондентов.

Появление Mixtral AI Mixtral 8x7B, модели с открытым исходным кодом, оказало значительное влияние на пространство ИИ. Легкий и мощный, TCN назвал его в числе лучших LLM 2023 года. Mixtral привлек к себе внимание благодаря своим выдающимся результатам в различных бенчмарк-тестах, особенно в Chatbot Arena, который предлагает уникальный человеко-ориентированный подход к оценке LLM.

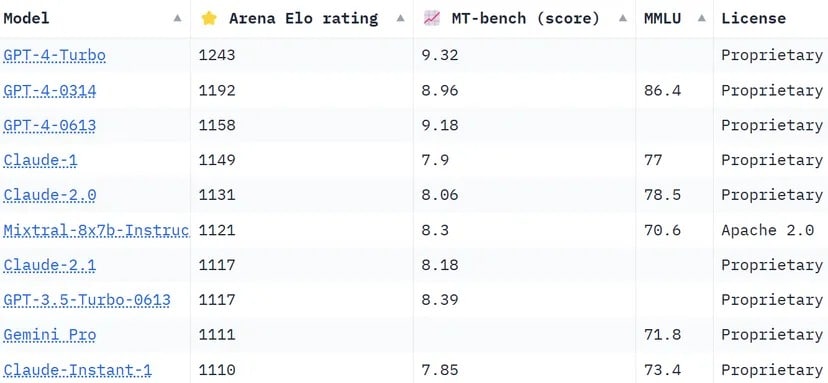

Рейтинг Chatbot Arena — это краудсорсинговый список, который использует более 130 000 пользовательских голосов для расчета рейтинга Эло для моделей ИИ. По сравнению с другими методами, которые пытаются стандартизировать результаты, чтобы быть более объективными, «Арена» выбирает более «человеческий» подход, предлагая людям вслепую выбрать один из двух ответов, предоставленных неопознанными LLMS. Эти ответы могут показаться нетрадиционными по определенным стандартам, но могут быть интуитивно оценены реальными пользователями.

Mixtral имеет впечатляющие позиции, превосходя такие гиганты индустрии, как Claude 2.1 от Anthropíc, GPT-3.5 от OpenAI, на котором основана бесплатная версия ChatGPT, и Gemini от Google, мультимодальный LLM, который продавался как самый мощный чатбот, способный бросить вызов доминированию GPT-4.

Рейтинг Chatbot Arena. LLM от Mistral AI занимает 6 место в списке. Изображение: Huggingface

Одним из заметных отличий Mixtral является то, что это единственный LLM с открытым исходным кодом в топ-10 Chatbot Arena. Это отличие — не просто вопрос рейтинга; оно представляет собой значительный сдвиг в индустрии ИИ в сторону более доступных и управляемых сообществом моделей. Как сообщает TCN, Mistral AI заявила, что ее модель «превосходит LlaMA 2 70B в большинстве бенчмарков с 6-кратным ускорением вывода и соответствует или превосходит GPT 3.5 в большинстве стандартных бенчмарков», таких как MMLU, Arc-C или GSM.

Секрет успеха Mixtral кроется в архитектуре «смеси экспертов» (MoE). Эта технология использует несколько виртуальных экспертных моделей, каждая из которых специализируется на определенной теме или области. При столкновении с проблемой Mixtral выбирает наиболее подходящих экспертов из своего пула, что приводит к более точным и эффективным результатам.

На каждом уровне для каждого маркера сеть маршрутизаторов выбирает две такие группы («экспертов») для обработки маркера и аддитивного объединения их результатов», — объясняет Мистраль в недавно опубликованной работе LLM. «Эта техника увеличивает количество параметров модели, контролируя при этом стоимость и задержку, поскольку модель использует только часть общего набора параметров на один токен».

Кроме того, Mixtral выделяется своей многоязычностью. Модель отлично работает на таких языках, как французский, немецкий, испанский, итальянский и английский, демонстрируя свою универсальность и широкий потенциал. Ее открытый исходный код под лицензией Apache 2.0 позволяет разработчикам свободно исследовать, изменять и улучшать модель, способствуя развитию сотрудничества и инновационной среды.

Успех Mixtral, несомненно, связан не только с технологическим мастерством; он знаменует собой небольшую, но важную победу сообщества ИИ с открытым исходным кодом. Возможно, в недалеком будущем вопрос будет стоять не о том, какая модель появилась первой, у какой из них больше параметров или контекстных возможностей, а о том, какая из них действительно находит отклик у людей.