Os entusiastas da inteligência artificial preferem trabalhar com ferramentas de código aberto em vez de ferramentas comerciais proprietárias, de acordo com um inquérito em curso a mais de 100 000 inquiridos.

O aparecimento do Mixtral 8x7B da Mistral AI, um modelo de código aberto, teve um impacto significativo no espaço da IA. Leve e poderoso, o TCN nomeou-o entre os Melhores LLMs de 2023. O Mixtral ganhou muita atenção por seu desempenho notável em vários testes de benchmark, especialmente o Chatbot Arena, que oferece uma abordagem única centrada no ser humano para avaliar LLMs.

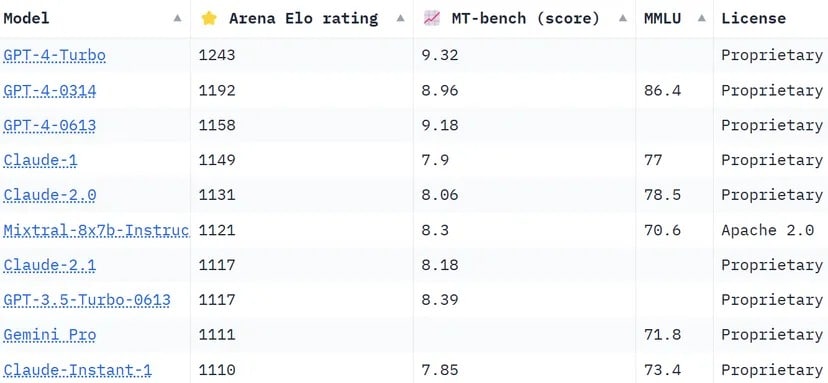

As classificações do Chatbot Arena, uma lista de crowdsourcing, utilizam mais de 130 000 votos de utilizadores para calcular as classificações Elo dos modelos de IA. Em comparação com outros métodos que tentam padronizar os resultados para serem mais objectivos, a arena opta por uma abordagem mais “humana”, pedindo às pessoas que escolham entre duas respostas fornecidas por LLMS não identificados às cegas. Estas respostas podem parecer pouco convencionais segundo certos padrões, mas podem ser avaliadas intuitivamente por utilizadores humanos reais.

O Mixtral tem uma posição impressionante, ultrapassando gigantes da indústria como o Claude 2.1 da Anthropíc, o GPT-3.5 da OpenAI, que alimenta a versão gratuita do ChatGPT e o Gemini da Google, um LLM multimodal que foi vendido como o chatbot mais poderoso para desafiar o domínio do GPT-4.

Classificação da Chatbot Arena. O LLM da Mistral AI ocupa o 6º lugar na lista. Imagem: Huggingface

Um dos diferenciais notáveis da Mixtral é ser o único LLM de código aberto no top 10 da Chatbot Arena. Esta distinção não é apenas uma questão de classificação; representa uma mudança significativa na indústria da IA para modelos mais acessíveis e orientados para a comunidade. Conforme relatado pela TCN, a Mistral AI disse que seu modelo “supera o LlaMA 2 70B na maioria dos benchmarks com inferência 6x mais rápida e corresponde ou supera o GPT 3.5 na maioria dos benchmarks padrão”, como MMLU, Arc-C ou GSM.

O segredo do sucesso do Mixtral reside na sua arquitetura “Mixture of Experts” (MoE). Esta técnica utiliza vários modelos de peritos virtuais, cada um especializado num tópico ou domínio distinto. Quando confrontada com um problema, a Mixtral selecciona os peritos mais relevantes do seu conjunto, o que conduz a resultados mais precisos e eficientes.

“Em cada camada, para cada token, uma rede de roteadores escolhe dois desses grupos (os ‘especialistas’) para processar o token e combinar seus resultados aditivamente”, explicou Mistral no artigo publicado recentemente pelo LLM. “Esta técnica aumenta o número de parâmetros de um modelo, ao mesmo tempo que controla o custo e a latência, uma vez que o modelo utiliza apenas uma fração do conjunto total de parâmetros por ficha.”

Além disso, o Mixtral destaca-se pela sua proficiência multilingue. O modelo é excelente em línguas como o francês, o alemão, o espanhol, o italiano e o inglês, o que demonstra a sua versatilidade e o seu vasto potencial. A sua natureza de código aberto, ao abrigo da licença Apache 2.0, permite aos programadores explorar, modificar e melhorar livremente o modelo, promovendo um ambiente de colaboração e inovação.

O sucesso do Mixtral não se resume claramente a proezas tecnológicas; marca uma pequena mas importante vitória para a comunidade de IA de código aberto. Talvez, num futuro não muito distante, a questão não seja saber qual o modelo que veio primeiro, ou qual o que tem mais parâmetros ou capacidades de contexto, mas sim qual o que verdadeiramente tem impacto nas pessoas.