Entuzjaści sztucznej inteligencji wolą pracować z narzędziami open-source niż z zastrzeżonymi narzędziami komercyjnymi, wynika z trwającej ankiety przeprowadzonej wśród ponad 100 000 respondentów.

Pojawienie się Mixtral 8x7B firmy Mistral AI, modelu open-source, wywarło znaczący wpływ na przestrzeń sztucznej inteligencji. Lekki i potężny, TCN wymienił go wśród najlepszych LLM 2023 roku. Mixtral zyskał wiele uwagi dzięki swojej niezwykłej wydajności w różnych testach porównawczych, zwłaszcza Chatbot Arena, która oferuje unikalne, zorientowane na człowieka podejście do oceny LLM.

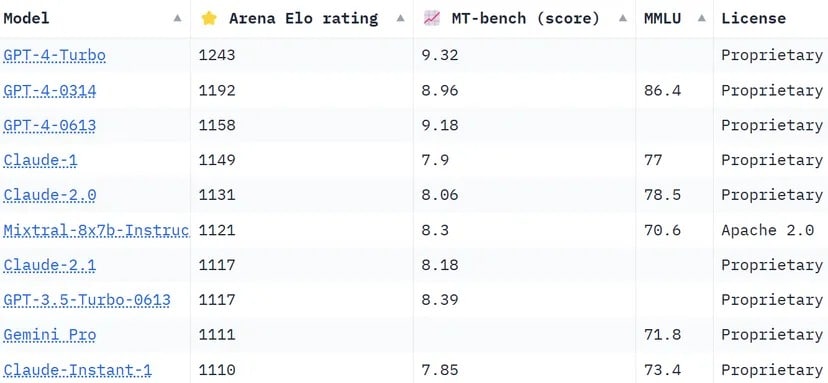

Rankingi Chatbot Arena, lista crowdsourcingowa, wykorzystują ponad 130 000 głosów użytkowników do obliczania ocen Elo dla modeli AI. W porównaniu do innych metod, które próbują standaryzować wyniki, aby były bardziej obiektywne, arena wybiera bardziej „ludzkie” podejście, prosząc ludzi o wybór między dwiema odpowiedziami dostarczonymi przez niezidentyfikowane LLMS na ślepo. Odpowiedzi te mogą wydawać się niekonwencjonalne według pewnych standardów, ale mogą być intuicyjnie oceniane przez rzeczywistych użytkowników.

Mixtral ma imponującą pozycję, przewyższając gigantów branży, takich jak Claude 2.1 firmy Anthropíc, GPT-3.5 firmy OpenAI, który zasila darmową wersję ChatGPT i Gemini firmy Google, multimodalny LLM, który był sprzedawany jako najpotężniejszy chatbot, aby rzucić wyzwanie dominacji GPT-4.

Ranking Chatbot Arena. LLM firmy Mistral AI zajmuje 6 miejsce na liście. Zdjęcie: Huggingface

Jednym z godnych uwagi wyróżników Mixtral jest bycie jedynym open-source’owym LLM w top 10 Chatbot Arena. Wyróżnienie to nie jest tylko kwestią rankingu; reprezentuje ono znaczącą zmianę w branży sztucznej inteligencji w kierunku bardziej dostępnych i opartych na społeczności modeli. Jak donosi TCN, Mistral AI twierdzi, że jego model „przewyższa LlaMA 2 70B w większości testów porównawczych z 6-krotnie szybszym wnioskowaniem i dorównuje lub przewyższa GPT 3.5 w większości standardowych testów porównawczych”, takich jak MMLU, Arc-C czy GSM.

Tajemnica sukcesu Mixtral tkwi w architekturze „Mixture of Experts” (MoE). Technika ta wykorzystuje wiele wirtualnych modeli eksperckich, z których każdy specjalizuje się w innym temacie lub dziedzinie. W obliczu problemu, Mixtral wybiera najbardziej odpowiednich ekspertów ze swojej puli, co prowadzi do bardziej dokładnych i wydajnych wyników.

„Na każdej warstwie, dla każdego tokena, sieć routerów wybiera dwie z tych grup („ekspertów”), aby przetworzyć token i połączyć ich wyniki addytywnie” – wyjaśnia Mistral w niedawno opublikowanym artykule LLM. „Technika ta zwiększa liczbę parametrów modelu, jednocześnie kontrolując koszty i opóźnienia, ponieważ model wykorzystuje tylko ułamek całkowitego zestawu parametrów na token”.

Co więcej, Mixtral wyróżnia się wielojęzyczną biegłością. Model ten wyróżnia się w językach takich jak francuski, niemiecki, hiszpański, włoski i angielski, pokazując swoją wszechstronność i szeroki potencjał. Jego charakter open-source, na licencji Apache 2.0, pozwala programistom swobodnie odkrywać, modyfikować i ulepszać model, wspierając współpracę i innowacyjne środowisko.

Sukces Mixtral wyraźnie nie dotyczy tylko sprawności technologicznej; oznacza to małe, ale ważne zwycięstwo społeczności open source AI. Być może w nie tak odległej przyszłości pytanie nie będzie dotyczyło tego, który model powstał jako pierwszy lub który ma więcej parametrów lub możliwości kontekstowych, ale tego, który naprawdę rezonuje z ludźmi.