Ентусиастите в областта на изкуствения интелект предпочитат да работят с инструменти с отворен код пред патентовани комерсиални такива, сочи текущо проучване, проведено сред повече от 100 000 респонденти.

Появата на Mixtral 8x7B на Mistral AI, модел с отворен код, оказа значително влияние в областта на ИИ. Лек и мощен, TCN го посочи сред най-добрите модели на LLM за 2023 г. Mixtral привлече голямо внимание заради забележителното си представяне в различни сравнителни тестове, особено Chatbot Arena, който предлага уникален човекоцентричен подход за оценка на LLM.

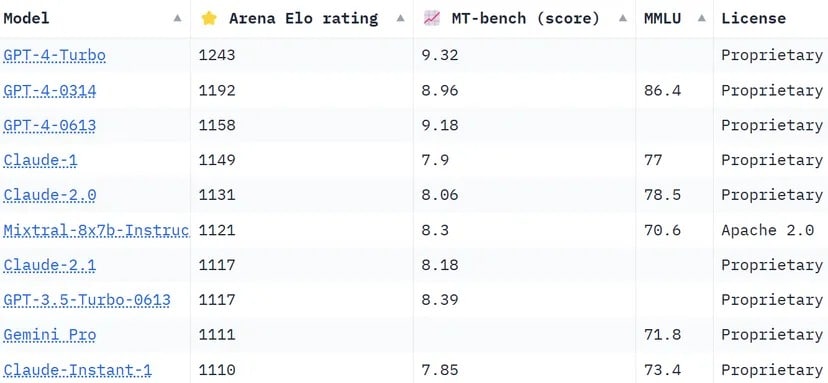

Класацията Chatbot Arena, списък, съставен от тълпата, използва над 130 000 потребителски гласа, за да изчисли Elo рейтингите за моделите на ИИ. В сравнение с други методи, които се опитват да стандартизират резултатите, за да бъдат по-обективни, Арената избира по-„човешки“ подход, като иска от хората да избират между два отговора, предоставени от неидентифицирани LLMS на сляпо. Тези отговори могат да изглеждат нетрадиционни според определени стандарти, но могат да бъдат оценени интуитивно от действителни човешки потребители.

Mixtral има впечатляващ авторитет, надминавайки гиганти в бранша като Claude 2.1 на Anthropíc, GPT-3.5 на OpenAI, който захранва безплатната версия на ChatGPT, и Gemini на Google, мултимодален LLM, който се продаваше като най-мощния чатбот, за да оспори доминацията на GPT-4.

Класация на Chatbot Arena. LLM на Mistral AI заема 6-то място в списъка. Снимка: MITH Huggingface

Едно от забележителните отличия на Mixtral е, че е единственият LLM с отворен код в топ 10 на Chatbot Arena. Това отличие не е просто въпрос на класиране; то представлява значителна промяна в индустрията на изкуствения интелект към по-достъпни и управлявани от общността модели. Както се съобщава от TCN, Mistral AI заяви, че неговият модел „превъзхожда LlaMA 2 70B в повечето бенчмаркове с 6 пъти по-бърз извод и съвпада или превъзхожда GPT 3.5 в повечето стандартни бенчмаркове.“ като MMLU, Arc-C или GSM.

Тайната на успеха на Mixtral се крие в неговата архитектура „Mixture of Experts“ (MoE). Тази техника използва множество виртуални експертни модели, всеки от които е специализиран в отделна тема или област. Когато се сблъска с даден проблем, Mixtral избира най-подходящите експерти от своя пул, което води до по-точни и ефективни резултати.

„На всеки слой, за всеки символ, маршрутизиращата мрежа избира две от тези групи („експерти“), които да обработят символа и да комбинират адитивно техните резултати“, обяснява Мистрал в наскоро публикувания документ на LLM. „Тази техника увеличава броя на параметрите на модела, като същевременно контролира разходите и латентността, тъй като моделът използва само част от общия набор от параметри за един токен.“

Освен това Mixtral се отличава със своята многоезична компетентност. Моделът се справя отлично с езици като френски, немски, испански, италиански и английски, което показва неговата гъвкавост и широкообхватен потенциал. Неговият характер на отворен код, съгласно лиценза Apache 2.0, позволява на разработчиците свободно да изследват, променят и подобряват модела, като насърчава съвместната и иновативна среда.

Успехът на Mixtral очевидно не е свързан само с технологични постижения; той бележи малка, но важна победа за общността на ИИ с отворен код. Може би в едно не толкова далечно бъдеще въпросът няма да бъде кой модел се е появил пръв или кой има повече параметри или контекстуални възможности, а кой наистина намира отклик сред хората.